ТРАНСФОРМАТОРЫ. РАСШИФРОВКА НАИМЕНОВАНИЙ

Наименование (а точнее, номенклатура) трансформатора, говорит о его конструктивных особенностях и параметрах. При умении читать наименование оборудования можно только по нему узнать количество обмоток и фаз силового трансформатора, тип охлаждения, номинальную мощность и напряжение высшей обмотки.

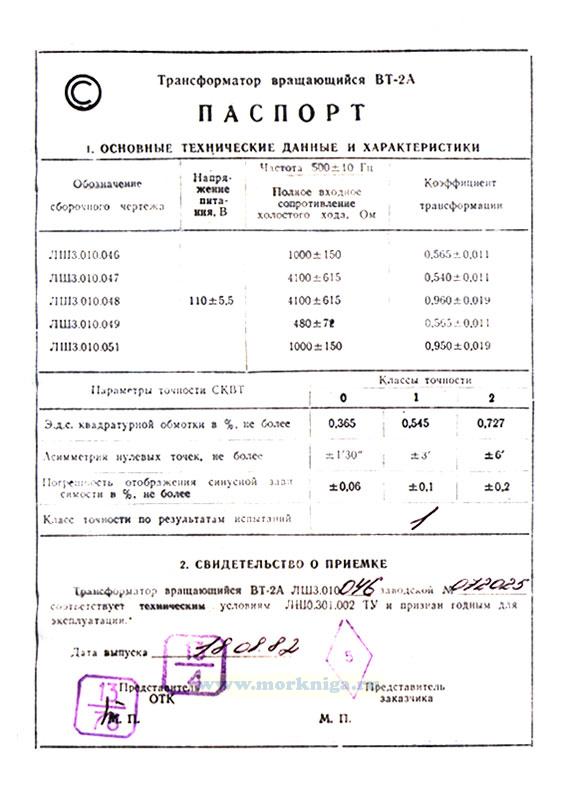

ОБЩИЕ РЕКОМЕНДАЦИИНоменклатура трансформаторов (расшифровка буквенных и цифровых обозначений наименования) не регламентируется какими-либо нормативными документами, а всецело определяется производителем оборудования. Поэтому, если название Вашего трансформатора не поддаётся расшифровке, то обратитесь к его производителю или посмотрите паспорт изделия. Приведенные ниже расшифровки букв и цифр названия трансформаторов актуальны для отечественных изделий.

Наименование трансформатора состоит из букв и цифр, каждая из которых имеет своё значение. При расшифровке наименования следует учитывать то что некоторые из них могут отсутствовать в нём вообще (например буква «А» в наименовании обычного трансформатора), а другие являются взаимоисключающими (например, буквы «О» и «Т»).

Для силовых трансформаторов приняты следующие буквенные обозначения:

Таблица 1 — Расшифровка буквенных и цифровых обозначений наименования силового трансформатора

Примечание: принудительная циркуляция воздуха называется дутьем, то есть «с принудительной циркуляцией воздуха» и «с дутьем» равнозначные выражения.

ПРИМЕРЫ РАСШИФРОВКИ НАИМЕНОВАНИЙ СИЛОВЫХ ТРАНСФОРМАТОРОВ

ТМ — 100/35 — трансформатор трёхфазный масляный с естественной циркуляцией воздуха и масла, номинальной мощностью 0,1 МВА, классом напряжения 35 кВ;

ТДНС — 10000/35 — трансформатор трёхфазный с дутьем масла, регулируемый под нагрузкой для собственных нужд электростанции, номинальной мощностью 10 МВА, классом напряжения 35 кВ;

ТРДНФ — 25000/110 — трансформатор трёхфазный, с расщеплённой обмоткой, масляный с принудительной циркуляцией воздуха, регулируемый под нагрузкой, с расширителем, номинальной мощностью 25 МВА, классом напряжения 110 кВ;

АТДЦТН — 63000/220/110 — автотрансформатор трёхфазный, масляный с дутьём и принудительной циркуляцией масла, трёхобмоточный, регулируемый под нагрузкой, номинальной мощностью 63 МВА, класс ВН — 220 кВ, класс СН — 110 кВ;

АОДЦТН — 333000/750/330 — автотрансформатор однофазный, масляный с дутьём и принудительной циркуляцией масла, трёхобмоточный, регулируемый под нагрузкой, номинальной мощностью 333 МВА, класс ВН — 750 кВ, класс СН — 500 кВ.

Для регулировочных трансформаторов приняты следующие сокращения:

Таблица 2 — Расшифровка буквенных и цифровых обозначений наименования регулировочного трансформатора

ПРИМЕРЫ РАСШИФРОВКИ НАИМЕНОВАНИЙ РЕГУЛИРОВОЧНЫХ ТРАНСФОРМАТОРОВ

ВРТДНУ — 180000/35/35 — трансформатор вольтодобавочный, регулировочный, трёхфазный, с масляным охлаждением типа Д, регулируемый под нагрузкой, с усиленным вводом, проходной мощностью 180 МВА, номинальное напряжение обмотки возбуждения 35 кВ, номинальное напряжения регулировочной обмотки 35 кВ;

ЛТМН — 160000/10 — трансформатор линейный, трёхфазный, с естественной циркуляцией масла и воздуха, регулируемый под нагрузкой, проходной мощностью 160 МВА, номинальным линейным напряжением 10 кВ.

РАСШИФРОВКА НАИМЕНОВАНИЙ ТРАНСФОРМАТОРОВ НАПРЯЖЕНИЯ

Для трансформаторов напряжения приняты следующие сокращения:

Таблица 3 — Расшифровка буквенных и цифровых обозначений наименования трансформатора напряжения

Примечание:

Комплектующий для серии НОСК;

С компенсационной обмоткой для серии НТМК;

Кроме серии НОЛ и ЗНОЛ, в которых:

— 06 — для встраивания в закрытые токопроводы, ЗРУ и КРУ внутренней установки;

— 08 — для ЗРУ и КРУ внутренней и наружной установки;

— 11 — для взрывоопасных КРУ.

ПРИМЕРЫ РАСШИФРОВКИ НАИМЕНОВАНИЙ ТРАНСФОРМАТОРОВ НАПРЯЖЕНИЯ

НОСК-3-У5 — трансформатор напряжения однофазный с сухой изоляцией, комплектующий, номинальное напряжение обмотки ВН 3 кВ, климатическое исполнение — У5;

НОМ-15-77У1 — трансформатор напряжения однофазный с масляной изоляцией, номинальное напряжение обмотки ВН 15 кВ, 1977 года разработки, климатическое исполнение — У1;

ЗНОМ-15-63У2 — трансформатор напряжения с заземляемым концом обмотки ВН, однофазный с масляной изоляцией, номинальное напряжение обмотки ВН 15 кВ, 1963 года разработки, климатическое исполнение — У2;

ЗНОЛ-06-6У3 — трансформатор напряжения с заземляемым концом обмотки ВН, однофазный с литой эпоксидной изоляцией, для встраивания в закрытые токопроводы, ЗРУ и КРУ внутренней установки, климатическое исполнение — У3;

НТС-05-УХЛ4 — трансформатор напряжения трёхфазный с сухой изоляцией, номинальное напряжение обмотки ВН 0,5 кВ, климатическое исполнение — УХЛ4;

НТМК-10-71У3 — трансформатор напряжения трёхфазный с масляной изоляцией и компенсационной обмоткой, номинальное напряжение обмотки ВН 10 кВ, 1971 года разработки, климатическое исполнение — У3;

НТМИ-10-66У3 — трансформатор напряжения трёхфазный с масляной изоляцией и обмоткой для контроля изоляции сети, номинальное напряжение обмотки ВН 10 кВ, 1966 года разработки, климатическое исполнение — У3;

НКФ-110-58У1 — трансформатор напряжения каскадный в фарфоровой покрышке, номинальное напряжение обмотки ВН 110 кВ, 1958 года разработки, климатическое исполнение — У1;

НДЕ-500-72У1 — трансформатор напряжения с ёмкостным делителем, номинальное напряжение обмотки ВН 500 кВ, 1972 года разработки, климатическое исполнение — У1;

РАСШИФРОВКА НАИМЕНОВАНИЙ ТРАНСФОРМАТОРОВ ТОКА

Для трансформаторов тока приняты следующие сокращения:

Таблица 4 — Расшифровка буквенных и цифровых обозначений наименования трансформатора тока

Примечание:

Для серии ТВ, ТВТ, ТВС, ТВУ;

Для серии ТНП, ТНПШ — с подмагничиванием переменным током;

Для серии ТШВ, ТВГ;

Для ТВВГ — 24 — водяное охлаждение;

Для серии ТНП, ТНПШ;

Для серии ТВ, ТВТ, ТВС, ТВУ — номинальное напряжения оборудования;

Для серии ТНП, ТНПШ — число обхватываемых жил кабеля;

Для серии ТНП, ТНПШ — номинальное напряжение.

ПРИМЕРЫ РАСШИФРОВКИ НАИМЕНОВАНИЙ ТРАНСФОРМАТОРОВ ТОКА

ТФЗМ — 35А — У1 — трансформатор тока в фарфоровой покрышке, с обмоткой звеньевого исполнения, с масляной изоляцией, номинальным напряжением обмотки ВН 35 кВ, категории А, климатическим исполнением У1;

ТФРМ — 750М — У1 — трансформатор тока в фарфоровой покрышке, с обмоткой рымочного исполнения, с масляной изоляцией, номинальным напряжением обмотки ВН 750 кВ, климатическим исполнением У1;

ТШЛ — 10К — трансформатор тока шинный с литой изоляцией, номинальное напряжением обмотки ВН 10 кВ;

ТЛП — 10К — У3 — трансформатор тока с литой изоляцией, проходной, номинальным напряжением обмотки ВН 10 кВ, климатическое исполнение — У3;

ТПОЛ — 10 — трансформатор тока проходной, одновитковый, с литой изоляцией, номинальным напряжением обмотки ВН 10 кВ;

ТШВ — 15 — трансформатор тока шинный, с воздушным охлаждением, номинальным напряжением обмотки ВН 15 кВ;

ТВГ — 20 — I — трансформатор тока с воздушным охлаждением, генераторный, номинальным напряжением обмотки ВН 20 кВ;

ТШЛО — 20 — трансформатор тока шинный, с литой изоляцией, одновитковый, номинальным напряжением обмотки ВН 20 кВ;

ТВ — 35 — 40У2 — трансформатор тока встроенный, номинальным напряжением обмотки ВН 35 кВ, током термической стойкости 40 кА, климатическое исполнение — У2;

ТНП — 12 — трансформатор тока нулевой последовательности, с подмагничиванием переменным током, охватывающий 12 жил кабеля;

ТНПШ — 2 — 15 — трансформатор тока нулевой последовательности, с подмагничиванием переменным током, шинный, охватывающий 2 жилы кабеля, номинальным напряжением обмотки ВН 15 кВ.

Трансформаторы силовые масляные трехфазные класса напряжения 110 кВ

- Трансформаторы двухобмоточные с переключением ответвлений без возбуждения (ПБВ) на стороне ВН в диапазоне ± 2х2,5 % и без ПБВ, предназначены для передачи и распределения электроэнергии, а также для работы на электростанциях в блоке с генератором

- Трансформаторы двухобмоточные с переключением ответвлений под нагрузкой (РПН) на стороне ВН в диапазоне ± 9х1,78 % предназначены для передачи и распределения электроэнергии, а также для собственных нужд электростанций

- Трансформаторы трехобмоточные с переключением ответвлений под нагрузкой (РПН) на стороне ВН в диапазоне ± 9х1,78 % с регулированием напряжения на стороне СН без возбуждения (ПБВ) в диапазоне ± 2х2,5 % и без регулирования напряжения на сторое СН, предназначены для передачи и распределения электроэнергии

Опросные листы для всех трансформаторов

Параметры

(1)

| Серия | Номинальная мощность, кВА | Схема и группа соединения обмоток | Напряжение обмотки, кВ | |

ВН | НН | ||||

1 | ТМ-2500/110 | 2500 | YН/D-11 | 121 | 6,30; 10,5 |

2 | ТМ-4000/110 | 4000 | |||

3 | ТМ-6300/110 | 6300 | |||

4 | ТД-10000/110 | 10000 | |||

5 | ТД-16000/110 | 16000 | |||

6 | ТД-25000/110 | 25000 | |||

7 | ТД-32000/110 | 32000 | |||

8 | ТД-40000/110 | 40000 | 115; 121 | ||

9 | ТДЦ-63000/110 | 63000 | 121 | 10,5 | |

10 | ТДЦ-80000/110 | 80000 | 3,15;6,3; 10,5; 3,8 | ||

11 | ТДЦ-100000/110 |

| 10,5 | ||

12 | ТДЦ-125000/110 | 125000 | 10,5; 13,8 | ||

(2)

| Серия | Номинальная мощность, кВА | Схема и группа соединения обмоток | Напряжение обмотки, кВ | |

ВН | НН | ||||

13 | ТМН-2500/110* | 2500 | YН/D-11 | 110 | 6,6; 11,0 |

14 | ТМН-6300/110 | 6300 | 115 | 6,6; 10,5; 11,0; 16,5 | |

15 | ТДН-10000/110 | 10000 | 6,3; 6,6; 10,5; 11,0; 16,5; 22,0; 34,5 | ||

16 | ТДН-16000/110 | 16000 | 6,3; 6,6; 10,5; 11,0; 16,5; 22,0; 34,5; 38,5 | ||

17 | ТДН-25000/110 | 25000 | 6,3; 6,6; 10,5; 11,0; 16,5; 38,5 | ||

18 | ТДН-40000/110 | 40000 | 6,3; 10,5; 11,0; 38,5 | ||

YН/Y-0 | 38,5; 11 | ||||

19 | ТДН-63000/110 | 63000 | YН/D-11 | 38,5 | |

20 | ТДН-80000/110 | 63000 | |||

21 | ТРДН-25000/110 | 25000 | YН/D-D-11-11 | 6,3-6,3; 6,6-6,6; 10,5-10,5; 11,0-11,0; 6,3-10,5; 11,0-6,6 | |

22 | ТРДНС-25000/110 | ||||

23 | ТРДН-32000/110 | 32000 | 6,3-6,3 | ||

24 | ТРДН-40000/110 | 40000 | 6,3-6,3; 6,6-6,6; 10,5-10,5; 11,0-11,0; 6,3-10,5; 11,0-6,3; 11,0-6,6 | ||

25 | ТРДНС-40000/110 | ||||

26 | ТРДНР-40000/110 | 11,0-6,6 | |||

27 | ТРДН-63000/110 | 63000 | 6,3-6,3; 6,35-6,35; 6,6-6,6; 10,5-10,5; 11,0-11,0; 6,3-10,5 6,35-10,5; 11,0-6,6 | ||

28 | ТРДНС-63000/110 | ||||

29 | ТРДН-80000/110 | 80000 | 6,3; 6,65; 10,5; 10,5 | ||

30 | ТРДЦН-125000/110 | 125000 | YН/D-D-11-11 | 10,5-10,5 | |

* — Регулирование напряжения со стороны НН (+10х1,5 % -8х1,5 %)

(3)

| Серия | Номинальная мощность, кВА | Схема и группа соединения обмоток | Напряжение обмотки, кВ | ||

ВН | СН | НН | ||||

31 | ТМТН-6300/110 | 6300 | YН/D/D-11-11 | 115 | 16,5; 22,0 | 6,6; 11,0 |

YН/YН/D-0-11 | 38,5 | |||||

32 | ТДТН-10000/110 | 10000 | YН/D/D-11-11 | 16,5; 22,0 | 6,3; 6,6; 11 | |

YН/YН/D-0-11 | 34,5; 8,5 | |||||

33 | ТДТН-16000/110 | 16000 | YН/D/D-11-11 | 6,3; 10,5; 1,0; 22,0 | 6,3; 6,6; 11 | |

YН/YН/D-0-11 | 34,5; 38,5 | |||||

34 | ТДТН-25000/110 | 25000 | YН/D/D-11-11 | 11,0; 16,5 | 6,6 | |

38,5 | 11,0; 6,6 | |||||

10,5 | 10,5 | |||||

6,3 | 6,3 | |||||

22,0 | 6,6; 11,0 | |||||

YН/YН/D-0-11 | 34,5; 36,75; 38,5; | |||||

YН/D/Y-11-4 | 16,5 | 6,6 | ||||

35 | ТДТН-40000/110 | 40000 | YН/D/D-11-11 | 10,5 | 6,3 | |

11,0 | 6,6 | |||||

22,0 | 6,6; 11,0 | |||||

YН/YН/D-0-11 | 34,5; 38,5 | |||||

36 | ТДТН-63000/110 | 63000 | YН/D/D-11-11 YН/YН/D-0-11 | 11,0; 34,5 | 6,6 | |

38,5 | 6,6; 11,0 | |||||

37 | ТДТН-80000/110 | 80000 | YН/D/D-11-11 | 11,0 | 6,6 | |

YН/YН/D-0-11 | 38,5 | 6,6; 11,0 | ||||

38 | ТДЦТН-80000/110 | 80000 | YН/D/D-11-11 | 11,0 | 6,6 | |

YН/YН/D-0-11 | 38,5 | 6,6; 11,0 | ||||

Опросные листы ниже

1. на двухобмоточные

на двухобмоточные

2. на трехобмоточные

Прикрепленные файлы

Напишите нам

Трансформаторы

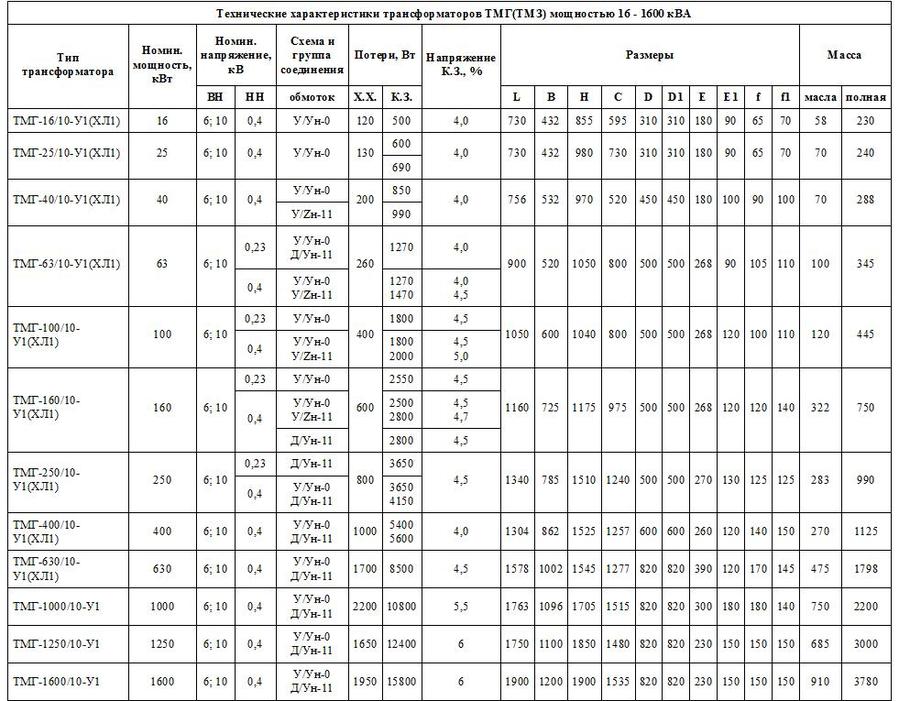

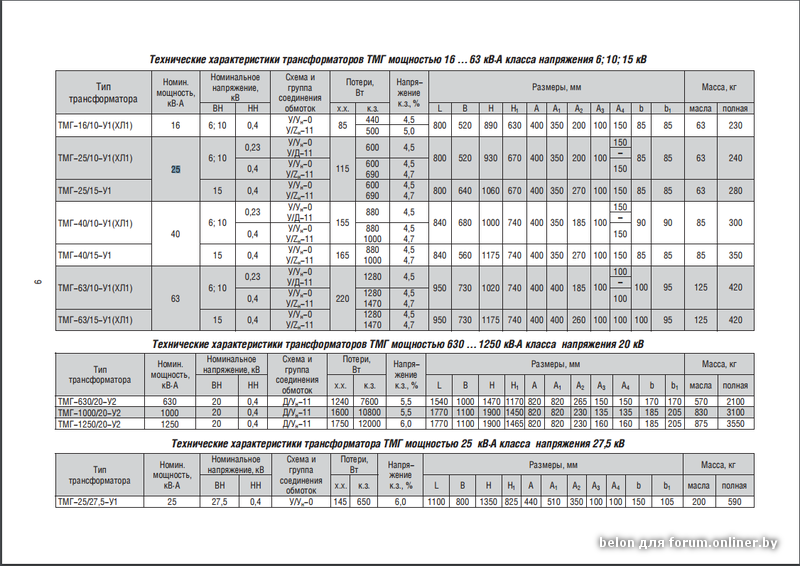

ТМ(Г) – это силовые трехфазные двухобмоточные трансформаторы. Они относится к трансформаторам понижающего типа на масляном охлаждении. ТМ(Г) преобразуют переменный ток и распределяют электроэнергию в различных электротехнических установках. Силовые трансформаторы делятся на понижающие и повышающие. Рассмотрим расшифровку обозначения силовых трансформаторов на примере ТМ(Г) — Т1\Т2\Т3 У/Ун-0:

- Т – трехфазный;

- М – охлаждается от окружающей среды, с использованием масла;

- (Г) – виды защиты масла: герметичные;

- Т1 – номинальная мощность;

- Т2/Т3– класс напряжения обмотки ВН и НН;

- У/Ун-0 – схема и группа соединения обмоток;

ТС(З)(Г)Л — это сухие силовые трансформаторы и не имеют масляного охладителя, его заменяет естественная среда. Они являются разновидностью силовых трансформаторов. Если вы решили купить сухой трансформатор – то сделали правильный выбор. Они могут быть установлены вблизи от потребителей, так как являются пожаробезопасными. К тому же сухой трансформатор меньше размером, чем маслянный. Рассмотрим расшифровку обозначения силовых трансформаторов на примере ТС(З)(Г)Л — Т1\Т2\Т3 Д/Ун-11:

Они являются разновидностью силовых трансформаторов. Если вы решили купить сухой трансформатор – то сделали правильный выбор. Они могут быть установлены вблизи от потребителей, так как являются пожаробезопасными. К тому же сухой трансформатор меньше размером, чем маслянный. Рассмотрим расшифровку обозначения силовых трансформаторов на примере ТС(З)(Г)Л — Т1\Т2\Т3 Д/Ун-11:

- Т – трехфазный;

- С – охлаждается от окружающей среды, без использования масла;

- З – имеется защитный кожух;

- Г – в обмотку добавлен кварцевый компаунд «ГЕАФОЛЬ»;

- Л – эпоксидная изоляция обмотки;

- Т1 – номинальная мощность;

- Т2/Т3– класс напряжения обмотки ВН и НН;

- Д/Ун-11 – схема и группа соединения обмоток.

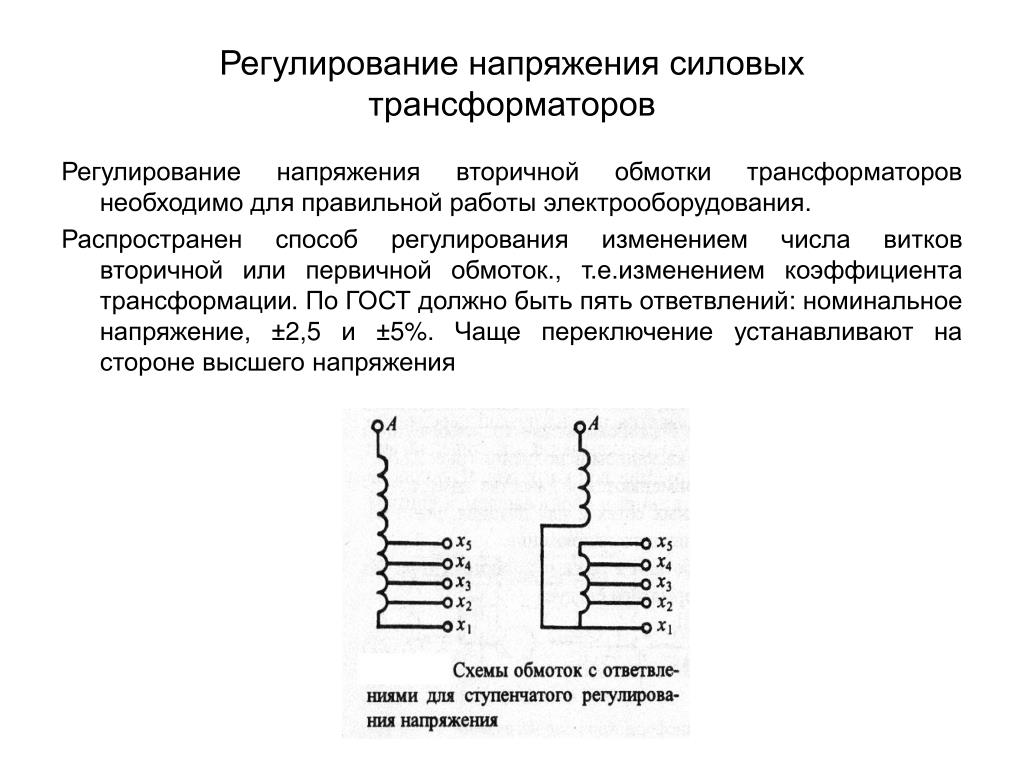

Трансформаторы серии ТМГ предназначены для работы в умеренном и холодном климате. Для работы необходима окружающая среда, не содержащая взрывоопасных и легковоспламеняющихся веществ. Также они не выдерживают тряски, вибрации и ударов. Напряжение настраивается на отключенном полностью трансформаторе переключением ответвлений его обмотки переключателем типа ПБВ.

Напряжение настраивается на отключенном полностью трансформаторе переключением ответвлений его обмотки переключателем типа ПБВ.

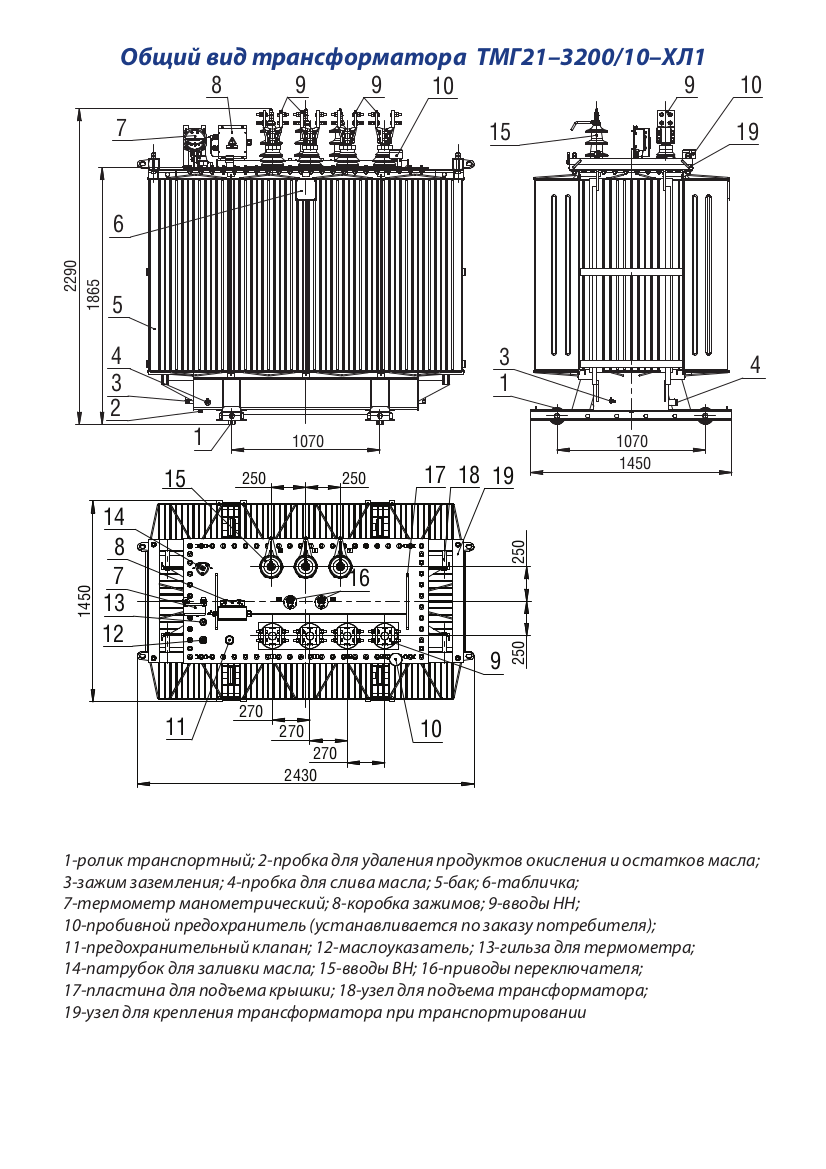

На современных трансформаторах установлены поплавковые маслоуказатели, для того, чтобы измерять уровень масла. Обезопасить трансформатор мощностью до 63 кВА от избыточного давления поможет специальный предохранительный клапан. По желанию клиента на трансформаторах мощностью выше 100 кВА. устанавливается вакуумметр.

Также на такие трансформаторы устанавливаются термометры для измерения температуры масла. На большие трансформаторы (мощностью более 630 кВА) устанавливаются ролики для его перемещения по разным направлениям. Также можно установить ролики на меньшие трансформаторы.

При производстве трансформаторов ТМГ используются передовые технологии, благодаря чему повышаются эксплуатационные характеристики, долговечность и надежность. Изделие является герметичным и полностью заполняется маслом без воздушной подушки. Масло не вступает в контакт с окружающей средой, поэтому оно не окисляется и не загрязняется..jpg)

Перед использованием масла из него удаляются все газы. В бак оно заливается в вакуумной камере. Благодаря этому из масла выходит весь воздух. Также удаляются из емкости различные воздушные и газовые подушки. Благодаря этому обеспечивается высокая устойчивость изоляции трансформатора к электрическим нагрузкам и долговечность устройства. Масло при такой заливке не подвержено окислению и практически не портится на протяжении всего времени эксплуатации. Заявленный срок службы трансформатора – 25 лет.

Масло силовых трансформаторов ТМ, ТМГ и т.д., большинства заводов изготовителей проходит процедуру дегазации. Что позволяет увеличить срок иксплуатации изделия.

У нас вы можете купить силовые трансформаторы как повышающие, так и понижающие, с минимальными сроками и наличием на складе (по заявке). Мы продаем трансформаторы от 16 кВА до 3150кВА.Также мы предлагаем вам однофазные трансформаторы ОМП, которые предназначены для питания систем безопасности и прочих однофазных приборов. Производитель дает гарантию на трансформаторы от 3 до 5 лет.

Производитель дает гарантию на трансформаторы от 3 до 5 лет.

Скачать опросный лист на ТМГ

Присоединительный трансформатор, трансформатор дугогасящего реактора ТМПС

Гарантийный срок устанавливается 60 месяцев (5 лет) с момента отгрузки трансформаторов потребителю.

Назначение

Трансформаторы серии ТМПС предназначены для подключения дугогасящих реакторов.

Трансформаторы предназначены для эксплуатации в районах с умеренным и умеренным и холодным климатом на открытом воздухе (исполнение У1 и УХЛ1 по ГОСТ 15150), при этом:

- окружающая среда не взрывоопасная, не содержащая токопроводящей пыли;

- высота установки над уровнем моря не более 1000 м;

- режим работы двухобмоточных трансформаторов длительный, допускается 10% перегрузка в шестичасовом режиме с повторным включением через 12 часов;

-

режим работы однообмоточных трансформаторов, при максимальном токе, шестичасовой с повторным включением через 12 часов, при номинальном токе длительный режим;

-

температура окружающей среды:

- от минус 45ºС до плюс 40 ºС для климатического исполнения У1,

- от минус 60 ºС до плюс 40 ºС для климатического исполнения УХЛ1;

- трансформаторы не предназначены для работы в условиях тряски, вибраций, ударов, в химически активной среде.

Параметры силовых трансформаторов ТМПС

Таблица 1 — Основные технические параметры трансформаторов 6 кВ, 10 кВ.

|

Наименование параметра |

Значения |

||||||||

|

Номинальная мощность, кВ·А |

100 |

250 |

400 |

630 |

1000 |

1250 |

1600 |

2000 |

2500 |

|

Номинальная частота, Гц |

50 |

50 |

50 |

50 |

50 |

50 |

50 |

50 |

50 |

|

Номинальные напряжения, кВ |

|

|

|

|

|

|

|||

|

ВН |

10,5 (6,3) |

10,5 (6,3) |

10,5 (6,3) |

10,5 (6,3) |

10,5 (6,3) |

10,5 (6,3) |

10,5 (6,3) |

10,5 (6,3) |

10,5 (6,3) |

|

НН |

0,23 |

0,23 |

0,23 |

0,23 |

0,23 |

0,23 |

0,23 |

0,23 |

0,23 |

|

Номинальные токи, А |

|

|

|

|

|

|

|||

|

ВН |

5,5 (9,16) |

13,7 (22,9) |

22 (36,6) |

34,6 (57,7) |

55 (91,6) |

68. |

88 (146,6) |

110 |

137,5 (229) |

|

НН |

251 |

628 |

1004 |

1581 |

2510 |

3138 |

4016 |

5020 | 6276 |

|

Схема и группа соединения обмоток |

Ун/Д – 11 |

Ун/Д – 11 |

Ун/Д – 11 |

Ун/Д – 11 |

Ун/Д – 11 |

Ун/Д – 11 |

Ун/Д – 11 |

Ун/Д – 11 | Ун/Д – 11 |

Таблица 2 — Основные технические параметры трансформаторов 20 кВ.

|

Наименование параметра |

Значения |

||

|

Номинальная мощность, кВ·А |

250 |

630 |

1000 |

|

Номинальная частота, Гц |

50 |

50 |

50 |

|

Номинальные напряжения, кВ |

|

|

|

|

ВН |

21 |

21 |

21 |

|

НН |

0,23 |

0,23 |

0,23 |

|

Номинальные токи, А |

|

|

|

|

ВН |

6,9 |

17,3 |

27,5 |

|

НН |

628 |

1581 |

2510 |

|

Схема и группа соединения обмоток |

Ун/Д – 11 |

Ун/Д – 11 |

Ун/Д – 11 |

Таблица 3 — Габаритные и установочные размеры трансформаторов.

|

Тип |

Размеры, мм, не более |

||||

|

А |

А1 |

В |

Н |

L |

|

|

ТМПС-100 |

550 |

550 |

740 |

1170 |

940 |

|

ТМПС-250 |

550 |

550 |

1010 |

1340 |

1190 |

|

ТМПС-400 |

660 |

660 |

1025 |

1430 |

1395 |

|

ТМПС-630 |

660 |

660 |

1090 |

1540 |

1585 |

|

ТМПС-1000 |

820 |

820 |

1135 |

1860 |

1720 |

|

ТМПС-1250 |

820 | 820 | 1250 | 2020 | 1825 |

|

ТМПС-1600 |

820 | 820 | 1285 | 2170 | 2225 |

|

ТМПС-2000 |

1070 | 1070 | 1365 | 1990 | 2285 |

|

ТМПС-2500 |

1070 | 1070 | 1450 | 2380 | 2370 |

Таблица 4 — Масса трансформаторов.

|

Тип |

Масса, кг не более |

||

|

Масло |

Активная часть |

Общая |

|

|

ТМПС-100 |

125 |

300 |

540 |

|

ТМПС-250 |

270 |

585 |

1100 |

|

ТМПС-400 |

350 |

800 |

1400 |

|

ТМПС-630 |

450 |

1200 |

1860 |

|

ТМПС-1000 |

725 |

1700 |

2750 |

|

ТМПС-1250 |

875 |

1850 |

3250 |

|

ТМПС-1600 |

1170 |

2000 |

4250 |

|

ТМПС-2000 |

1200 |

2300 |

4500 |

|

ТМПС-2500 |

1800 |

2600 |

6680 |

Таблица 5 — Типовые значения технических параметров трансформаторов.

|

Наименование параметра |

Значение |

||||||||

|

Номинальная мощность, кВ·А |

100 |

250 |

400 |

630 |

1000 |

1250 |

1600 |

2000 |

2500 |

|

Потери короткого замыкания, Вт |

2130 |

3450 |

5980 |

9050 |

12650 |

18650 |

21300 |

27970 |

31980 |

|

Потери холостого хода, Вт |

330 |

460 |

790 |

1050 |

1470 |

1950 |

2300 |

2720 |

3350 |

|

Напряжение короткого замыкания, % |

4,5 |

4,5 |

4,5 |

5,5 |

5,5 |

6,0 |

6,0 |

6,0 |

6,0 |

|

Ток холостого хода, % |

2,0 |

1,4 |

1,3 |

1,2 |

0,9 |

2,0 |

1,0 |

1,0 |

0,8 |

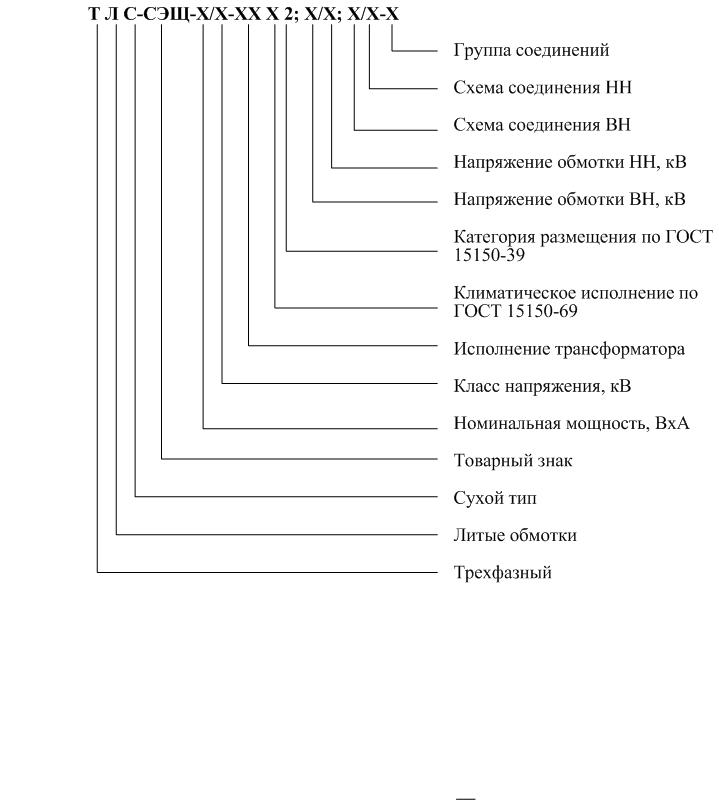

Структура условного обозначения

Комплектность поставки

- Трансформатор силовой – 1 шт.

- Паспорт – 1 экз.

- Руководство по эксплуатации – 1 экз.

- Электроконтактный термометр — 1 шт. для трансформаторов мощностью 875, 1000, 1600, 2500 кВА.

- Мановакуумметр – 1 шт. для трансформаторов мощностью 875, 1000, 1600, 2500 кВА.

- Катки для трансформаторов поставляются по требованию Заказчика.

Гарантия изготовителя

Гарантийный срок устанавливается 60 месяцев (5 лет) с момента отгрузки потребителю.

Обмотки ВН и НН — Проектэлектротехника

г. Москва, ул. Кузнецкий мост, дом 21/5 [email protected]Обратный звонок +7 (8352) 23-70-20

О компании— Качество работ и услуг— НовостиПродукция— Сухие трансформаторы—— Распределительные трансформаторы—— Преобразовательные трансформаторы—— Трансформаторы морского исполнения —— Сухие трансформаторы с литой изоляцией—— Сухие трансформаторы мощностью 10 кВА—— Трехфазные трансформаторы— Специальные трансформаторы— Обмотки ВН и НН— Реакторное оборудование— Комплектные трансформаторные подстанции— Передвижные КТП на шасси— Электротехнические блок-боксы— Аксессуары под заказ— Защитные кожухи для трансформаторов — Дизельные электроагрегаты и электростанции—— Электростанции АД30-Т400—— Электростанции АД100-Т400—— Дизельные электроагрегаты серии АД—— Дизельные электроcтанции серии АД—— Передвижные дизельные электростанции—— Электроагрегат АД8-Т400-1, 2, 3Р (П)—— ЭЛЕКТРОАГРЕГАТ ДИЗЕЛЬНЫЙ АД16-Т400-1, 2, 3Р—— Электроагрегат АД20-Т400-1, 2, 3Р (П)—— Электроагрегат АД30-Т400-1, 2, 3Р (П)—— Электроагрегат АД50-Т400-1, 2, 3Р (П)—— Электроагрегат АД60-Т400-1, 2, 3Р (П)—— Электроагрегат АД100-Т400-1, 2, 3Р (П)—— Электроагрегат АД200-Т400-1, 2, 3Р (П)—— Электростанция ЭД30-Т400-1РПУ1—— Электростанция ЭД2х60-Т400-1, 2, 3РН—— Электростанция ЭД2х100-Т400-1, 2, 3РН—— Электростанция ЭД200-Т400-1, 2, 3РН— Сетевые накопители энергии— Контроллер управления «Вектор Э»— Проходные изоляторы трансформатора— Трансформаторные подстанции— Силовые трансформаторы— Виброгасители для трансформаторовУслуги— Ремонт силовых трансформаторовСкладOn-line заявкаОбъявленияПартнерам— Наши заказчики— ОтзывыКонтакты

- О компании

- Продукция

- Сухие трансформаторы

- Специальные трансформаторы

- Обмотки ВН и НН

- Реакторное оборудование

- Комплектные трансформаторные подстанции

- Передвижные КТП на шасси

- Электротехнические блок-боксы

- Аксессуары под заказ

- Защитные кожухи для трансформаторов

- Дизельные электроагрегаты и электростанции

- Электростанции АД30-Т400

- Электростанции АД100-Т400

- Дизельные электроагрегаты серии АД

- Дизельные электроcтанции серии АД

- Передвижные дизельные электростанции

- Электроагрегат АД8-Т400-1, 2, 3Р (П)

- ЭЛЕКТРОАГРЕГАТ ДИЗЕЛЬНЫЙ АД16-Т400-1, 2, 3Р

- Электроагрегат АД20-Т400-1, 2, 3Р (П)

- Электроагрегат АД30-Т400-1, 2, 3Р (П)

- Электроагрегат АД50-Т400-1, 2, 3Р (П)

- Электроагрегат АД60-Т400-1, 2, 3Р (П)

- Электроагрегат АД100-Т400-1, 2, 3Р (П)

- Электроагрегат АД200-Т400-1, 2, 3Р (П)

- Электростанция ЭД30-Т400-1РПУ1

- Электростанция ЭД2х60-Т400-1, 2, 3РН

- Электростанция ЭД2х100-Т400-1, 2, 3РН

- Электростанция ЭД200-Т400-1, 2, 3РН

- Сетевые накопители энергии

- Контроллер управления «Вектор Э»

- Проходные изоляторы трансформатора

- Трансформаторные подстанции

- Силовые трансформаторы

- Услуги

- Склад

- On-line заявка

- Объявления

- Партнерам

- Контакты

КТПН: расшифровка и условия эксплуатации

Комплектная трансформаторная подстанция наружной установки (КТПН) предназначена для приема, преобразования и распределения электрической энергии трехфазного переменного тока частотой 50 Гц.

Подстанции этого типа удобны в эксплуатации, не требуют постоянного ухода, имеют небольшой размер и являются оптимальным решением для размещения на улице. Основные технические характеристики отражены в маркировке оборудования. Владение этой информацией поможет вам подобрать подходящую подстанцию.

Содержание:

Устройство оборудования

КТПН состоит из модулей, являющиеся каркасной конструкцией из металла, внутри которой установлены главные и дополнительные устройства. Стены модуля сделаны из стального листа и окрашены порошковой полимерной краской. Размеры модуля обусловлены монтируемыми в него устройствами и общими решениями компоновки подстанции.

Назначение оборудования

КТПН нужны для приема, преобразования и распределения электроэнергии конечным потребителям. Применяют для снабжения электроэнергией объектов различных отраслей промышленности:

- нефтяной;

- газовой;

- горнорудной.

Комплектация КТПН

Оборудование состоит из нескольких узлов:

|

У КТПН есть и другие достоинства:

- их можно комплектовать дополнительным оборудованием для решения тех или иных задач;

- они мобильны, их можно транспортировать как полностью собранными, так и в виде отдельных блоков;

- благодаря наличию систем защиты они безопасны в эксплуатации.

Маркировка КТПН

Условные знаки, нанесенные на корпус подстанции, заключают в себе все сведения о ее устройстве. Их расшифровка помогает получить информацию не только о названии комплекса, но и типе его исполнения и соединения, числе и мощности установленных трансформаторов. Отмечаются номиналы высокого и низкого напряжения на входе и выходе. Код заканчивается на информации о категории размещения и климатическом исполнении.

Код заканчивается на информации о категории размещения и климатическом исполнении.

Расшифровка условного обозначения на примере: 2 КТПН -()-630/ 10 /0.4-4-У1

2 | Число силовых трансформаторовСТ (если 1 – не обозначается) |

КТПН — | Комплектная Трансформаторная ПодстанцияТ-тупикового; |

() | ● Т-тупикового; |

630 | Мощность силового трансформатора в кВА |

10 | Класс напряжения трансформатора в кВ |

0,4 | Номинальное напряжение на стороне НН в кВ |

У1 | Тип климатическое исполнение |

КТПН 25; 40; 63; 100; 160; 250; 400; 630; 1000; 1250; 1600; 2000; 2500; 3150; 4000 предназначены для электроснабжения промышленных, коммерческих, гражданских объектов. Обеспечивают преобразование электроэнергии в трехфазных сетях с номинальным напряжением 6 или 10 кВ в энергию 0,23/0,4/0,6/0,69 кВ. Модификации на 600 и 690 вольт по низкой стороне выпускаются по индивидуальным заказам.

Обеспечивают преобразование электроэнергии в трехфазных сетях с номинальным напряжением 6 или 10 кВ в энергию 0,23/0,4/0,6/0,69 кВ. Модификации на 600 и 690 вольт по низкой стороне выпускаются по индивидуальным заказам.

В КТПН-К все элементы оборудования размещены в одном корпусе. КТПН-Б представляет собой блочно-модульные здания. При необходимости их состав можно менять, гибко подстраивая комплектацию оборудования под требования Клиента.

Условия ввода в эксплуатацию

При проверке установки новой ТП проверяющая комиссия сначала сверяет параметры, указанные в инструкции по вводу в эксплуатацию КТПН:

- Присутствие нумерации, находящейся на баках и дверях трансформаторов, с помощью которых уменьшается риск неверного использования. Двери трансформаторных помещений должны быть оснащены надписями, сообщающими об опасности, которой подвергается человек при подходе к трансформатору.

- Трансформаторы, мощность которых выше 1000 кВА, должны оснащаться амперметрами для контроля нагрузки, а также термометрами, определяющими температуру масла.

- Инструкция по вводу в эксплуатацию КТПН предполагает присутствие на кнопках, ручках и ключах управления текстовых табличек, указывающих на совершаемые ими действия (включить, отключить, добавить, убавить). Также устройство должно иметь контрольные лампы с надписями, идентифицирующимихарактеризующими сигнал.

- Жилы кабелей и проводов, подсоединяющиеся к клеммам, должны иметь запас длины для повторного подсоединения жил к зажиму при случайном обрыве.

- Щит управления должен иметь запасные предохранители и контрольные лампы, инструменты, фонари, огнетушители, аптечки, ключи от всех комнат.

- Двери аккумуляторных камер должны иметь предупреждающие надписи: «Аккумуляторная», «Не курить».

- В аккумуляторном помещении лампы накаливания должны располагаться в светильниках, имеющих взрывозащищенное исполнение.

- Все конденсаторы должны быть обозначены краской. Номер должен быть записан на стенке бака, направленной к коридору обслуживания.

Подключение оборудования

КТПН устанавливаются на фундамент (монолитный ленточный, свайный, плитный). Такой метод является трудоемким и используется при плюсовых температурах окружающей среды. Если нужно установить подстанцию на грунт (бетонную, асфальтовую площадку), то КТПН должна быть на особой раме или понтоне. |

При установке КТПН необходимо учитывать следующие рекомендации:

- фундамент должен располагаться на 0,2–1,5 м от земли для исключения случайного затопления;

- число закладных труб для вводов и выводов кабельных линий должно быть выше проектного на 50%;

- система заземления должна согласовываться с проектом установки и ПУЭ;

- подключают конструкцию после окончания установочных работ.

До эксплуатации нужно совершить ряд пусконаладочных работ, предусмотренных разработчиком и соответствующих требованиям электрической безопасности.

Правила эксплуатации КТПН

Подстанция рассчитана на круглогодичную работу при следующих условиях:

- температура воздуха от -45 до +40°С для У1 и от -60 до +40°С для УХЛ1;

- влажность воздуха при +15°С – не выше 75%;

- высота расположения над уровнем моря — не больше 1000 м;

- атмосферное давление — 86,6 — 106,7 кПа;

- сейсмичность — до 9 баллов (шкала MSK-64) по ГОСТ 17516.1;

- в стандартном исполнении может монтироваться в условиях промышленной атмосферы, не имеющей в составе вредных веществ, которые могут проесть изоляцию или подвергнуть коррозии металлические составляющие подстанции, сформировать взрывоопасную концентрацию пыли.

Если соблюдение всех этих параметров невозможно, для преобразования электроэнергии нужно выбрать иные виды подстанций, созданные для использования в особых условиях.

Специалисты нашей компании произведут, смонтируют и выполнят пусконаладку КТПН различной комплектации. Применение КТПН упрощает и удешевляет подключение потребителей электроэнергии при наличии доступа только к высоковольтной сети. Мы гарантируем оперативный монтаж и подключение. Наше оборудование полностью безопасно при эксплуатации на открытых площадках в умеренных и холодных климатических условиях.

Общие сведения Трансформатор силовой масляный трехфазный трехобмоточный типа ТДТН-63000/110 У1 наружной установки, с регулированием напряжения в обмотке ВН под нагрузкой (РПН) в пределах + 9×1,78% номинального напряжения и с регулированием напряжения на стороне СН — 35 кВ при отключенном трансформаторе (ПБВ) в пределах + 2×2,5% номинального напряжения, предназначен для работы в сетях с глухозаземленной нейтралью. Структура условного обозначения ТДТН-63000/110 У1: Условия эксплуатации Высота над уровнем моря не более 1 000 м. В открытых электроустановках. Среднесуточная температура окружающего воздуха не более 30°С, среднегодовая — не более 20°С. Требования техники безопасности по ГОСТ 12.2.003-74, ГОСТ 12.2.007.2-75, ГОСТ 12.2.024-76, ГОСТ 12.1.004-91. Трансформатор соответствует ГОСТ 12965-93. ГОСТ 12965-93 Технические характеристики Конструкция и принцип действия Активная часть трансформатора, состоящая из остова, обмоток, изоляции, отводов с регулятором напряжения РПН и переключателями ПБВ, устанавливается в бак. Остов трансформатора однорамный, трехстержневой, собран из листов холоднокатаной электротехнической стали. Стержни остова стягиваются бандажами из стеклоленты, а ярма — ярмовыми балками и стальными полубандажами. Верхние и нижние ярмовые балки стянуты между собой стальными шпильками. Обмотки цилиндрические концентрически размещены на стержнях остова. Обмотка СН размещается между обмотками НН и ВН. Регулировочная обмотка — наружная. Изоляция обмоток — маслобарьерного типа. Встроенные трансформаторы тока предназначены для максимальной и дифференциальной токовой защиты и приборов измерения. Трансформатор снабжен на линейных вводах ВН двумя трансформаторами тока ТВТ-110, на нейтральном вводе ВН — двумя трансформаторами тока ТВТ-35, на линейных вводах СН — 38,5 кВ — двумя трансформаторами тока ТВТ-35. Трансформатор охлаждается радиаторами, каждый из которых обдувается двумя вентиляторами. Мощность электродвигателя типа 4АА63АЧТрУ1 вентиляторов охлаждения равна 0,25 кВт. Трансформатор снабжен шкафом автоматического управления дутьем типа ШД-2. Дутьевая установка питается от трехфазной сети напряжением 380 В. Активная часть трансформатора поднимается за кронштейны на верхних ярмовых балках, а полностью собранный трансформатор — за подъемные приспособления на баке. Бак трансформатора колокольного типа, сварной, снабжен арматурой для заливки, слива трансформаторного масла и взятия проб, подключения маслоочистительной установки и вакуум-насоса в соответствии с ГОСТ 12965-93. На баке устанавливаются защитные устройства, приборы контроля температуры масла, приводы РПН и ПБВ. На крышке бака установлены: расширитель, имеющий стрелочный маслоуказатель, вводы «О» СН, «О» ВН, НН, СН, ВН, регулятор напряжения РПН. Расширитель соединяется трубопроводом с баком трансформатора. Габаритные и установочные размеры трансформатора приведены на рис. 1, расположение и размеры вводов — на рис. 2 и в таблице. Рис. 1. Общий вид, габаритные и установочные размеры трансформатора типа ТДТН-63000/110 У1: 1 — бак;2 — ввод НН; 3 — ввод ВН; 4 — ввод СН; 5 — ввод О ВН; 6 — ввод О СН; 7 — расширитель; 8 — регулятор напряжения РПН Рис. 2. Расположение вводов СН — 11 кВ на крышке бакаТабл. В комплект поставки входят: трансформатор, запасные части в соответствии с ведомостью ЗИП изготовителя, эксплуатационная документация.Центр комплектации «СпецТехноРесурс» |

Иллюстрированное руководство по трансформаторам — пошаговое объяснение | Майкл Фи

Трансформаторы штурмом захватывают мир обработки естественного языка. Эти невероятные модели бьют множество рекордов НЛП и продвигают новейшие разработки. Они используются во многих приложениях, таких как машинный перевод, разговорные чат-боты и даже для улучшения поисковых систем. Трансформаторы сейчас в моде в области глубокого обучения, но как они работают? Почему они превзошли предыдущего короля проблем последовательности, такого как рекуррентные нейронные сети, GRU и LSTM? Вы, наверное, слышали о различных известных моделях трансформеров, таких как BERT, GPT и GPT2.В этом посте мы сосредоточимся на одной статье, с которой все началось: «Внимание — это все, что вам нужно».

Перейдите по ссылке ниже, если вы хотите вместо этого посмотреть видеоверсию.

Чтобы понять трансформаторов, мы сначала должны понять механизм внимания. Механизм внимания позволяет трансформаторам иметь чрезвычайно долгую память. Модель-трансформер может «присутствовать» или «фокусироваться» на всех ранее сгенерированных токенах.

Давайте рассмотрим пример. Допустим, мы хотим написать небольшой научно-фантастический роман с генеративным преобразователем.Мы можем сделать это с помощью приложения Write With Transformer от Hugging Face. Мы заполним модель нашими входными данными, а модель сгенерирует все остальное.

Наш вклад: «Когда пришельцы вошли на нашу планету».

Выход трансформатора: «и начала колонизацию Земли, определенная группа инопланетян начала манипулировать нашим обществом через свое влияние определенного числа элиты, чтобы удерживать и железной хваткой над населением».

Хорошо, история немного мрачная, но что интересно, так это то, как модель ее сгенерировала.По мере того как модель генерирует текст слово за словом, она может «следить» или «фокусироваться» на словах, которые имеют отношение к сгенерированному слову. Способность знать, какие слова следует посещать, также усваивается во время обучения посредством обратного распространения ошибки.

Механизм внимания, фокусирующийся на разных токенах при генерации слов 1 на 1Рекуррентные нейронные сети (RNN) также могут просматривать предыдущие входные данные. Но сила механизма внимания в том, что он не страдает от кратковременной памяти. У RNN более короткое окно для ссылки, поэтому, когда история становится длиннее, RNN не может получить доступ к словам, сгенерированным ранее в последовательности.Это по-прежнему верно для сетей с закрытыми рекуррентными модулями (GRU) и долгосрочной краткосрочной памятью (LSTM), хотя они обладают большей емкостью для достижения долговременной памяти, следовательно, имеют более длительное окно для ссылки. Механизм внимания теоретически и при наличии достаточных вычислительных ресурсов имеет бесконечное окно, из которого можно ссылаться, поэтому он может использовать весь контекст истории при создании текста.

Гипотетическое справочное окно Attention, RNN, GRU и LSTMСила механизма внимания была продемонстрирована в статье «Внимание — это все, что вам нужно», где авторы представили новую новую нейронную сеть под названием Transformers, которая является кодировщиком на основе внимания. архитектура типа декодера.Модель преобразователя

На высоком уровне кодер преобразует входную последовательность в абстрактное непрерывное представление, которое содержит всю изученную информацию этого входа. Затем декодер принимает это непрерывное представление и шаг за шагом генерирует один вывод, одновременно передавая предыдущий вывод.

Давайте рассмотрим пример. В статье модель Transformer применялась к задаче нейронного машинного перевода. В этом посте мы продемонстрируем, как это работает для разговорного чат-бота.

Наш ввод: «Привет, как дела»

Вывод трансформатора: «Я в порядке»

Первым шагом является подача ввода в слой встраивания слов. Слой встраивания слов можно рассматривать как таблицу поиска, чтобы получить изученное векторное представление каждого слова. Нейронные сети обучаются с помощью чисел, поэтому каждое слово отображается в вектор с непрерывными значениями для представления этого слова.

преобразование слов во входные вложенияСледующим шагом является введение позиционной информации во вложения.Поскольку кодировщик-преобразователь не имеет повторения, как рекуррентные нейронные сети, мы должны добавить некоторую информацию о позициях во входные вложения. Это делается с помощью позиционного кодирования. Авторы придумали хитрый трюк, используя функции sin и косинус.

Мы не будем вдаваться в математические подробности позиционного кодирования, но вот основы. Для каждого нечетного индекса входного вектора создайте вектор с помощью функции cos. Для каждого четного индекса создайте вектор с помощью функции sin.Затем добавьте эти векторы к их соответствующим входным вложениям. Это успешно дает сети информацию о положении каждого вектора. Функции sin и косинус были выбраны в тандеме, потому что они обладают линейными свойствами, которым модель может легко научиться уделять внимание.

Теперь у нас есть слой кодировщика. Задача слоев Encoders состоит в том, чтобы отобразить все входные последовательности в абстрактное непрерывное представление, которое содержит изученную информацию для всей этой последовательности. Он содержит 2 подмодуля, многоголовое внимание, за которым следует полностью подключенная сеть.Также существуют остаточные связи вокруг каждого из двух подслоев, за которыми следует нормализация уровня.

Субмодули уровня кодировщикаЧтобы разобраться в этом, давайте сначала рассмотрим модуль многоголового внимания.

Многоголовое внимание в кодировщике применяет особый механизм внимания, называемый самовниманием. Самовнимание позволяет моделям связывать каждое слово во входных данных с другими словами. Итак, в нашем примере наша модель может научиться ассоциировать слово «вы» с «как» и «есть».Также возможно, что модель узнает, что слова, структурированные по этому шаблону, обычно являются вопросом, поэтому отвечайте соответствующим образом.

Encoder Self-Attention Operations. Ссылка на это при просмотре иллюстраций ниже.Векторы запроса, ключа и значения

Чтобы добиться самовнимания, мы передаем входные данные в 3 отдельных полностью связанных слоя для создания векторов запроса, ключа и значения.

Что именно это за векторы? Я нашел хорошее объяснение по обмену стеками, в котором говорится….

«Концепция ключа и значения запроса исходит из поисковых систем. Например, когда вы вводите запрос для поиска некоторого видео на Youtube, поисковая система сопоставляет ваш запрос с набором ключей (заголовок видео, описание и т. Д.), Связанных с видео кандидатов в базе данных, затем представим вам наиболее подходящие видео ( значения ).

Точечное произведение запроса и ключа

После подачи вектора запроса, ключа и значения через линейный слой запросы и ключи подвергаются умножению матрицы скалярного произведения для создания матрицы оценок.

Умножение скалярного произведения запроса и ключаМатрица оценок определяет, насколько большое внимание следует уделять слову другие слова. Таким образом, каждое слово будет иметь оценку, соответствующую другим словам на временном шаге. Чем выше оценка, тем больше внимания. Вот как запросы сопоставляются с ключами.

Оценка внимания от скалярного произведения.Уменьшение оценок внимания

Затем оценки уменьшаются путем деления на квадратный корень из измерения запроса и ключа.Это сделано для обеспечения более стабильных градиентов, так как умножение значений может иметь взрывной эффект.

Уменьшение оценок вниманияSoftmax масштабированных оценок

Затем вы берете softmax масштабированной оценки, чтобы получить веса внимания, что дает вам значения вероятности от 0 до 1. Выполняя softmax, повышаются более высокие оценки, и более низкие баллы подавлены. Это позволяет модели быть более уверенной в выборе слов.

Взятие softmax масштабированных оценок для получения значений вероятностиУмножение выходных данных Softmax на вектор значений

Затем вы берете веса внимания и умножаете их на свой вектор значений, чтобы получить вектор выходных данных.Более высокие баллы softmax сохранят ценность слов, которые модель выучила более важными. Более низкие баллы заглушают неуместные слова. Затем вы передаете результат в линейный слой для обработки.

Чтобы сделать это вычисление многоголового внимания, вам нужно разделить запрос, ключ и значение на N векторов, прежде чем применять самовнимание. Затем расщепленные векторы индивидуально проходят процесс самовнимания. Каждый процесс самовнимания называется головой. Каждая голова создает выходной вектор, который объединяется в один вектор перед прохождением последнего линейного слоя.Теоретически каждая голова будет изучать что-то свое, что дает модели кодировщика большую репрезентативную способность.

Разделение Q, K, V, N раз перед применением самовниманияПодводя итог, многоголовое внимание — это модуль в трансформаторной сети, который вычисляет веса внимания для входа и создает выходной вектор с закодированной информацией о том, как каждое слово должно соответствовать всем другим словам в последовательности.

Выходной вектор многоголового внимания добавляется к исходному позиционному встраиванию входных данных.Это называется остаточной связью. Вывод остаточного соединения проходит через нормализацию слоя.

Остаточное соединение позиционного встраивания ввода и вывода многоголового вниманияНормализованный остаточный вывод проецируется через точечную сеть с прямой связью для дальнейшей обработки. Точечная сеть с прямой связью представляет собой пару линейных слоев с активацией ReLU между ними. Выходной сигнал затем снова добавляется к входу точечной сети с прямой связью и далее нормализуется.

Остаточное соединение входа и выхода точечного прямого слоя.Остаточные соединения помогают обучению сети, позволяя градиентам проходить через сети напрямую. Нормализация слоев используется для стабилизации сети, что приводит к существенному сокращению необходимого времени обучения. Слой точечной упреждающей связи используется для проецирования выходных данных внимания, потенциально давая им более богатое представление.

Это завершает слой кодировщика. Все эти операции предназначены для кодирования входных данных в непрерывное представление с информацией о внимании.Это поможет декодеру сосредоточиться на соответствующих словах во вводе во время процесса декодирования. Вы можете складывать кодер N раз для дальнейшего кодирования информации, при этом каждый уровень имеет возможность изучать различные представления внимания, что потенциально увеличивает предсказательную мощность трансформаторной сети.

Задача декодера — генерировать текстовые последовательности. Декодер имеет такой же подуровень, что и кодер. он имеет два многоголовых слоя внимания, слой с точечной прямой связью и остаточные связи, а также нормализацию уровня после каждого подуровня.Эти подуровни ведут себя аналогично уровням в кодировщике, но каждый многоглавый уровень внимания выполняет свою работу. Декодер завершается линейным слоем, который действует как классификатор, и softmax для получения вероятностей слов.

Слой декодера. Ссылка на эту диаграмму при чтении.Декодер является авторегрессионным, он начинается со стартового токена и принимает список предыдущих выходов в качестве входов, а также выходы кодировщика, которые содержат информацию о внимании из входа.Декодер прекращает декодирование, когда генерирует токен в качестве вывода.

Декодер является авторегрессионным, так как он генерирует токен 1 за раз, подавая его на предыдущие выходы.Давайте пройдемся по этапам декодирования.

Начало декодера почти такое же, как у кодировщика. Входные данные проходят через слой внедрения и слой позиционного кодирования, чтобы получить позиционные вложения. Позиционные вложения вводятся в первый слой внимания с несколькими головами, который вычисляет оценки внимания для входных данных декодера.

Этот многоглавый слой внимания работает несколько иначе. Поскольку декодер является авторегрессионным и генерирует последовательность слово за словом, вам необходимо предотвратить его преобразование в будущие токены. Например, при вычислении оценки внимания к слову «я» у вас не должно быть доступа к слову «отлично», потому что это слово является будущим словом, которое было сгенерировано после. Слово «am» должно иметь доступ только к самому себе и к словам перед ним. Это верно для всех других слов, где они могут относиться только к предыдущим словам.

Изображение первого многоголового внимания декодера по шкале оценки внимания. Слово «am» не должно иметь никаких значений для слова «штраф». Это верно для всех остальных слов.Нам нужен метод, предотвращающий вычисление оценок внимания для будущих слов. Этот метод называется маскированием. Чтобы декодер не смотрел на будущие токены, вы применяете маску просмотра вперед. Маска добавляется перед вычислением softmax и после масштабирования оценок. Давайте посмотрим, как это работает.

Маска упреждения

Маска — это матрица того же размера, что и оценки внимания, заполненная значениями 0 и отрицательной бесконечностью.Когда вы добавляете маску к шкале оценок внимания, вы получаете матрицу оценок, в которой верхний правый треугольник заполнен бесконечностями негатива.

Добавление маски упреждающего просмотра к масштабированным оценкамПричина использования маски в том, что как только вы берете softmax замаскированных оценок, отрицательные бесконечности обнуляются, оставляя нулевые оценки внимания для будущих токенов. Как вы можете видеть на рисунке ниже, оценка внимания для «am» имеет значения для себя и всех слов перед ним, но равна нулю для слова «хорошо».По сути, это говорит модели не акцентировать внимание на этих словах.

Это маскирование — единственное отличие в том, как рассчитываются оценки внимания в первом многоглавом слое внимания. Этот слой по-прежнему имеет несколько головок, к которым применяется маска, прежде чем они будут объединены и пропущены через линейный слой для дальнейшей обработки. Результатом первого многоголового внимания является замаскированный выходной вектор с информацией о том, как модель должна присутствовать на входе декодера.

Многоголовое внимание с маскированиемВторой слой многоголового внимания.Для этого уровня выходными данными кодировщика являются запросы и ключи, а выходными данными первого многоголового уровня внимания являются значения. Этот процесс сопоставляет вход кодера со входом декодера, позволяя декодеру решить, на какой вход кодера следует обратить внимание. Результат второго многоголового внимания проходит через точечный слой прямой связи для дальнейшей обработки.

Выходные данные последнего поточечного слоя с прямой связью проходят через последний линейный слой, который действует как классификатор.Классификатор такой же большой, как и количество имеющихся у вас классов. Например, если у вас есть 10 000 классов для 10 000 слов, вывод этого классификатора будет иметь размер 10 000. Выходные данные классификатора затем передаются в слой softmax, который дает оценки вероятности от 0 до 1. Мы берем индекс наивысшей оценки вероятности, который равен нашему предсказанному слову.

Линейный классификатор с Softmax для получения вероятностей выводаЗатем декодер берет вывод, добавляет его в список входов декодера и снова продолжает декодирование, пока не будет предсказан токен.В нашем случае предсказание с наивысшей вероятностью — это последний класс, который назначается конечному токену.

Декодер также может быть наложен на N уровней, каждый из которых принимает входные данные от кодера и предшествующих ему слоев. Сложив слои, модель может научиться извлекать и сосредотачиваться на различных комбинациях внимания из своих головок внимания, потенциально повышая ее способность к прогнозированию.

Кодировщик и декодер с накоплениемИ все! Такова механика трансформаторов.Трансформаторы используют силу механизма внимания, чтобы делать более точные прогнозы. Рекуррентные нейронные сети пытаются добиться аналогичных результатов, но потому, что они страдают от кратковременной памяти. Трансформаторы могут быть лучше, особенно если вы хотите кодировать или генерировать длинные последовательности. Благодаря архитектуре преобразователя индустрия обработки естественного языка может достичь беспрецедентных результатов.

Посетите michaelphi.com, чтобы найти больше подобного контента.

Модели кодировщика-декодера на базе трансформатора

! Pip install трансформаторы == 4.2.1

! pip install фраза == 0.1.95

Модель кодера-декодера на основе трансформатора была представлена Васвани. и другие. в знаменитом Attention — это все, что вам нужно бумага и сегодня де-факто стандартная архитектура кодера-декодера при обработке естественного языка (НЛП).

В последнее время было проведено много исследований различных предтренировочных объективы для моделей кодеров-декодеров на базе трансформаторов, например Т5, Барт, Пегас, ProphetNet, Мардж, и т. Д. …, но модель архитектуры остался в основном прежним.

Цель сообщения в блоге — дать подробное описание как моделирует архитектуру кодера-декодера на основе трансформатора от последовательности к последовательности проблем. Сфокусируемся на математической модели определяется архитектурой и тем, как модель может использоваться для вывода. Попутно мы дадим некоторую справочную информацию о последовательности в последовательность. модели в NLP и разбить кодировщик-декодер на базе трансформатора архитектура в его кодировщика и декодера частей.Мы предоставляем много иллюстрации и установить связь между теорией модели кодеров-декодеров на базе трансформаторов и их практическое применение в 🤗Трансформаторы для вывода. Обратите внимание, что это сообщение в блоге не объясняет , а не . как такие модели можно обучить — это тема будущего блога Почта.

Модели кодеров-декодеров на базе трансформаторов являются результатом многолетней Исследование представлений , изучение архитектур моделей и . Этот блокнот содержит краткое изложение истории нейронных кодировщики-декодеры модели.Для получения дополнительной информации читателю рекомендуется прочитать этот замечательный блог опубликовать Себастион Рудер. Кроме того, базовое понимание рекомендуется архитектура с самовниманием . Следующее сообщение в блоге автора Джей Аламмар служит хорошим напоминанием об оригинальной модели Transformer. здесь.

На момент написания этого блокнота «Трансформеры включают кодировщики-декодеры моделей T5 , Bart , MarianMT и Pegasus , которые кратко описаны в документации по модели резюме.

Ноутбук разделен на четыре части:

- Предпосылки — Краткая история моделей нейронных кодировщиков-декодеров дается с акцентом на модели на основе RNN.

- Кодер-декодер — Модель кодера-декодера на основе трансформатора представлена и объясняется, как модель используется для вывод.

- Энкодер — Энкодер модели поясняется в деталь.

- Декодер — Декодерная часть модели поясняется в деталь.

Каждая часть основана на предыдущей части, но также может быть прочитана на ее собственный.

ФонЗадачи генерации естественного языка (NLG), подполе NLP, являются лучшими выражаются как задачи от последовательности к последовательности. Такие задачи можно определить как поиск модели, которая отображает последовательность входных слов в последовательность целевые слова. Некоторые классические примеры — это обобщение и перевод . Далее мы предполагаем, что каждое слово закодировано в векторное представление.входные слова nnn могут быть представлены как последовательность входных векторов nnn:

X1: n = {x1,…, xn}. \ Mathbf {X} _ {1: n} = \ {\ mathbf {x} _1, \ ldots, \ mathbf {x} _n \}. X1: n = {x1,…, xn}.

Следовательно, проблемы от последовательности к последовательности могут быть решены путем нахождения отображение fff из входной последовательности nnn векторов X1: n \ mathbf {X} _ {1: n} X1: n в последовательность целевых векторов mmm Y1: m \ mathbf {Y} _ {1: m} Y1: m, тогда как число векторов-мишеней ммм априори неизвестен и зависит от входных данных последовательность:

f: X1: n → Y1: m.22 для решения задач от последовательности к последовательности следовательно, означает, что необходимо знать количество целевых векторов mmm apriori и должен быть независимым от ввода X1: n \ mathbf {X} _ {1: n} X1: n. Это неоптимально, потому что для задач в NLG количество целевых слов обычно зависит от ввода X1: n \ mathbf {X} _ {1: n} X1: n и не только на входной длине nnn. Например. , статья 1000 слов можно суммировать как до 200 слов, так и до 100 слов в зависимости от его содержание.

В 2014 г. Cho et al.33. После обработки последнего входного вектора xn \ mathbf {x} _nxn, Скрытое состояние кодировщика определяет входную кодировку c \ mathbf {c} c. Таким образом, кодировщик определяет отображение:

fθenc: X1: n → c. f _ {\ theta_ {enc}}: \ mathbf {X} _ {1: n} \ to \ mathbf {c}. fθenc: X1: n → c.

Затем скрытое состояние декодера инициализируется входной кодировкой. и во время логического вывода декодер RNN используется для авторегрессивного генерировать целевую последовательность. Поясним.

Математически декодер определяет распределение вероятностей целевая последовательность Y1: m \ mathbf {Y} _ {1: m} Y1: m с учетом скрытого состояния c \ mathbf {c} c:

pθdec (Y1: m∣c).{m} p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _i | \ mathbf {Y} _ {0: i-1}, \ mathbf {c}). pθdec (Y1: m ∣c) = i = 1∏m pθdec (yi ∣Y0: i − 1, c).

Таким образом, если архитектура может моделировать условное распределение следующий целевой вектор, учитывая все предыдущие целевые векторы:

pθdec (yi∣Y0: i − 1, c), ∀i∈ {1,…, m}, p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _i | \ mathbf {Y} _ {0: i-1}, \ mathbf {c}), \ forall i \ in \ {1, \ ldots, m \}, pθdec (yi ∣Y0: i − 1, c), ∀ i∈ {1,…, m},

, то он может моделировать распределение любой последовательности целевого вектора, заданной скрытое состояние c \ mathbf {c} c путем простого умножения всех условных вероятности.

Так как же модель архитектуры декодера на основе RNN pθdec (yi∣Y0: i − 1, c) p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _i | \ mathbf {Y} _ { 0: i-1}, \ mathbf {c}) pθdec (yi ∣Y0: i − 1, c)?

С точки зрения вычислений, модель последовательно отображает предыдущий внутренний скрытое состояние ci − 1 \ mathbf {c} _ {i-1} ci − 1 и предыдущий целевой вектор yi \ mathbf {y} _iyi до текущего внутреннего скрытого состояния ci \ mathbf {c} _ici и a вектор logit li \ mathbf {l} _ili (показано темно-красным цветом ниже):

fθdec (yi − 1, ci − 1) → li, ci.f _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _ {i-1}, \ mathbf {c} _ {i-1}) \ to \ mathbf {l} _i, \ mathbf {c } _i.fθdec (yi − 1, ci − 1) → li, ci. c0 \ mathbf {c} _0c0 таким образом определяется как c \ mathbf {c} c, являющийся выходом скрытое состояние кодировщика на основе RNN. Впоследствии softmax используется для преобразования вектора логита li \ mathbf {l} _ili в условное распределение вероятностей следующего целевого вектора:

p (yi∣li) = Softmax (li), где li = fθdec (yi − 1, cprev). p (\ mathbf {y} _i | \ mathbf {l} _i) = \ textbf {Softmax} (\ mathbf {l} _i), \ text {with} \ mathbf {l} _i = f _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _ {i-1}, \ mathbf {c} _ {\ text {prev}}).44. Из приведенного выше уравнения мы можно видеть, что распределение текущего целевого вектора yi \ mathbf {y} _iyi напрямую обусловлено предыдущим целевым вектором yi − 1 \ mathbf {y} _ {i-1} yi − 1 и предыдущим скрытым состоянием ci −1 \ mathbf {c} _ {i-1} ci − 1. Поскольку предыдущее скрытое состояние ci − 1 \ mathbf {c} _ {i-1} ci − 1 зависит от всех предыдущие целевые векторы y0,…, yi − 2 \ mathbf {y} _0, \ ldots, \ mathbf {y} _ {i-2} y0,…, yi − 2, он может быть заявлено, что декодер на основе RNN неявно ( например, косвенно ) моделирует условное распределение pθdec (yi∣Y0: i − 1, c) p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _i | \ mathbf {Y} _ {0: i-1}, \ mathbf {c}) pθdec (yi ∣Y0: i − 1, c).55, которые эффективно выбирают целевой вектор с высокой вероятностью последовательности из pθdec (Y1: m∣c) p _ {\ theta_ {dec}} (\ mathbf {Y} _ {1: m} | \ mathbf {c}) pθdec (Y1: m ∣c).

При таком методе декодирования во время вывода следующий входной вектор yi \ mathbf {y} _iyi может затем быть выбран из pθdec (yi∣Y0: i − 1, c) p _ {\ theta _ {\ text {dec}} } (\ mathbf {y} _i | \ mathbf {Y} _ {0: i-1}, \ mathbf {c}) pθdec (yi ∣Y0: i − 1, c) и, следовательно, добавляется к входной последовательности, так что декодер Затем RNN моделирует pθdec (yi + 1∣Y0: i, c) p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _ {i + 1} | \ mathbf {Y} _ {0: i }, \ mathbf {c}) pθdec (yi + 1 ∣Y0: i, c) для выборки следующего входного вектора yi + 1 \ mathbf {y} _ {i + 1} yi + 1 и т. д. в авторегрессивный мод.

Важной особенностью моделей кодеров-декодеров на основе RNN является определение специальных векторов , таких как вектор EOS \ text {EOS} EOS и BOS \ text {BOS} BOS. Вектор EOS \ text {EOS} EOS часто представляет собой окончательный входной вектор xn \ mathbf {x} _nxn, чтобы «указать» кодировщику, что вход последовательность закончилась, а также определяет конец целевой последовательности. В качестве как только EOS \ text {EOS} EOS выбирается из вектора логита, генерация завершено. Вектор BOS \ text {BOS} BOS представляет входной вектор y0 \ mathbf {y} _0y0, подаваемый в декодер RNN на самом первом этапе декодирования.Для вывода первого логита l1 \ mathbf {l} _1l1 требуется ввод, и поскольку на первом шаге не было создано никаких входных данных. специальный BOS \ text {BOS} BOS входной вектор поступает на декодер RNN. Хорошо — довольно сложно! Давайте проиллюстрируйте и рассмотрите пример.

Развернутый кодировщик RNN окрашен в зеленый цвет, а развернутый RNN декодер окрашен в красный цвет.

Английское предложение «Я хочу купить машину», представленное как x1 = I \ mathbf {x} _1 = \ text {I} x1 = I, x2 = want \ mathbf {x} _2 = \ text {want} x2 = хочу, x3 = to \ mathbf {x} _3 = \ text {to} x3 = to, x4 = buy \ mathbf {x} _4 = \ text {buy} x4 = buy, x5 = a \ mathbf {x} _5 = \ text {a} x5 = a, x6 = car \ mathbf {x} _6 = \ text {car} x6 = car и x7 = EOS \ mathbf {x} _7 = \ text {EOS} x7 = EOS переводится на немецкий: «Ich will ein Auto kaufen «определяется как y0 = BOS \ mathbf {y} _0 = \ text {BOS} y0 = BOS, y1 = Ich \ mathbf {y} _1 = \ text {Ich} y1 = Ich, y2 = will \ mathbf {y} _2 = \ text {will} y2 = will, y3 = ein \ mathbf {y} _3 = \ text {ein} y3 = ein, y4 = Auto, y5 = kaufen \ mathbf {y} _4 = \ text {Auto}, \ mathbf {y} _5 = \ text {kaufen} y4 = Auto, y5 = kaufen и y6 = EOS \ mathbf {y} _6 = \ text {EOS} y6 = EOS. 66.На рисунке выше горизонтальная стрелка, соединяющая развернутый кодировщик RNN представляет собой последовательные обновления скрытых штат. Окончательное скрытое состояние кодировщика RNN, представленное c \ mathbf {c} c, затем полностью определяет кодировку входных данных. последовательность и используется как начальное скрытое состояние декодера RNN. Это можно увидеть как преобразование декодера RNN на закодированный вход.

Для генерации первого целевого вектора в декодер загружается BOS \ text {BOS} BOS вектор, показанный как y0 \ mathbf {y} _0y0 на рисунке выше.Цель вектор RNN затем дополнительно отображается на вектор логита l1 \ mathbf {l} _1l1 с помощью слоя прямой связи LM Head для определения условное распределение первого целевого вектора, как объяснено выше:

pθdec (y∣BOS, c). p _ {\ theta_ {dec}} (\ mathbf {y} | \ text {BOS}, \ mathbf {c}). pθdec (y∣BOS, c).

Выбирается слово Ich \ text {Ich} Ich (показано серой стрелкой, соединяющей l1 \ mathbf {l} _1l1 и y1 \ mathbf {y} _1y1) и, следовательно, вторая цель вектор может быть выбран:

будет ∼pθdec (y∣BOS, Ich, c).\ text {will} \ sim p _ {\ theta_ {dec}} (\ mathbf {y} | \ text {BOS}, \ text {Ich}, \ mathbf {c}). will∼pθdec (y∣BOS, Ich, c).

И так до тех пор, пока на шаге i = 6i = 6i = 6, вектор EOS \ text {EOS} EOS не будет выбран из l6 \ mathbf {l} _6l6, и декодирование не будет завершено. Результирующая цель последовательность составляет Y1: 6 = {y1,…, y6} \ mathbf {Y} _ {1: 6} = \ {\ mathbf {y} _1, \ ldots, \ mathbf {y} _6 \} Y1: 6 = {y1,…, y6}, что является «Ich will ein Auto kaufen» в нашем примере выше.

Подводя итог, модель кодера-декодера на основе RNN, представленная fθencf _ {\ theta _ {\ text {enc}}} fθenc и pθdec p _ {\ theta _ {\ text {dec}}} pθdec, определяет распределение p (Y1: m∣X1: n) p (\ mathbf {Y} _ {1: m} | \ mathbf {X} _ {1: n}) p (Y1: m ∣X1: n) к факторизация:

pθenc, θdec (Y1: m∣X1: n) = ∏i = 1mpθenc, θdec (yi∣Y0: i − 1, X1: n) = ∏i = 1mpθdec (yi∣Y0: i − 1, c), с c = fθenc (X).{m} p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _i | \ mathbf {Y} _ {0: i-1}, \ mathbf {c}), \ text {with} \ mathbf {c} = f _ {\ theta_ {enc}} (X). pθenc, θdec (Y1: m ∣X1: n) = i = 1∏m pθenc, θdec (yi ∣Y0: i − 1, X1: n) = i = 1 ∏m pθdec (yi ∣Y0: i − 1, c), где c = fθenc (X).

Во время вывода эффективные методы декодирования могут авторегрессивно сгенерировать целевую последовательность Y1: m \ mathbf {Y} _ {1: m} Y1: m.

Модель кодера-декодера на основе RNN взяла штурмом сообщество NLG. В В 2016 г. компания Google объявила о полной замене разработанной услуги перевода с помощью единой модели кодировщика-декодера на основе RNN (см. здесь).44 Нейронная сеть может определять распределение вероятностей по всем слова, т.е. p (y∣c, Y0: i − 1) p (\ mathbf {y} | \ mathbf {c}, \ mathbf {Y} _ {0: i-1}) p (y∣c , Y0: i − 1) как следует. Сначала сеть определяет отображение входов c, Y0: i − 1 \ mathbf {c}, \ mathbf {Y} _ {0: i-1} c, Y0: i − 1 во встроенное векторное представление y ′ \ Mathbf {y ‘} y ′, что соответствует целевому вектору RNN. Встроенный векторное представление y ′ \ mathbf {y ‘} y ′ затем передается на «язык модель головы «, что означает, что он умножается на слов. матрица внедрения , i.66 Sutskever et al. (2014) меняет порядок ввода так, чтобы в приведенном выше примере ввод векторы будут соответствовать x1 = car \ mathbf {x} _1 = \ text {car} x1 = car, x2 = a \ mathbf {x} _2 = \ text {a} x2 = a, x3 = buy \ mathbf { x} _3 = \ text {buy} x3 = buy, x4 = to \ mathbf {x} _4 = \ text {to} x4 = to, x5 = want \ mathbf {x} _5 = \ text {want} x5 = Хочу, x6 = I \ mathbf {x} _6 = \ text {I} x6 = I и x7 = EOS \ mathbf {x} _7 = \ text {EOS} x7 = EOS. В мотивация состоит в том, чтобы обеспечить более короткую связь между соответствующими пары слов, такие как x6 = I \ mathbf {x} _6 = \ text {I} x6 = I и y1 = Ich \ mathbf {y} _1 = \ text {Ich} y1 = Ich.Исследовательская группа подчеркивает, что обращение входной последовательности было ключевой причиной того, что их модель улучшена производительность машинного перевода.

Кодировщик-декодерВ 2017 г. Vaswani et al. представил Transformer и тем самым дал рождение модели на базе трансформатора кодировщика-декодера .

Аналогичен моделям кодировщика-декодера на базе RNN, трансформаторный модели кодировщика-декодера состоят из кодировщика и декодера, которые обе стопки из блоков остаточного внимания .Ключевое нововведение трансформаторные модели кодировщика-декодера заключается в том, что такое остаточное внимание блоки могут обрабатывать входную последовательность X1: n \ mathbf {X} _ {1: n} X1: n переменной длина nnn без отображения повторяющейся структуры. Не полагаясь на рекуррентная структура позволяет преобразовывать кодировщики-декодеры высокая степень распараллеливания, что делает модель на порядки больше вычислительно эффективен, чем модели кодировщика-декодера на основе RNN на современное оборудование.

Напоминаем, что для решения задачи от последовательности к последовательности нам необходимо найти отображение входной последовательности X1: n \ mathbf {X} _ {1: n} X1: n на выход последовательность Y1: m \ mathbf {Y} _ {1: m} Y1: m переменной длины mmm.Посмотрим как модели кодеров-декодеров на основе трансформаторов используются для поиска такого отображение.

Подобно моделям кодировщика-декодера на основе RNN, трансформатор на основе модели кодировщика-декодера определяют условное распределение целевых векторы Y1: n \ mathbf {Y} _ {1: n} Y1: n с заданной входной последовательностью X1: n \ mathbf {X} _ {1: n} X1: n:

pθenc, θdec (Y1: m∣X1: n). p _ {\ theta _ {\ text {enc}}, \ theta _ {\ text {dec}}} (\ mathbf {Y} _ {1: m} | \ mathbf {X} _ {1: n}). pθenc, θdec (Y1: m ∣X1: n).

Кодер на основе трансформатора кодирует входную последовательность X1: n \ mathbf {X} _ {1: n} X1: n в последовательность из скрытых состояний X‾1: n \ mathbf {\ overline { X}} _ {1: n} X1: n, таким образом определяя отображение:

fθenc: X1: n → X‾1: n.f _ {\ theta _ {\ text {enc}}}: \ mathbf {X} _ {1: n} \ to \ mathbf {\ overline {X}} _ {1: n}. fθenc: X1: n → X1: n.

Затем часть декодера на основе трансформатора моделирует условное распределение вероятностей последовательности целевых векторов Y1: n \ mathbf {Y} _ {1: n} Y1: n с учетом последовательности закодированных скрытых состояний X‾1: n \ mathbf {\ overline {X}} _ {1: n} X1: n:

pθdec (Y1: n∣X‾1: n). p _ {\ theta_ {dec}} (\ mathbf {Y} _ {1: n} | \ mathbf {\ overline {X}} _ {1: n}). pθdec (Y1: n ∣X1: n ).

По правилу Байеса это распределение может быть разложено на произведение условное распределение вероятностей целевого вектора yi \ mathbf {y} _iyi учитывая закодированные скрытые состояния X‾1: n \ mathbf {\ overline {X}} _ {1: n} X1: n и все предыдущие целевые векторы Y0: i − 1 \ mathbf {Y} _ {0: i-1} Y0: i − 1:

pθdec (Y1: n∣X‾1: n) = ∏i = 1npθdec (yi∣Y0: i − 1, X‾1: n).{n} p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _i | \ mathbf {Y} _ {0: i-1}, \ mathbf {\ overline {X}} _ {1: n}). pθdec (Y1: n ∣X1: n) = i = 1∏n pθdec (yi ∣Y0: i − 1, X1: n).

Трансформаторный декодер тем самым отображает последовательность закодированных скрытых указывает X‾1: n \ mathbf {\ overline {X}} _ {1: n} X1: n и все предыдущие целевые векторы Y0: i − 1 \ mathbf {Y} _ {0: i-1} Y0: i − 1 в вектор logit li \ mathbf {l} _ili. Логит вектор li \ mathbf {l} _ili затем обрабатывается операцией softmax для определить условное распределение pθdec (yi∣Y0: i − 1, X‾1: n) p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _i | \ mathbf {Y} _ {0: i -1}, \ mathbf {\ overline {X}} _ {1: n}) pθdec (yi ∣Y0: i − 1, X1: n), так же, как это делается для декодеров на основе RNN.Однако в отличие от Декодеры на основе RNN, распределение целевого вектора yi \ mathbf {y} _iyi явно (или напрямую) обусловлено всеми предыдущими целевыми векторами y0,…, yi − 1 \ mathbf {y} _0, \ ldots, \ mathbf {y} _ {i-1} y0,…, yi − 1 Как мы увидим позже деталь. 0-й целевой вектор y0 \ mathbf {y} _0y0 настоящим представлен специальный «начало предложения» BOS \ text {BOS} вектор BOS.

Определив условное распределение pθdec (yi∣Y0: i − 1, X‾1: n) p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _i | \ mathbf {Y} _ {0 : i-1}, \ mathbf {\ overline {X}} _ {1: n}) pθdec (yi ∣Y0: i − 1, X1: n), теперь мы можем авторегрессивно сгенерировать вывод и таким образом определить отображение входной последовательности X1: n \ mathbf {X} _ {1: n} X1: n в выходную последовательность Y1: m \ mathbf {Y} _ {1: m} Y1: m при выводе.

Давайте визуализируем полный процесс авторегрессивного поколения модели кодеров-декодеров на базе трансформатора.

Трансформаторный энкодер окрашен в зеленый цвет, а Трансформаторный декодер окрашен в красный цвет. Как и в предыдущем разделе, мы показываем, как английское предложение «Я хочу купить машину», представленное как x1 = I \ mathbf {x} _1 = \ text {I} x1 = I, x2 = want \ mathbf {x} _2 = \ text { want} x2 = want, x3 = to \ mathbf {x} _3 = \ text {to} x3 = to, x4 = buy \ mathbf {x} _4 = \ text {buy} x4 = buy, x5 = a \ mathbf {x} _5 = \ text {a} x5 = a, x6 = car \ mathbf {x} _6 = \ text {car} x6 = car и x7 = EOS \ mathbf {x} _7 = \ text {EOS} x7 = EOS переводится на немецкий: «Ich will ein Auto kaufen «определяется как y0 = BOS \ mathbf {y} _0 = \ text {BOS} y0 = BOS, y1 = Ich \ mathbf {y} _1 = \ text {Ich} y1 = Ich, y2 = will \ mathbf {y} _2 = \ text {will} y2 = will, y3 = ein \ mathbf {y} _3 = \ text {ein} y3 = ein, y4 = Auto, y5 = kaufen \ mathbf {y} _4 = \ text {Auto}, \ mathbf {y} _5 = \ text {kaufen} y4 = Auto, y5 = kaufen и y6 = EOS \ mathbf {y} _6 = \ text {EOS} y6 = EOS.

Сначала кодировщик обрабатывает всю входную последовательность X1: 7 \ mathbf {X} _ {1: 7} X1: 7 = «Я хочу купить машину» (представлен светом зеленые векторы) в контекстуализированную кодированную последовательность X‾1: 7 \ mathbf {\ overline {X}} _ {1: 7} X1: 7. Например. x‾4 \ mathbf {\ overline {x}} _ 4×4 определяет кодировка, которая зависит не только от ввода x4 \ mathbf {x} _4x4 = «buy», но и все остальные слова «я», «хочу», «к», «а», «машина» и «EOS», т.е. контекст.

Затем входная кодировка X‾1: 7 \ mathbf {\ overline {X}} _ {1: 7} X1: 7 вместе с BOS вектор, i.е. y0 \ mathbf {y} _0y0, подается на декодер. Декодер обрабатывает входные данные X‾1: 7 \ mathbf {\ overline {X}} _ {1: 7} X1: 7 и y0 \ mathbf {y} _0y0, чтобы первый логит l1 \ mathbf {l} _1l1 (показан более темным красным) для определения условное распределение первого целевого вектора y1 \ mathbf {y} _1y1:

pθenc, dec (y∣y0, X1: 7) = pθenc, dec (y∣BOS, я хочу купить машину EOS) = pθdec (y∣BOS, X‾1: 7). p _ {\ theta_ {enc, dec}} (\ mathbf {y} | \ mathbf {y} _0, \ mathbf {X} _ {1: 7}) = p _ {\ theta_ {enc, dec}} (\ mathbf {y} | \ text {BOS}, \ text {Я хочу купить машину EOS}) = p _ {\ theta_ {dec}} (\ mathbf {y} | \ text {BOS}, \ mathbf {\ overline { X}} _ {1: 7}).pθenc, dec (y∣y0, X1: 7) = pθenc, dec (y∣BOS, я хочу купить машину EOS) = pθdec (y∣BOS, X1: 7).

Затем выбирается первый целевой вектор y1 \ mathbf {y} _1y1 = Ich \ text {Ich} Ich из распределения (обозначено серыми стрелками) и теперь может быть снова подается на декодер. Теперь декодер обрабатывает как y0 \ mathbf {y} _0y0 = «BOS» и y1 \ mathbf {y} _1y1 = «Ich» для определения условного распределение второго целевого вектора y2 \ mathbf {y} _2y2:

pθdec (y∣BOS Ich, X‾1: 7). p _ {\ theta_ {dec}} (\ mathbf {y} | \ text {BOS Ich}, \ mathbf {\ overline {X}} _ {1: 7}).pθdec (y∣BOS Ich, X1: 7).

Мы можем снова выполнить выборку и создать целевой вектор y2 \ mathbf {y} _2y2 = «буду». Мы продолжаем в авторегрессивном режиме до тех пор, пока на шаге 6 не появится EOS. вектор выбирается из условного распределения:

EOS∼pθdec (y∣BOS Ich will ein Auto kaufen, X‾1: 7). \ text {EOS} \ sim p _ {\ theta_ {dec}} (\ mathbf {y} | \ text {BOS Ich будет ein Auto kaufen}, \ mathbf {\ overline {X}} _ {1: 7}). EOS∼pθdec (y∣BOS Ich будет ein Auto kaufen, X1: 7).

И так далее в авторегрессивном режиме.

Важно понимать, что энкодер используется только в первом прямой переход к карте X1: n \ mathbf {X} _ {1: n} X1: n в X‾1: n \ mathbf {\ overline {X}} _ {1: n} X1: n. Начиная со второго прямого прохода, декодер может напрямую использовать ранее рассчитанная кодировка X‾1: n \ mathbf {\ overline {X}} _ {1: n} X1: n. Для ясности, давайте проиллюстрируем первый и второй прямой проход для нашего пример выше.

Как видно, только на шаге i = 1i = 1i = 1 мы должны кодировать «Я хочу купить автомобиль EOS «на X‾1: 7 \ mathbf {\ overline {X}} _ {1: 7} X1: 7.На шаге i = 2i = 2i = 2 контекстные кодировки «Я хочу купить машину EOS» просто повторно используется декодером.

В 🤗Трансформаторах это авторегрессивное поколение выполняется под капотом.

при вызове метода .generate () . Воспользуемся одним из наших переводов

модели, чтобы увидеть это в действии.

от трансформаторов импортных MarianMTModel, MarianTokenizer

tokenizer = MarianTokenizer.from_pretrained («Хельсинки-НЛП / opus-mt-en-de»)

model = MarianMTModel.from_pretrained ("Хельсинки-НЛП / opus-mt-en-de")

input_ids = tokenizer («Я хочу купить машину», return_tensors = «pt»).input_ids

output_ids = model.generate (input_ids) [0]

печать (tokenizer.decode (output_ids))

Выход:

Ich will ein Auto kaufen

Вызов .generate () делает многие вещи скрытыми. Сначала проходит input_ids в кодировщик. Во-вторых, он передает заранее определенный токен, которым является символ MarianMTModel вместе с закодированными input_ids в декодер.11. Более подробно о том, как работает декодирование с поиском луча, можно

посоветовал прочитать этот блог

Почта.

В приложение мы включили фрагмент кода, который показывает, как простая Метод генерации может быть реализован «с нуля». Чтобы полностью понять, как авторегрессивное поколение работает под капотом, это Настоятельно рекомендуется прочитать Приложение.

Подводя итог:

- Энкодер на основе трансформатора определяет отображение от входа последовательность X1: n \ mathbf {X} _ {1: n} X1: n в контекстуализированную последовательность кодирования X‾1: n \ mathbf {\ overline {X}} _ {1: n} X1: n.

- Трансформаторный декодер определяет условное распределение pθdec (yi∣Y0: i − 1, X‾1: n) p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _i | \ mathbf {Y} _ {0: i-1}, \ mathbf {\ overline {X}} _ {1: n}) pθdec (yi ∣Y0: i − 1, X1: n).

- При соответствующем механизме декодирования выходная последовательность Y1: m \ mathbf {Y} _ {1: m} Y1: m может быть автоматически выбран из pθdec (yi∣Y0: i − 1, X‾1: n), ∀i∈ {1,…, m} p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _i | \ mathbf { Y} _ {0: i-1}, \ mathbf {\ overline {X}} _ {1: n}), \ forall i \ in \ {1, \ ldots, m \} pθdec (yi ∣ Y0: i − 1, X1: n), ∀i∈ {1,…, m}.

Отлично, теперь, когда мы получили общий обзор того, как работают модели кодировщиков-декодеров на базе трансформатора, мы можем погрузиться глубже в

как кодировщик, так и декодер части модели. В частности, мы

увидит, как именно кодировщик использует слой самовнимания

чтобы получить последовательность контекстно-зависимых векторных кодировок и как

Уровни самовнимания позволяют эффективно распараллеливать. Тогда мы будем

подробно объясните, как слой самовнимания работает в декодере

модель и как декодер зависит от выхода кодировщика с перекрестное внимание слоев для определения условного распределения pθdec (yi∣Y0: i − 1, X‾1: n) p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _i | \ mathbf { Y} _ {0: i-1}, \ mathbf {\ overline {X}} _ {1: n}) pθdec (yi ∣Y0: i − 1, X1: n).11 В случае "Helsinki-NLP / opus-mt-en-de" декодирование

параметры доступны

здесь,

где мы видим, что модель применяет поиск луча с num_beams = 6 .

Как упоминалось в предыдущем разделе, энкодер на базе трансформатора отображает входную последовательность в контекстуализированную последовательность кодирования: