Трансформатор. Виды трансформаторов.

Назначение трансформатора и его виды. Обозначение на схеме

Трансформатор – один из самых распространённых электротехнических устройств, как в бытовой технике, так и в силовой электронике.

Назначение трансформатора заключается в преобразовании электрического тока одной величины в другую, большую, или меньшую.

В отношении трансформаторов стоит помнить одно простое правило: постоянный ток они не преобразуют! Основное их назначение — это преобразование переменного, импульсного и пульсирующего тока. Если подвести к трансформатору постоянный ток, то получится лишь раскалённый кусок провода…

На принципиальных схемах трансформатор изображают в виде двух или более катушек, между которыми проводят линию. Вот так.

Катушка под номером Ⅰ символизирует первичную обмотку. К ней подводится напряжение, которое необходимо преобразовать: понизить или повысить — смотря что требуется. Со вторичных обмоток (Ⅱ и Ⅲ) уже снимается пониженное или повышенное напряжение. Как видите, вторичных обмоток может быть несколько.

Вертикальная линия между первичной и вторичной обмоткой символизирует магнитный сердечник или по-другому, магнитопровод.

Максимальный коэффициент полезного действия (КПД) трансформатора чрезвычайно высок и в некоторых случаях может быть более 90%. Благодаря малым потерям при преобразовании энергии трансформатор и получил такое широкое применение в электронике.

Основные функции трансформатора, которые более востребованы в бытовой электронике две, это:

Понижение переменного напряжения электрической сети 110/127/220В до уровня в несколько десятков или единиц вольт (5 – 48 и более вольт). Связано это с тем, что большинство электронных приборов состоит из полупроводниковых компонентов – транзисторов, микросхем, процессоров, которые прекрасно работают при достаточно низком напряжении питания.

Поэтому необходимо понижать напряжение до низких значений. Диапазон напряжения питания такой электроники как магнитолы, музыкальные центры, DVD – плееры, как правило, лежит в пределах 5 – 30 вольт. По этой причине понижающие трансформаторы заняли достойное место в бытовой электронике.

Гальваническая развязка электрической сети 220В от питающих цепей электроприборов. Понизить напряжение во многих случаях можно и без использования трансформаторов. Но к этому прибегают достаточно редко. Что самое главное при пользовании электроприбором? Конечно, безопасность!

Гальваническая развязка от электросети снижает риск поражения электрическим током за счёт того, что первичная и вторичная обмотки изолированы друг от друга. При электрическом пробое фазовое напряжение сети не попадёт на вторичную обмотку, а, следовательно, и на весь электроприбор.

Стоит отметить, что, например,

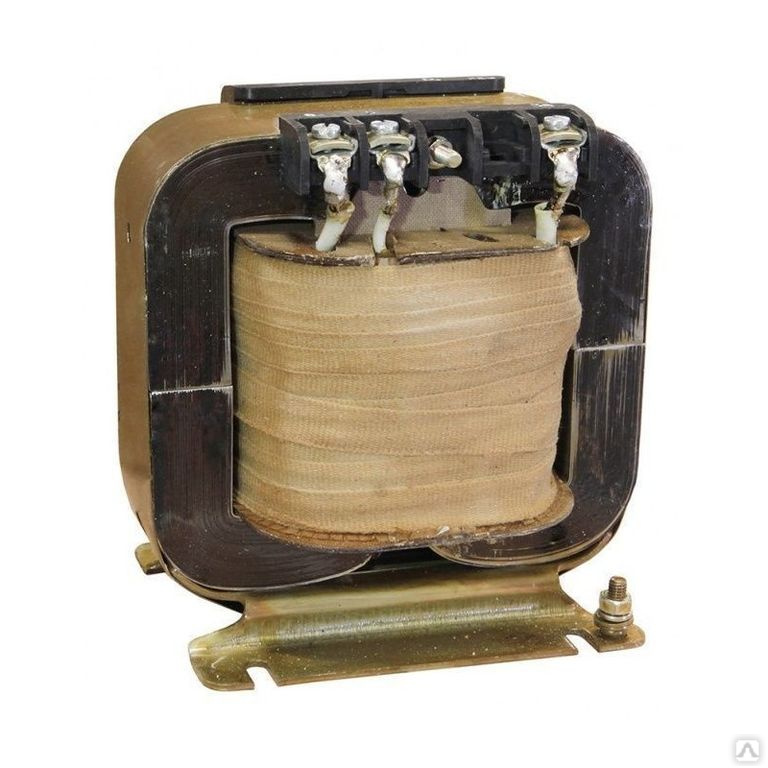

Конструктивно трансформатор состоит из двух и более обмоток – первичной, та, что подключается к сети, и вторичной, которая подключается к нагрузке (электроприбору). Обмотки представляют собой катушки медного или алюминиевого провода в лаковой изоляции. Обе катушки плотно наматываются на изоляционный каркас, который закрепляют на магнитопровод – сердечник. Магнитопровод изготавливают из магнитного материала. Для низкочастотных трансформаторов материалом магнитопровода служит пермаллой, трансформаторная сталь. Для более высокочастотных – феррит.

Магнитопровод низкочастотных трансформаторов состоит из набора Ш, П или Г-образных пластин. Наверняка вы уже видели такие у пунктов приёма цветного металлолома .

У высокочастотных маломощных трансформаторов роль сердечника может выполнять воздушная среда. Дело в том, что с ростом частоты преобразования габариты магнитопровода резко уменьшаются.

Если сравнить трансформатор лампового телевизора с тем, который установлен в современном полупроводниковом, то разница будет ощутима. Трансформатор лампового телевизора весит пару – тройку килограммов, в то время как высокочастотный трансформатор современного телевизора несколько десятков, либо сотен граммов. Выигрыш в габаритах и весе очевиден.

Уменьшение веса и габаритов трансформаторов достигается за счёт применения высокочастотных импульсных преобразователей, где трансформатор работает на частоте в 20 – 40 кГц, а не 50-60 герц, как в случае с обычным низкочастотным трансформатором. Увеличение рабочей частоты позволяет уменьшить размеры магнитопровода (сердечника), а также существенно снизить затраты на обмоточный провод, так как количество витков в обмотках высокочастотных трансформаторов невелико.

По конструктивному исполнению трансформаторы делят на несколько видов: стержневые, броневые и тороидальные (они же кольцевые). Стержневой вариант выглядит вот так.

Броневой же имеет боковые стержни без обмоток. Такая конструкция защищает от повреждений медные обмотки, но и затрудняет их охлаждение в процессе работы. Броневые трансформаторы наиболее распространены в электронике.

Наилучшими параметрами обладают тороидальные, или по-другому, кольцевые трансформаторы.

Их конструкция способствует хорошему охлаждению, а магнитный поток наиболее эффективно распределён вокруг обмоток, что уменьшает магнитный поток рассеяния и увеличивает КПД. Из-за магнитного потока рассеяния возникают потери, что снижает эффективность трансформатора.

Мощность трансформатора зависит от размеров сердечника и рабочей частоты преобразования. Во многих случаях мощность низкочастотного трансформатора (работающего на частоте 50-60 Гц) можно определить не прибегая к сложным расчётам. Об этом я уже рассказывал.

Иногда на практике требуется определить выводы первичной и вторичной обмоток. Вот несколько советов, которые помогут разобраться, как это сделать.

Первичная обмотка понижающего трансформатора всегда будет намотана более тонким проводом, чем вторичная. Связано это с тем, что при понижении напряжения возможно увеличение тока во вторичной обмотке, следовательно, нужен провод большего сечения.

В случае повышающего трансформатора вторичная обмотка наматывается более тонким проводом, чем первичная, так как максимальный ток вторичной обмотки будет меньше тока первичной.

В этой взаимосвязи и заключается преобразование: увеличиваем напряжение – уменьшается ток, уменьшаем напряжение – увеличивается ток.

Развитие силовой электроники привело к появлению, так называемых, электронных трансформаторов. Сам по себе электронный трансформатор не является электротехнической деталью — это законченное электронное устройство, которое выполняет функцию преобразования переменного напряжения.

Главная » Радиоэлектроника для начинающих » Текущая страница

Также Вам будет интересно узнать:

Трансформатор — урок. Физика, 9 класс.

Переменный ток обладает ещё одним важным свойством: его напряжение можно сравнительно легко менять — трансформировать (слово «трансформация» образовано от латинского слова transformo — «преобразую»). Достигается это посредством несложного устройства — трансформатора, созданного в \(1876\) году русским учёным Павлом Николаевичем Яблочковым.

Трансформатор — устройство, осуществляющее повышение и понижение напряжения переменного тока при неизменной частоте и незначительных потерях мощности.

Простейший трансформатор состоит из двух катушек изолированного провода и замкнутого стального сердечника, проходящего сквозь обе катушки. Катушки изолированы друг от друга и от сердечника. Одна из катушек, называемая первичной, включается в сеть переменного тока. Действие трансформатора основано на явлении электромагнитной индукции. Магнитное поле первичной катушки — переменное и меняется с той же частотой, что и ток в первичной катушке. Переменный ток в первой катушке создаёт в стальном сердечнике переменное магнитное поле. Это переменное магнитное поле пронизывает другую катушку, называемую вторичной, и создаёт в ней переменный индукционный ток.

Допустим, что первичная катушка имеет w1 витков, и по ней проходит переменный ток при напряжении U1. Вторичная обмотка имеет w2 витков, и в ней индуцируется переменный ток при напряжении U2.

Опыт показывает, что во сколько раз число витков вторичной катушки больше (или меньше) числа витков на первичной катушке, во столько же раз напряжение на вторичной катушке больше (или меньше) напряжения на первичной катушке:

U2U1=w2w1=k.

Величина \(k\) называется коэффициентом трансформации. Коэффициент равен отношению числа витков вторичной обмотки к числу витков в первичной обмотке.

Во сколько раз увеличивается напряжение на вторичной обмотке трансформатора, примерно во столько же раз уменьшается в ней сила тока при работе нагруженного трансформатора.

В результате мощность тока в первичной и вторичной обмотках трансформатора почти одинакова, поэтому коэффициент полезного действия (КПД) трансформатора близок к единице. КПД у мощных трансформаторов достигает \(99,5\) %.

Почему шумит трансформатор. Что влияет на уровень шума силовых трансформаторов

Главная причина шума работающего трансформатора – это явление магнитострикции. Чтобы понять его суть, вспомните, как работает трансформатор.

Как работает трансформатор?

Трансформатор состоит из двух катушек с намотанной проволокой. Они окружены металлическим сердечником с выраженными магнитными свойствами (ферромагнитный материал). Сердечник состоит из тонких пластин, скрепленных между собой.

Они окружены металлическим сердечником с выраженными магнитными свойствами (ферромагнитный материал). Сердечник состоит из тонких пластин, скрепленных между собой.

В трансформатор под нагрузкой поступает переменный электрический ток. Он попадает в первичную обмотку, создавая в ней электромагнитное поле. Оно передается сердечнику, а затем и вторичной обмотке. Магнитное поле во вторичной обмотке создает электрический ток, но уже с другим значением напряжения. Напряжение на выходе из трансформатора зависит от количества витков проволоки в обмотках. Так при помощи трансформатора понижается напряжение электрического тока с высоковольтной линии до значений, которые используются в бытовых электрических сетях.

Где и почему рождается шум трансформатора?

Металлический сердечник состоит из зон микроскопического размера. В выключенном трансформаторе магнитное поле сердечника беспорядочно. Но как только в первичной катушке возникает магнитный поток – магнитное поле в сердечнике упорядочивается. В результате материал сердечника немного деформируется. Так сердечник сжимается и разжимается. Это и есть магнитострикция. А в результате возникают вибрации. Они производят характерный гул низкой частоты, который мы слышим при работе трансформатора.

Так как через трансформатор пропускается переменный электрический ток, то и магнитное поле меняет свое направление дважды за фазу. То есть, если наши сети работают с током частоты 50 Гц, то обмотки трансформатора колеблются с частотой в два раза больше – 100 Гц. А вот американские трансформаторы работают с током 60 Гц, поэтому гудят с частотой 120 Гц.

Почему некоторые трансформаторы гудят сильнее?

Есть и другие причины, которые заставляют трансформатор гудеть.

- Плохая изоляция витков катушки.

Если изоляция витков нарушена, то между ними могут проскакивать искры. В этом случае мы слышим звуковые щелчки. По той же причине в сырую погоду сильнее гудят провода высоковольтной линии электропередач.

Важно! На деле звук работающего трансформатора ощутимо меняется, если изоляция уже окончательно повреждена. Поэтому регулярно проверяйте трансформатор, замеряйте уровень шума.

- Плохо закрепленные части трансформатора.

Незакрепленные провода и зажимы тоже начинают колебаться при работе оборудования. Вибрация создает звуковые колебания. А мы слышим гул или даже грохотание из-под обшивки трансформатора.

Уровень шума трансформатора не должен превышать определенных величин. Например, на масляные силовые трансформаторы распространяется ГОСТ 12.2.024-87. Для снижения шумового загрязнения рядом с трансформаторами устанавливают специальные экраны или в конструкции их самих предусматривают глушители.

Тороїдальні трансформатори — TORENERGO

Преимущества тороидальных трансформаторов

► тороидальный трансформатор — меньший объемПри использовании тороидальных трансформаторов поставляемых со свободными витыми выводами можно добиться экономии до 64 % занимаемого объёма по сравнению с обычными трансформаторами с шихтованными сердечниками (очень часто легче подключить оборудование именно с помощью выводов из трансформатора, а не клеммников).

► тороидальный трансформатор — меньший весЭкономия до 50 %. Тороидальный (кольцевой) сердечник имеет идеальную форму, позволяющую изготовить трансформатор, используя минимальное количество материала. Все обмотки симметрично распределены по всей окружности сердечника, благодаря чему значительно уменьшается длина обмотки. Это ведёт к уменьшению сопротивления обмотки и повышению коэффициента полезного действия. Возможна более высокая магнитная индукция, так как магнитный ток проходит в том же направлении, в каком ориентирована кремнистая сталь ядра во время прокатки. Можно использовать более высокую плотность тока в проводах, так как вся поверхность тороидального сердечника позволяет эффективно охлаждать медные провода. Потери в железе очень низки – типическое значение составляет 1,1 Вт при индукции 1,7 Тл и частоте 50/60 Гц. Это обеспечивает очень низкий ток намагничивания, способствующий изумительной тепловой нагрузочной способности тороидального трансформатора.

Это обеспечивает очень низкий ток намагничивания, способствующий изумительной тепловой нагрузочной способности тороидального трансформатора.

Тороидальные трансформаторы изготавливаются из качественной высокоиндукционной электротехнической стали, что позволяет достичь приблизительно 50 % экономии в сравнении с обычными трансформаторами с шихтованными сердечниками, а также существенной экономии пространства в сравнении с тороидальными сердечниками других производителей, использующих для своей продукции сталь более низкого качества.

► тороидальный трансформатор — гибкость размеровТороидальные трансформаторы предлагают высокую степень приспосабливаемости / гибкости размеров в сравнении с обычными трансформаторами с сердечниками, составленными из отдельных пластин. Поскольку сердечники тороидальных трансформаторов изготавливаются на наших собственных мощностях, имеющих высококачественные электрические печи для их отжига, это позволяет изготовить сердечник практически любого диаметра и высоты. Наши специалисты могут «на заказ» спроектировать тороидальный трансформатор так, чтобы он точно входил в стесненное пространство, что, как правило, невозможно при использовании обычных трансформаторов.

► тороидальный трансформатор — простой монтажСтандартный монтаж трансформаторов мощностью до 1 кВА осуществляется посредством одной (двух, сверху и снизу) центрирующей пластиковой шайбы (либо металлической шайбы с защитной резиновой прокладкой) и монтажного болта, проходящего сквозь центральное отверстие тороидального трансформатора, что обеспечивает быстрый и простой монтаж.

► тороидальный трансформатор — более низкий уровень шумаТак как сердечники изготавливаются из сплошной ленты высококачественной стали и приварены с обеих сторон, в их конструкции нет там ни воздушных зазоров, ни лишних стальных пластин, которые могли бы обусловливать вибрацию. Эта стабильность также поддерживается медной обмоткой, плотно облегающей всю окружность сердечника.

Эта стабильность также поддерживается медной обмоткой, плотно облегающей всю окружность сердечника.

Качество стали обеспечивает низкую магнитострикцию и низкие потери на рассеяние. Эта комбинация качеств почти полностью устраняет гудение и шум, наблюдаемый при эксплуатации обычных трансформаторов и тороидальных трансформаторов от производителей, использующих сталь более низкого качества.

► тороидальный трансформатор — небольшое рассеяниеПриблизительно на 85 — 95 % меньшее рассеяние по сравнению с обычными трансформаторами. Достижение низкого значения рассеяния является важным аспектом для конструктора оборудования, так как это явление может создавать нежелательные помехи в результате интерференции с чувствительными электронными цепями. Тороидальный трансформатор обеспечивает общее снижение уровня магнитных помех в соотношении 8:1 по сравнению с традиционными типами обычных трансформаторов рамочной формы.

► тороидальный трансформатор — цена и ценностьПередовая производственная технология и экономия материалов, вытекающая из более эффективного проекта, делают сегодняшние тороидальные трансформаторы очень выгодными в ценовом отношении по сравнению с обычными трансформаторами аналогичной мощности. Если учесть прочие скрытые выгоды, такие как низкое рассеяние, экономия энергии (во время эксплуатации), меньшая горизонтальная проекция и меньший вес, преимущества тороидальных трансформаторов существенно возрастают. В общем и целом, чем больше мощность тороидальных трансформаторов, тем ниже их цена по сравнению с традиционными типами.

► тороидальный трансформатор — качество и надежностьГарантийный срок эксплуатации тороидальных трансформаторов составляет 24 месяца. Кроме того, идя на встречу пожеланиям некоторых заказчиков, многие модели тороидальных трансформаторов изготавливаются с применением технологии межслоевого изолирования. Это позволяет на порядок повысить надёжность тороидальных трансформаторов и свести вероятность образования короткозамкнутых витков практически к нулю.

Трансформатор ТН 60, 6, 12, 18, 24 вольт, 160 ватт,

Описание Трансформатор ТН 60, 6, 12, 18, 24 вольт, 160 ватт,

Универсальный трансформаторы ТН-60 могут выдавать при последовательном и параллельном соединении напряжение 6, 12, 18, 24, 27 вольт с током до 13 ампер. Гражданская версия сохранила достоинства военных ТН и производятся под маркой ТН 60-220-50, они имеют простую первичную обмотку на 220 и 240 вольт, без отводков и такую же нумерацию выводов, как у трансформаторов серии ТН-60 127/220 в. Все параметры, габариты и установочный размер, и вес трансформаторов ТН-60 на 220 в, такие же, как у армейских трансформаторов ТН-60 127/220 В. Очень удобный и надежный трансформатор, позволяет получить любое напряжение от 1.5 до 27 вольт. Обмотки намотаны точно, виток в виток, что позволяет их включить параллельно и получить больший ток. Для получения выходных напряжений, больших чем 6,3 В, вторичные накальные обмотки соединяются последовательно в согласном включении.

Схема параллельного включения обмоток ТН 61.

Напряжение на отводах первичных обмоток трансформаторов ТН-60 составляют:

- между выводами 7 и 8 -=6,3 В;

- между выводами 7,8 + 9,10 = 12 В;

- между выводами 7,8 + 9,10 +11, 13 = 18 В;

- между выводами 7,8 + 9,10 +11, 13 +14, 16 = 24 В;

- напряжение 220 в, подается на выводы 1 и 5.

- Сердечник: ШЛ25х32

- Мощность: 160 Вт

- Ток первичной обмотки: 1,5/0,85 А

- Масса: 2,75 кг

|

Таб.

1. Электрические параметры трансформатора ТН60-220-50

1. Электрические параметры трансформатора ТН60-220-50

| Рис2. Электрическая принципиальная схема накального трансформатора ТН60-220-50 |

| Рис3. Конструкция и размеры трансформатора ТН 60-220-50 |

Трансформатор ТМН

По заказу возможно изготовление и поставка трехобмоточных трансформаторов (ТМТН, ТДТН), имеющих три группы выводов: ВН напряжением 110 кВ, СН на 6-10 кВ, НН на 0,4 кВ.

9.12. Корректированные уровни звуковой мощности трансформаторов с пониженным уровнем шума

| Типовая мощность трансформатора, кВА |

Корректированный уровень звуковой мощности, LPA, дБА 6-110 кВ |

| 1000 | 65 |

| 1600 | 67 |

| 2500 | 68 |

| 4000 | 71 |

| 6300 | 73 |

| 10000 | 76 |

| 16000 | 80 |

| 25000 | 81 |

Основные технические характеристики

| Тип трансформатора |

ТМН, ТМНС, ТДН, ТДНС, ТРДН, ТРДНС |

|

Мощность |

1000 — 25 000 кВА |

|

Группа соединения обмоток | Y/D-11, D/D-0, D/Yn-11, Y/Yn-0 |

|

Материал обмоток ВН и НН |

алюминий/медь |

|

Номинальное высшее напряжение |

10,5 — 110 кВ |

|

Номинальное низшее напряжение |

690 В, 6 кВ, 10 кВ |

|

Количество ступеней регулирования напряжения |

± 8 х 1,5% ± 8 х 1,25% ± 6 х 1,5% ± 4 х 2,5% |

|

Номинальное значение климатических факторов |

У1, УХЛ1 по ГОСТ 15150 и ГОСТ 15543. |

|

Охлаждение |

AN (естественное) — до 10 000 кВА AF (принудительное) — от 10 000 кВА |

| Температура эксплуатации, транспортировки и хранения |

— 45 … + 40 °С для У1 — 60 … + 40 °С для УХЛ1 |

|

Срок службы |

30 лет |

|

Гарантийный срок |

до 5 лет |

|

Стандарт |

ГОСТ Р 52719-2007, ГОСТ 11920-85, ГОСТ 1516.3-96 |

|

Специальное исполнение |

по заказу клиента |

Конструктивные особенности

Магнитный сердечник изготавливается из высококачественной электротехнической стали марки Э3409, Э3410, Э3411 (тонколистовой холоднокатаной анизотропной стали с двухсторонним покрытием). Шихтовка магнитопровода осуществляется по технологии step-lap, что обеспечивает малые потери холостого хода и приводит к снижению уровня шума.

Обмотки ВН — многослойные или непрерывные, в зависимости от мощности и параметров трансформатора. Изготавливаются из медного или алюминиевого провода в бумажной изоляции.

Обмотки НН производятся из алюминиевой/ медной ленты (до 4000 кВА) с межслойной изоляцией из кабельной бумаги или из медного провода (более 4000 кВА).

Бак – цельносварной, усиленной конструкции, производится из стального листа толщиной 4-12 мм для трансформаторов до 10 000 кВА и 12-20 мм — свыше 10 000 кВА. Конструкция баков представляет собой жесткий каркас, усиленный ребрами жесткости.

Конструкция баков представляет собой жесткий каркас, усиленный ребрами жесткости.

На крышке трансформатора расположены выводы ВН и НН, расширитель, устройство РПН, газовое реле, серьги для подъема и перемещения трансформатора, гильза для установки спиртового термометра, патрубок для заливки трансформаторного масла с установленным в него предохранительным клапаном. К торцевой части баков ТМН и ТДН крепится шкаф управления устройством РПН. В нижней части бака имеется пробка или кран для отбора пробы и слива масла, а также пластины заземления, расположенные с двух сторон. К дну бака приварены лапы (опоры) из стандартного швеллера.

На стенках бака имеются фланцы с кранами для присоединения съемных радиаторов, которые служат для охлаждения трансформатора. Радиаторы – панельные, толщина стенки 2 мм.

Наружная поверхность бака окрашена атмосферостойкими красками серых тонов (возможно изменение окраски по требованию заказчика). По заказу клиента возможна обработка баков и крышки методом горячего цинкования, что позволит использовать трансформатор в зоне с влажным климатом.

Расширители трансформатора снабжены двумя указателями уровня масла. По заказу потребителей трансформаторы могут изготавливаться с указателем нижнего предельного уровня масла и включать в себя датчики уровня.

Для трансформаторов климатического исполнения УХЛ1 используется масло, стойкое к низким температурам — имеющее температуру гелеобразования – 65 ˚С.

Условия эксплуатации

Эксплуатация трансформатора осуществляется согласно руководству по эксплуатации завода-изготовителя, действующим «Правилам технической эксплуатации», «Правилам устройства электроустановок».

Климатическое исполнение и категория размещения трансформаторов У1 или УХЛ1 — по ГОСТ 15150, при этом:

— окружающая среда не взрывоопасная, не содержащая токопроводящей пыли;

— высота установки над уровнем моря не более 1000 м;

— режим работы длительный;

— трансформаторы в стандартном исполнении не предназначены для работы в условиях химически активных сред.

Требования по эксплуатации

Трансформаторы марки «Трансформер» рассчитаны на продолжительную работу при повышениях напряжения, подводимого к любому ответвлению обмотки ВН, над номинальным напряжением данного ответвления но не более 10%. При этом мощность не должна превышать номинальную.

Комплектация

В обязательную комплектацию трансформаторов ТМН марки «Трансформер» входят:

- расширитель с указателем уровня масла,

- предохранительная труба или предохранительный клапан,

- катки или поворотные каретки,

- радиаторы; для трансформаторов ТДН – радиаторы с вентиляторами,

- шкаф автоматического управления системой охлаждения (для трансформаторов с системой охлаждения Д),

- встроенные трансформаторы тока,

- коробка зажимов для присоединения контрольных и силовых кабелей,

- газовое реле для защиты трансформатора,

- манометрические сигнализирующие термометры с круговой шкалой,

- вводы,

- устройство РПН комплектно с аппаратурой автоматического регулирования,

- воздухосушитель,

- клеммная коробка – для трансформаторов с установленными электроконтактными мановакуумметрами и термометрами с электрическими контактами.

В дополнительной комплектации (опция) — мановакуумметры с переставными сигнальными контактами, комплект запасных частей и необходимого специального инструмента.

Упаковка и транспортировка

Трансформаторы отгружаются без упаковки, при этом выводы ВН и НН защищаются от повреждений при транспортировке. По требованию заказчика изделия могут упаковываться в транспортную тару – ящики. Способ упаковки согласовывается с заказчиком

Трансформатор перевозится в частично разобранном виде (без радиаторов и расширителя), высушенными и заполненными трансформаторным маслом. Дополнительно осуществляется поставка масла для доливки в трансформаторы.

Дополнительно осуществляется поставка масла для доливки в трансформаторы.

Не допускается транспортирование трансформаторов, не раскрепленных относительно транспортных средств. При перевозке изделия не допускается резких торможений и разгонов, излишних вибраций и толчков.

Гарантия

Гарантия производителя — до 5 лет. Срок службы — 30 лет.

Специалисты производственной группы «Трансформер» оказывают содействие в решении вопросов доставки изделий до места установки. Транспортные услуги, а также услуги по диагностике трансформаторов, монтажным и ремонтным работам оговариваются сторонами отдельно.

Трансформатор ТВК-10

Назначение и область применения

Трансформатор тока ТВК-10 опорный, предназначен для передачи сигнала измерительной информации приборам измерения, защиты, сигнализации и управления в электрических цепях переменного тока частотой 50 Гц класса напряжения 10 кВ.

Трансформатор устанавливается в комплектные распределительные устройства (КРУ, КРУН) внутренней установки, а также в сборные камеры одностороннего обслуживания (КСО) для изолирования цепей вторичных соединений от высокого напряжения.

Трансформаторы изготавливаются в климатическом исполнении «У» или «Т», категории размещения 3 или 2 по ГОСТ 15150.

Технические параметры

Наименование параметра | Значение |

Номинальное напряжение, кВ | 10 |

Номинальный первичный ток, А | 20-1500 |

Номинальный вторичный ток, А | 5 |

Количество вторичных обмоток | 2 |

Номинальная вторичная нагрузка с коэффициентом мощности cosφ2=0,8, В-А: | |

обмотки для измерения | 10 |

обмотки для защиты | 15 |

Класс точности обмотки: для измерения для защиты | |

для измерения: | 0,5 |

для защиты: | 10P |

Ток односекундной термической стойкости, кА | 1,88 — 30 |

Ток электродинамической стойкости, кА | 7,0-76,5 |

Номинальная предельная кратность обмотки для защиты | 12 |

Габаритные и установочные размеры

The Illustrated Transformer — Джей Аламмар — Визуализация машинного обучения по одной концепции за раз.

Обсуждения:

Hacker News (65 баллов, 4 комментария), Reddit r / MachineLearning (29 баллов, 3 комментария)

Переводы: Испанский, Китайский (упрощенный), Корейский, Русский, Французский, Японский

Смотреть: лекция MIT по теме «Глубокое обучение» со ссылкой на эту публикацию

В предыдущем посте мы рассмотрели «Внимание» — повсеместный метод в современных моделях глубокого обучения.Внимание — это концепция, которая помогла повысить производительность приложений нейронного машинного перевода. В этом посте мы рассмотрим The Transformer — модель, которая привлекает внимание для повышения скорости обучения этих моделей. Трансформеры превосходят модель нейронного машинного перевода Google в определенных задачах. Однако самое большое преимущество заключается в том, что The Transformer поддается распараллеливанию. Фактически, Google Cloud рекомендует использовать The Transformer в качестве эталонной модели для использования своего предложения Cloud TPU.Итак, давайте попробуем разбить модель на части и посмотрим, как она работает.

Трансформатор был предложен в статье «Внимание — это все, что вам нужно». Его реализация в TensorFlow доступна как часть пакета Tensor2Tensor. Группа НЛП из Гарварда создала руководство с аннотациями к статье с использованием PyTorch. В этом посте мы попытаемся немного упростить вещи и представить концепции одну за другой, чтобы, надеюсь, облегчить понимание людям без глубоких знаний предмета.

2020 Обновление : Я создал видео «Рассказанный трансформер», в котором более мягкий подход к теме:

Взгляд высокого уровня

Давайте начнем с рассмотрения модели как единого черного ящика. В приложении машинного перевода оно берет предложение на одном языке и выводит его перевод на другом.

Раскрывая эту доброту Оптимуса Прайма, мы видим компонент кодирования, компонент декодирования и связи между ними.

Компонент кодирования представляет собой стек кодировщиков (на бумаге шесть из них складываются друг на друга — в числе шесть нет ничего волшебного, можно определенно поэкспериментировать с другими компоновками). Компонент декодирования представляет собой стек декодеров с одинаковым числом.

Все кодировщики идентичны по структуре (но у них нет общих весов). Каждый из них разбит на два подслоя:

Входные данные кодировщика сначала проходят через слой самовнимания — слой, который помогает кодировщику смотреть на другие слова во входном предложении, когда он кодирует определенное слово.Позже в этой статье мы более подробно рассмотрим самовнимание.

Выходные данные слоя самовнимания передаются в нейронную сеть с прямой связью. Точно такая же сеть прямой связи независимо применяется к каждой позиции.

У декодера есть оба этих уровня, но между ними есть уровень внимания, который помогает декодеру сосредоточиться на соответствующих частях входного предложения (аналогично тому, что делает внимание в моделях seq2seq).

Использование тензоров в картине

Теперь, когда мы увидели основные компоненты модели, давайте начнем смотреть на различные векторы / тензоры и то, как они перемещаются между этими компонентами, чтобы превратить входные данные обученной модели в выходные данные.

Как и в случае с приложениями НЛП в целом, мы начинаем с превращения каждого входного слова в вектор с помощью алгоритма встраивания.

Каждое слово вложено в вектор размером 512. Мы представим эти векторы этими простыми прямоугольниками.

Встраивание происходит только в самый нижний кодировщик. Абстракция, которая является общей для всех кодировщиков, заключается в том, что они получают список векторов, каждый из которых имеет размер 512. В нижнем кодировщике это будет слово embeddings, но в других кодировщиках это будет выход кодировщика, который находится непосредственно под . Размер этого списка — это гиперпараметр, который мы можем установить — в основном это будет длина самого длинного предложения в нашем наборе обучающих данных.

Размер этого списка — это гиперпараметр, который мы можем установить — в основном это будет длина самого длинного предложения в нашем наборе обучающих данных.

После встраивания слов в нашу входную последовательность каждое из них проходит через каждый из двух уровней кодировщика.

Здесь мы начинаем видеть одно ключевое свойство преобразователя, а именно то, что слово в каждой позиции проходит свой собственный путь в кодировщике. Между этими путями на уровне самовнимания есть зависимости.Однако слой прямой связи не имеет этих зависимостей, и, таким образом, различные пути могут выполняться параллельно при прохождении через слой прямой связи.

Затем мы заменим пример более коротким предложением и посмотрим, что происходит на каждом подуровне кодировщика.

Теперь мы кодируем!

Как мы уже упоминали, кодировщик получает в качестве входных данных список векторов. Он обрабатывает этот список, передавая эти векторы в слой «самовнимания», затем в нейронную сеть с прямой связью, а затем отправляет выходные данные вверх следующему кодировщику.

Слово в каждой позиции проходит процесс самовнимания. Затем каждый из них проходит через нейронную сеть с прямой связью — точно такую же сеть, и каждый вектор проходит через нее отдельно.

Самовнимание на высоком уровне

Не дайте себя обмануть, если я использую слово «самовнимание», как будто это понятие должно быть знакомо каждому. Я лично никогда не сталкивался с этой концепцией до тех пор, пока не прочитал статью «Все, что вам нужно». Давайте разберемся, как это работает.

Скажем, следующее предложение является вводным предложением, которое мы хотим перевести:

” Животное не переходило улицу, потому что слишком устало ”

Что означает «оно» в этом предложении? Относится ли это к улице или к животному? Это простой вопрос для человека, но не такой простой для алгоритма.

Когда модель обрабатывает слово «оно», самовнимание позволяет ей ассоциировать «это» с «животным».

По мере того, как модель обрабатывает каждое слово (каждую позицию во входной последовательности), самовнимание позволяет ей смотреть на другие позиции во входной последовательности в поисках подсказок, которые могут помочь улучшить кодирование этого слова.

Если вы знакомы с RNN, подумайте, как поддержание скрытого состояния позволяет RNN включать свое представление предыдущих слов / векторов, которые она обработала, с текущим, который она обрабатывает. Самовнимание — это метод, который Трансформер использует для «запекания» других релевантных слов в словах, которые мы обрабатываем в данный момент.

Поскольку мы кодируем слово «оно» в кодировщике №5 (верхний кодировщик в стеке), часть механизма внимания фокусировалась на «Животном» и запекла часть его представления в кодировке «оно».

Обязательно ознакомьтесь с записной книжкой Tensor2Tensor, где вы можете загрузить модель Transformer и изучить ее с помощью этой интерактивной визуализации.

Внимание к себе в деталях

Давайте сначала посмотрим, как вычислить самовнимание с помощью векторов, а затем перейдем к тому, как это на самом деле реализовано — с помощью матриц.

Первый шаг при вычислении самовнимания — создать три вектора из каждого входного вектора кодировщика (в данном случае — вложение каждого слова).Итак, для каждого слова мы создаем вектор запроса, вектор ключа и вектор значения. Эти векторы создаются путем умножения вложения на три матрицы, которые мы обучили в процессе обучения.

Обратите внимание, что эти новые векторы меньше по размерности, чем вектор внедрения. Их размерность составляет 64, в то время как векторы ввода / вывода встраивания и кодировщика имеют размерность 512. Они НЕ ДОЛЖНЫ быть меньше, это выбор архитектуры, позволяющий сделать вычисление многогранного внимания (в основном) постоянным.

Умножение x1 на весовую матрицу WQ дает q1, вектор «запроса», связанный с этим словом.

В итоге мы создаем проекцию «запроса», «ключа» и «значения» для каждого слова во входном предложении.

В итоге мы создаем проекцию «запроса», «ключа» и «значения» для каждого слова во входном предложении.Что такое векторы «запроса», «ключа» и «значения»?

Это абстракции, которые полезны для вычисления внимания и размышления о нем. После того, как вы перейдете к прочтению того, как рассчитывается внимание ниже, вы будете знать почти все, что вам нужно знать о роли каждого из этих векторов.

Второй шаг в вычислении самовнимания — это подсчет баллов. Предположим, мы вычисляем внимание к себе для первого слова в этом примере — «Мышление». Нам нужно сопоставить каждое слово входного предложения с этим словом. Оценка определяет, сколько внимания следует уделять другим частям входного предложения, когда мы кодируем слово в определенной позиции.

Оценка рассчитывается как скалярное произведение вектора запроса на ключевой вектор соответствующего слова, которое мы оцениваем.Итак, если мы обрабатываем самовнимание для слова в позиции №1, первая оценка будет скалярным произведением q1 и k1. Вторая оценка будет скалярным произведением q1 и k2.

Третий и четвертый этапы заключаются в разделении оценок на 8 (квадратный корень из размерности ключевых векторов, используемых в статье — 64. Это приводит к получению более стабильных градиентов. Здесь могут быть и другие возможные значения, но это значение по умолчанию), затем передайте результат через операцию softmax.Softmax нормализует оценки, чтобы все они были положительными и в сумме составляли 1.

.Эта оценка softmax определяет, насколько каждое слово будет выражено в этой позиции. Очевидно, что слово в этой позиции будет иметь наивысший балл softmax, но иногда полезно обратить внимание на другое слово, имеющее отношение к текущему слову.

Пятый шаг — это умножение каждого вектора значений на оценку softmax (при подготовке к их суммированию). Интуиция здесь состоит в том, чтобы сохранить неизменными значения слов, на которых мы хотим сосредоточиться, и заглушить не относящиеся к делу слова (умножив их на крошечные числа, такие как 0. 001, например).

001, например).

Шестой этап заключается в суммировании векторов взвешенных значений. Это производит вывод слоя самовнимания в этой позиции (для первого слова).

На этом расчет самовнимания завершен. Результирующий вектор — это тот, который мы можем отправить в нейронную сеть с прямой связью. Однако в реальной реализации этот расчет выполняется в матричной форме для более быстрой обработки. Итак, давайте посмотрим на это теперь, когда мы увидели интуицию вычисления на уровне слов.

Матрица расчета самовнимания

Первым шагом является вычисление матриц запроса, ключа и значения. Мы делаем это, упаковывая наши вложения в матрицу X и умножая ее на матрицы весов, которые мы обучили (WQ, WK, WV).

Каждая строка в матрице X соответствует слову во входном предложении. Мы снова видим разницу в размере вектора встраивания (512 или 4 прямоугольника на рисунке) и векторов q / k / v (64 или 3 прямоугольника на рисунке).

Наконец, , поскольку мы имеем дело с матрицами, мы можем сжать шаги со второго по шестой в одной формуле, чтобы вычислить результаты слоя самовнимания.

Расчет самовнимания в матричной форме

Многоголовый зверь

В статье дополнительно усовершенствован слой самовнимания, добавлен механизм, называемый «многоглавым» вниманием. Это улучшает производительность слоя внимания двумя способами:

Расширяет способность модели фокусироваться на разных позициях. Да, в приведенном выше примере z1 содержит немного любой другой кодировки, но в ней может преобладать само слово.Было бы полезно, если бы мы переводили предложение вроде «Животное не перешло улицу, потому что оно слишком устало», мы хотели бы знать, к какому слову «оно» относится.

Он дает слою внимания несколько «подпространств представления». Как мы увидим далее, с многоголовым вниманием у нас есть не только один, но и несколько наборов весовых матриц запроса / ключа / значения (Трансформатор использует восемь головок внимания, поэтому мы получаем восемь наборов для каждого кодировщика / декодера).

. Каждый из этих наборов инициализируется случайным образом.Затем, после обучения, каждый набор используется для проецирования входных вложений (или векторов из нижних кодировщиков / декодеров) в другое подпространство представления.

. Каждый из этих наборов инициализируется случайным образом.Затем, после обучения, каждый набор используется для проецирования входных вложений (или векторов из нижних кодировщиков / декодеров) в другое подпространство представления.

С многоголовым вниманием мы поддерживаем отдельные весовые матрицы Q / K / V для каждой головы, в результате чего получаются разные матрицы Q / K / V. Как и раньше, мы умножаем X на матрицы WQ / WK / WV, чтобы получить матрицы Q / K / V.

Если мы проделаем тот же расчет самовнимания, который мы описали выше, всего восемь раз с разными весовыми матрицами, мы получим восемь разных Z-матриц

Это оставляет нам небольшую проблему.Слой прямой связи не ожидает восьми матриц — он ожидает единственную матрицу (вектор для каждого слова). Итак, нам нужен способ сжать эти восемь в единую матрицу.

Как мы это делаем? Мы объединяем матрицы, а затем умножаем их на дополнительную матрицу весов WO.

Вот и все, что нужно для многоглавого самовнимания. Я понимаю, что это довольно много матриц. Позвольте мне попытаться объединить их все в один визуальный ряд, чтобы мы могли рассматривать их в одном месте

Теперь, когда мы коснулись головок внимания, давайте вернемся к нашему предыдущему примеру, чтобы увидеть, на чем фокусируются различные головы внимания, когда мы кодируем слово «оно» в нашем примере предложения:

Когда мы кодируем слово «оно», одна голова внимания больше всего сосредотачивается на «животном», а другая — на «усталом» — в некотором смысле, представление модели слова «оно» вписывается в некоторые из представлений. как «животное», так и «уставшее».

Однако, если мы добавим к изображению все внимание, интерпретировать вещи будет сложнее:

Представление порядка последовательности с использованием позиционного кодирования

В модели, которую мы описали до сих пор, отсутствует одна вещь, так это способ учесть порядок слов во входной последовательности.

Для решения этой проблемы преобразователь добавляет вектор к каждому встраиванию входа. Эти векторы следуют определенному шаблону, который модель изучает, что помогает ей определять положение каждого слова или расстояние между разными словами в последовательности.Интуиция здесь заключается в том, что добавление этих значений к вложениям обеспечивает значимые расстояния между векторами встраивания, когда они проецируются в векторы Q / K / V и во время внимания скалярного произведения.

Чтобы дать модели ощущение порядка слов, мы добавляем векторы позиционного кодирования, значения которых следуют определенному шаблону.

Если мы предположим, что вложение имеет размерность 4, фактическое позиционное кодирование будет выглядеть так:

Реальный пример позиционного кодирования с размером вложения игрушки 4

Как мог бы выглядеть этот узор?

На следующем рисунке каждая строка соответствует позиционному кодированию вектора.Таким образом, первая строка будет вектором, который мы добавим к встраиванию первого слова во входной последовательности. Каждая строка содержит 512 значений — каждое от 1 до -1. Мы присвоили им цветовую кодировку, чтобы узор был виден.

Реальный пример позиционного кодирования для 20 слов (строк) с размером встраивания 512 (столбцов). Вы можете видеть, что он разделен пополам по центру. Это потому, что значения левой половины генерируются одной функцией (которая использует синус), а правая половина генерируется другой функцией (которая использует косинус).Затем они объединяются, чтобы сформировать каждый из векторов позиционного кодирования.

Формула позиционного кодирования описана в статье (раздел 3.5). Вы можете увидеть код для генерации позиционных кодировок в get_timing_signal_1d () . Это не единственный возможный метод позиционного кодирования. Однако это дает преимущество возможности масштабирования до невидимой длины последовательностей (например, если нашу обученную модель просят перевести предложение длиннее, чем любое из предложений в нашем обучающем наборе).

Июль 2020 Обновление: Позиционное кодирование, показанное выше, взято из реализации Transformer2Transformer. Метод, показанный в статье, немного отличается тем, что он не соединяет напрямую, а переплетает два сигнала. На следующем рисунке показано, как это выглядит. Вот код для его создания:

Остатки

Одна деталь в архитектуре кодера, которую мы должны упомянуть, прежде чем двигаться дальше, заключается в том, что каждый подуровень (самовнимание, ffnn) в каждом кодере имеет остаточное соединение вокруг себя, за которым следует этап нормализации уровня. .

Если мы визуализируем векторы и операцию уровня-нормы, связанную с самовниманием, это будет выглядеть так:

Это также относится к подуровням декодера. Если мы представим себе преобразователь из двух стековых кодировщиков и декодеров, он будет выглядеть примерно так:

Сторона декодера

Теперь, когда мы рассмотрели большинство концепций кодировщика, мы в основном знаем, как работают компоненты декодеров.Но давайте посмотрим, как они работают вместе.

Кодер запускает обработку входной последовательности. Затем выходной сигнал верхнего кодера преобразуется в набор векторов внимания K и V. Они должны использоваться каждым декодером на его уровне «внимание кодер-декодер», который помогает декодеру сосредоточиться на соответствующих местах во входной последовательности:

После завершения этапа кодирования мы начинаем этап декодирования. Каждый шаг в фазе декодирования выводит элемент из выходной последовательности (в данном случае предложение английского перевода).

Следующие шаги повторяют процесс до тех пор, пока не будет достигнут специальный символ, указывающий, что декодер трансформатора завершил свой вывод. Выходной сигнал каждого шага подается в нижний декодер на следующем временном шаге, и декодеры выводят свои результаты декодирования так же, как это сделали кодеры. И так же, как мы поступили с входами кодировщика, мы встраиваем и добавляем позиционное кодирование к этим входам декодера, чтобы указать положение каждого слова.

И так же, как мы поступили с входами кодировщика, мы встраиваем и добавляем позиционное кодирование к этим входам декодера, чтобы указать положение каждого слова.

Слои самовнимания в декодере работают немного иначе, чем в кодировщике:

В декодере слой самовнимания может обращать внимание только на более ранние позиции в выходной последовательности.Это делается путем маскирования будущих позиций (установка для них значений -inf ) перед шагом softmax в расчете самовнимания.

Слой «Внимание кодировщика-декодера» работает так же, как многоголовое самовнимание, за исключением того, что он создает свою матрицу запросов из нижележащего уровня и берет матрицу ключей и значений из выходных данных стека кодировщика.

Последний слой Linear и Softmax

Стек декодера выводит вектор чисел с плавающей запятой. Как превратить это в слово? Это работа последнего слоя Linear, за которым следует слой Softmax.

Линейный слой — это простая полносвязная нейронная сеть, которая проецирует вектор, созданный стеком декодеров, в гораздо более крупный вектор, называемый вектором логитов.

Предположим, что наша модель знает 10 000 уникальных английских слов («выходной словарь» нашей модели), которые она выучила из набора обучающих данных. Это сделало бы вектор логитов шириной 10 000 ячеек — каждая ячейка соответствует количеству уникального слова. Вот как мы интерпретируем вывод модели, за которой следует линейный слой.

Затем слой softmax превращает эти оценки в вероятности (все положительные, все в сумме дают 1,0). Выбирается ячейка с наибольшей вероятностью, и слово, связанное с ней, создается в качестве выходных данных для этого временного шага.

Этот рисунок начинается снизу с вектора, полученного на выходе стека декодера. Затем оно превращается в выходное слово.

Итоги обучения

Теперь, когда мы рассмотрели весь процесс прямого прохода через обученный преобразователь, было бы полезно взглянуть на интуицию обучения модели.

Во время обучения неподготовленная модель должна пройти точно такой же прямой проход. Но поскольку мы обучаем его на помеченном наборе обучающих данных, мы можем сравнить его выходные данные с фактическими правильными выходными данными.

Для наглядности предположим, что наш выходной словарь содержит только шесть слов («а», «я», «я», «спасибо», «ученик» и «

Выходной словарь нашей модели создается на этапе предварительной обработки еще до того, как мы начинаем обучение.

Как только мы определим наш выходной словарь, мы можем использовать вектор той же ширины для обозначения каждого слова в нашем словаре. Это также называется горячим кодированием. Так, например, мы можем обозначить слово «am» с помощью следующего вектора:

Пример: быстрое кодирование нашего выходного словаря

После этого резюме, давайте обсудим функцию потерь модели — метрику, которую мы оптимизируем на этапе обучения, чтобы привести к обученной и, надеюсь, удивительно точной модели.

Функция потерь

Допустим, мы обучаем нашу модель. Допустим, это наш первый шаг на этапе обучения, и мы обучаем его на простом примере — переводе слова «мерси» в «спасибо».

Это означает, что мы хотим, чтобы на выходе было распределение вероятностей с указанием слова «спасибо». Но поскольку эта модель еще не обучена, это вряд ли произойдет.

Поскольку все параметры модели (веса) инициализируются случайным образом, (необученная) модель создает распределение вероятностей с произвольными значениями для каждой ячейки / слова.Мы можем сравнить его с фактическим результатом, а затем настроить все веса модели с помощью обратного распространения ошибки, чтобы приблизить результат к желаемому результату.

Как сравнить два распределения вероятностей? Мы просто вычитаем одно из другого. Для получения дополнительных сведений см. Кросс-энтропию и расхождение Кульбака – Лейблера.

Но учтите, что это упрощенный пример. Более реалистично, мы будем использовать предложение длиннее одного слова. Например — ввод: «je suis étudiant» и ожидаемый результат: «я студент».На самом деле это означает, что мы хотим, чтобы наша модель последовательно выводила распределения вероятностей, где:

- Каждое распределение вероятностей представлено вектором ширины vocab_size (6 в нашем игрушечном примере, но более реалистично число вроде 30 000 или 50 000)

- Первое распределение вероятностей имеет наивысшую вероятность в ячейке, связанной со словом «i»

- Второе распределение вероятностей имеет самую высокую вероятность в ячейке, связанной со словом «am»

- И так далее, пока пятое выходное распределение не укажет символ «

<конец предложения>», с которым также связана ячейка из словаря из 10 000 элементов.

Целевые распределения вероятностей, с которыми мы будем обучать нашу модель в обучающем примере для одного предложения-образца.

После обучения модели в течение достаточного времени на достаточно большом наборе данных мы надеемся, что полученные распределения вероятностей будут выглядеть следующим образом:

Надеемся, что после обучения модель выдаст правильный перевод, который мы ожидаем. Конечно, это не настоящее указание на то, была ли эта фраза частью обучающего набора данных (см .: перекрестная проверка).Обратите внимание, что каждая позиция имеет небольшую вероятность, даже если она вряд ли будет результатом этого временного шага — это очень полезное свойство softmax, которое помогает процессу обучения.

Теперь, поскольку модель производит выходные данные по одному, мы можем предположить, что модель выбирает слово с наибольшей вероятностью из этого распределения вероятностей и отбрасывает остальные. Это один из способов (называемый жадным декодированием). Другой способ сделать это — удержаться, скажем, за два верхних слова (например, «I» и «a»), а затем на следующем шаге запустить модель дважды: однажды предполагая, что первая выходная позиция была слово «I», и в другой раз, предполагая, что первой выходной позицией было слово «a», и какая бы версия ни вызвала меньше ошибок, учитывая обе позиции №1 и №2, сохраняется. Мы повторяем это для позиций №2 и №3… и т. Д. Этот метод называется «поиск луча», где в нашем примере beam_size было два (это означает, что всегда две частичные гипотезы (незавершенные переводы) сохраняются в памяти), а top_beams также равно двум (что означает, что мы вернем два перевода. ). Это оба гиперпараметра, с которыми вы можете поэкспериментировать.

Мы повторяем это для позиций №2 и №3… и т. Д. Этот метод называется «поиск луча», где в нашем примере beam_size было два (это означает, что всегда две частичные гипотезы (незавершенные переводы) сохраняются в памяти), а top_beams также равно двум (что означает, что мы вернем два перевода. ). Это оба гиперпараметра, с которыми вы можете поэкспериментировать.

Двигайтесь вперед и трансформируйте

Надеюсь, вы нашли это полезным местом, чтобы начать ломать голову над основными концепциями Трансформера.Если вы хотите углубиться, я бы посоветовал следующие шаги:

Доработки:

Благодарности

Благодарим Илью Полосухина, Якоба Ушкорейта, Ллиона Джонса, Лукаша Кайзера, Ники Пармар и Ноама Шазира за отзывы о более ранних версиях этого поста.

Пожалуйста, напишите мне в Твиттер, чтобы я получил любые исправления или отзывы.

Что такое трансформатор ?. Введение в трансформаторы и… | Максим | Машинное обучение изнутри

Новые модели глубокого обучения внедряются все чаще, и иногда бывает сложно уследить за всеми новинками.Тем не менее, одна конкретная модель нейронной сети оказалась особенно эффективной для общих задач обработки естественного языка. Модель называется Transformer, и в ней используются несколько методов и механизмов, которые я здесь расскажу. Статьи, на которые я ссылаюсь в посте, предлагают более подробное и количественное описание.

В документе «Внимание — это все, что вам нужно» описываются трансформаторы и так называемая архитектура «последовательность-последовательность». Sequence-to-Sequence (или Seq2Seq) — это нейронная сеть, которая преобразует заданную последовательность элементов, например последовательность слов в предложении, в другую последовательность.(Что ж, это может не удивить вас, учитывая название.)

Модели Seq2Seq особенно хороши при переводе, когда последовательность слов одного языка преобразуется в последовательность разных слов другого языка. Популярным выбором для этого типа моделей являются модели на основе Long-Short-Term-Memory (LSTM). С данными, зависящими от последовательности, модули LSTM могут придавать значение последовательности, запоминая (или забывая) те части, которые он считает важными (или неважными). Например, предложения зависят от последовательности, поскольку порядок слов имеет решающее значение для понимания предложения.LSTM — естественный выбор для этого типа данных.

С данными, зависящими от последовательности, модули LSTM могут придавать значение последовательности, запоминая (или забывая) те части, которые он считает важными (или неважными). Например, предложения зависят от последовательности, поскольку порядок слов имеет решающее значение для понимания предложения.LSTM — естественный выбор для этого типа данных.

Модели Seq2Seq состоят из кодировщика и декодера. Кодировщик берет входную последовательность и отображает ее в пространство более высокой размерности (n-мерный вектор). Этот абстрактный вектор подается в декодер, который превращает его в выходную последовательность. Последовательность вывода может быть на другом языке, символах, копии ввода и т. Д.

Представьте себе кодировщик и декодер как переводчиков, говорящих только на двух языках. Их первый язык — их родной язык, который у них обоих разный (e.грамм. Немецкий и французский) и их второй общий язык — воображаемый. Для перевода немецкого на французский Encoder преобразует немецкое предложение на другой язык, который он знает, а именно на воображаемый язык. Поскольку декодер может читать этот воображаемый язык, теперь он может переводить с этого языка на французский. Вместе модель (состоящая из кодировщика и декодера) может переводить с немецкого на французский!

Предположим, что изначально ни кодировщик, ни декодер плохо владеют воображаемым языком.Чтобы научиться этому, мы обучаем их (модель) на множестве примеров.

Самый простой выбор для кодировщика и декодера модели Seq2Seq — это один LSTM для каждого из них.

Вам интересно, когда же Трансформер наконец войдет в игру, не так ли?

Нам нужна еще одна техническая деталь, чтобы сделать трансформаторы более понятными: Внимание . Механизм внимания смотрит на входную последовательность и на каждом этапе решает, какие другие части последовательности важны.Это звучит абстрактно, но позвольте мне пояснить простой пример: читая этот текст, вы всегда сосредотачиваетесь на прочитанном слове, но в то же время ваш разум по-прежнему удерживает в памяти важные ключевые слова текста, чтобы обеспечить контекст.

Механизм внимания работает аналогично для данной последовательности. Для нашего примера с человеческим кодировщиком и декодером представьте, что вместо того, чтобы записывать только перевод предложения на воображаемом языке, кодировщик также записывает ключевые слова, которые важны для семантики предложения, и передает их декодеру в дополнение к обычному переводу.Эти новые ключевые слова значительно упрощают перевод для декодера, поскольку он знает, какие части предложения важны и какие ключевые термины задают контекст предложения.

Другими словами, для каждого входа, который считывает LSTM (кодировщик), механизм внимания одновременно учитывает несколько других входов и решает, какие из них важны, присваивая этим входам разные веса. Затем декодер примет на вход закодированное предложение и веса, предоставленные механизмом внимания.Чтобы узнать больше о внимании, прочтите эту статью. А если вам нужен более научный подход, чем предложенный, прочтите о различных основанных на внимании подходах к моделям последовательность-последовательность в этой замечательной статье под названием «Эффективные подходы к нейронному машинному переводу на основе внимания».

В статье «Внимание — это все, что вам нужно» представлена новая архитектура под названием Transformer. Как видно из названия, он использует механизм внимания, который мы видели ранее. Как и LSTM, Transformer — это архитектура для преобразования одной последовательности в другую с помощью двух частей (кодировщика и декодера), но она отличается от ранее описанных / существующих моделей последовательности-в-последовательности, поскольку не подразумевает никаких рекуррентных сетей ( ГРУ, LSTM и др.).

Рекуррентные сети до сих пор были одним из лучших способов фиксировать своевременные зависимости в последовательностях. Однако команда, представившая документ, доказала, что архитектура только с механизмами внимания без каких-либо RNN (рекуррентных нейронных сетей) может улучшить результаты в задаче перевода и других задачах! Одно улучшение в задачах естественного языка представлено командой, представляющей BERT: BERT: предварительное обучение глубоких двунаправленных преобразователей для понимания языка.

Итак, что такое трансформатор?

Изображение стоит тысячи слов, поэтому начнем с него!

Рис. 1. Из статьи Vaswani et al.Кодировщик находится слева, а декодер — справа. И кодировщик, и декодер состоят из модулей, которые можно устанавливать друг на друга несколько раз, что на рисунке обозначено как Nx . Мы видим, что модули состоят в основном из слоев Multi-Head Attention и Feed Forward. Входы и выходы (целевые предложения) сначала встраиваются в n-мерное пространство, поскольку мы не можем использовать строки напрямую.

Одна небольшая, но важная часть модели — позиционное кодирование различных слов.Поскольку у нас нет повторяющихся сетей, которые могут запомнить, как последовательности вводятся в модель, нам нужно каким-то образом присвоить каждому слову / части в нашей последовательности относительное положение, поскольку последовательность зависит от порядка ее элементов. Эти позиции добавляются к встроенному представлению (n-мерному вектору) каждого слова.

Давайте внимательнее рассмотрим эти блоки Multi-Head Attention в модели:

Рисунок 2. Из «Attention Is All You Need» Vaswani et al.Начнем с описания механизма внимания слева.Это не очень сложно и может быть описано следующим уравнением:

Q — матрица, содержащая запрос (векторное представление одного слова в последовательности), K — все ключи (векторные представления всех слов в последовательности) и V — значения, которые снова являются векторными представлениями всех слов в последовательности. Для кодировщика и декодера, модулей внимания с несколькими головами, V состоит из той же последовательности слов, что и Q. Однако для модуля внимания, который принимает во внимание последовательности кодера и декодера, V отличается от последовательности, представленной Q.

Чтобы немного упростить это, мы могли бы сказать, что значения в V умножаются и суммируются с некоторыми весами внимания a, , где наши веса определяются как:

Это означает, что веса a определяются как как на каждое слово последовательности (представленной Q) влияют все другие слова в последовательности (представленные K). Кроме того, функция SoftMax применяется к весам и , чтобы иметь распределение между 0 и 1. Эти веса затем применяются ко всем словам в последовательности, которые вводятся в V (те же векторы, что и Q для кодера и декодера, но разные для модуля, имеющего входы кодировщика и декодера).

Кроме того, функция SoftMax применяется к весам и , чтобы иметь распределение между 0 и 1. Эти веса затем применяются ко всем словам в последовательности, которые вводятся в V (те же векторы, что и Q для кодера и декодера, но разные для модуля, имеющего входы кодировщика и декодера).

На рисунке справа показано, как этот механизм внимания можно распараллелить на несколько механизмов, которые можно использовать бок о бок. Механизм внимания повторяется несколько раз с линейными проекциями Q, K и V. Это позволяет системе учиться на различных представлениях Q, K и V, что полезно для модели. Эти линейные представления выполняются путем умножения Q, K и V на весовые матрицы W, которые изучаются во время обучения.

Эти матрицы Q, K и V различны для каждой позиции модулей внимания в структуре в зависимости от того, находятся ли они в кодере, декодере или промежуточном кодере и декодере.Причина в том, что мы хотим обработать либо всю входную последовательность кодера, либо часть входной последовательности декодера. Модуль внимания с несколькими головами, который соединяет кодер и декодер, будет следить за тем, чтобы входная последовательность кодера учитывалась вместе с входной последовательностью декодера до заданной позиции.

После головок с множественным вниманием и в кодере, и в декодере у нас есть точечный слой прямой связи. Эта небольшая сеть с прямой связью имеет идентичные параметры для каждой позиции, которые можно описать как отдельное идентичное линейное преобразование каждого элемента из данной последовательности.

ОбучениеКак дрессировать такого «зверя»? Обучение и вывод на основе моделей Seq2Seq немного отличается от обычной задачи классификации. То же верно и для Трансформеров.

Мы знаем, что для обучения модели задачам перевода нам нужны два предложения на разных языках, которые являются переводами друг друга. Когда у нас будет много пар предложений, мы можем приступить к обучению нашей модели. Допустим, мы хотим перевести с французского на немецкий. Наш закодированный ввод будет предложением на французском языке, а ввод для декодера будет предложением на немецком языке.Однако вход декодера будет смещен вправо на одну позицию. .. Подождите, а почему?

Допустим, мы хотим перевести с французского на немецкий. Наш закодированный ввод будет предложением на французском языке, а ввод для декодера будет предложением на немецком языке.Однако вход декодера будет смещен вправо на одну позицию. .. Подождите, а почему?

Одна из причин заключается в том, что мы не хотим, чтобы наша модель училась копировать входные данные декодера во время обучения, но мы хотим узнать, что с учетом последовательности кодера и конкретной последовательности декодера, которая уже была замечена моделью, мы прогнозируем следующее слово / символ.

Если мы не сдвинем последовательность декодера, модель научится просто «копировать» вход декодера, поскольку целевым словом / символом для позиции i будет слово / символ i на входе декодера.Таким образом, сдвигая ввод декодера на одну позицию, наша модель должна предсказать целевое слово / символ для позиции i , увидев только слово / символы 1,…, i-1 в последовательности декодера. Это мешает нашей модели изучить задачу копирования / вставки. Мы заполняем первую позицию ввода декодера токеном начала предложения, поскольку в противном случае это место было бы пустым из-за сдвига вправо. Точно так же мы добавляем маркер конца предложения во входную последовательность декодера, чтобы отметить конец этой последовательности, и он также добавляется к целевому выходному предложению.Через мгновение мы увидим, насколько это полезно для вывода результатов.

Это верно для моделей Seq2Seq и трансформатора. В дополнение к сдвигу вправо, Трансформатор применяет маску к входу в первом модуле внимания с несколькими головами, чтобы не видеть потенциальных «будущих» элементов последовательности. Это характерно для архитектуры Transformer, потому что у нас нет RNN, в которые мы можем вводить нашу последовательность последовательно. Здесь мы вводим все вместе, и если бы не было маски, внимание с несколькими головками рассматривало бы всю входную последовательность декодера в каждой позиции.

Процесс подачи правильного сдвинутого ввода в декодер также называется принудительной подачей учителя, как описано в этом блоге.

Целевая последовательность, которую мы хотим для наших расчетов потерь, — это просто вход декодера (немецкое предложение) без его сдвига и с маркером конца последовательности в конце.

ВыводВывод с использованием этих моделей отличается от обучения, что имеет смысл, потому что в конце концов мы хотим перевести французское предложение, не имея немецкого предложения.Уловка здесь заключается в том, чтобы повторно загружать нашу модель для каждой позиции выходной последовательности, пока мы не встретим токен конца предложения.

Еще один пошаговый метод:

- Введите полную последовательность кодировщика (французское предложение), и в качестве входных данных декодера мы берем пустую последовательность с токеном начала предложения на первой позиции. Это выведет последовательность, в которой мы возьмем только первый элемент.

- Этот элемент будет заполнен во второй позиции нашей входной последовательности декодера, которая теперь имеет маркер начала предложения и первое слово / символ в нем.

- Введите в модель как последовательность кодировщика, так и новую последовательность декодера. Возьмите второй элемент вывода и поместите его во входную последовательность декодера.

- Повторяйте это, пока не найдете маркер конца предложения, который отмечает конец перевода.

Мы видим, что нам нужно несколько прогонов нашей модели для перевода нашего предложения.

Я надеюсь, что эти описания сделали архитектуру Transformer немного понятнее для всех, кто начинает с Seq2Seq и структур кодировщика-декодера.

Мы видели архитектуру Transformer и знаем из литературы и авторов «Attention is All you Need», что модель очень хорошо справляется с языковыми задачами. Давайте теперь протестируем Transformer на примере использования.

Вместо задачи перевода давайте реализуем прогноз временных рядов для почасового потока электроэнергии в Техасе, предоставленный Советом по надежности электроснабжения Техаса (ERCOT). Здесь вы можете найти почасовые данные.

Здесь вы можете найти почасовые данные.

Прекрасное подробное объяснение трансформатора и его реализации предоставлено harvardnlp.Если вы хотите глубже изучить архитектуру, я рекомендую пройти через эту реализацию.

Поскольку мы можем использовать последовательные модели на основе LSTM для составления многошаговых прогнозов, давайте взглянем на Трансформатор и его возможности для таких прогнозов. Однако сначала нам нужно внести несколько изменений в архитектуру, поскольку мы работаем не с последовательностями слов, а со значениями. Кроме того, мы делаем авторегрессию, а не классификацию слов / символов.

ДанныеИмеющиеся данные дают нам почасовую нагрузку для всей области управления ERCOT. Я использовал данные с 2003 по 2015 год в качестве обучающей выборки и 2016 года в качестве тестовой. Имея только значение нагрузки и метку времени загрузки, я расширил метку времени на другие функции. Из метки времени я извлек день недели, которому он соответствует, и закодировал его в горячем режиме. Кроме того, я использовал год (2003, 2004,…, 2015) и соответствующий час (1, 2, 3,…, 24) как само значение.Это дает мне в общей сложности 11 функций на каждый час дня. В целях сходимости я также нормализовал нагрузку ERCOT, разделив ее на 1000.

Чтобы предсказать заданную последовательность, нам нужна последовательность из прошлого. Размер этих окон может варьироваться от варианта к варианту использования, но здесь, в нашем примере, я использовал почасовые данные за предыдущие 24 часа, чтобы спрогнозировать следующие 12 часов. Помогает то, что мы можем регулировать размер этих окон в зависимости от наших потребностей. Например, мы можем изменить это на ежедневные данные вместо почасовых данных.

Изменения в модели из бумаги В качестве первого шага нам нужно удалить вложения, так как у нас уже есть числовые значения во входных данных. Вложение обычно отображает данное целое число в n-мерное пространство. Здесь вместо использования встраивания я просто использовал линейное преобразование для преобразования 11-мерных данных в n-мерное пространство. Это похоже на вложение со словами.

Здесь вместо использования встраивания я просто использовал линейное преобразование для преобразования 11-мерных данных в n-мерное пространство. Это похоже на вложение со словами.

Нам также необходимо удалить слой SoftMax из выходных данных Transformer, потому что наши выходные узлы являются не вероятностями, а реальными значениями.

После этих незначительных изменений можно начинать обучение!

Как уже упоминалось, я использовал принуждение учителя для обучения. Это означает, что кодер получает окно из 24 точек данных в качестве входных данных, а вход декодера представляет собой окно из 12 точек данных, где первая представляет собой значение «начала последовательности», а следующие точки данных представляют собой просто целевую последовательность. Введя значение «начало последовательности» в начале, я сдвинул ввод декодера на одну позицию относительно целевой последовательности.

Я использовал 11-мерный вектор только с -1 в качестве значений «начала последовательности». Конечно, это можно изменить, и, возможно, было бы полезно использовать другие значения в зависимости от варианта использования, но для этого примера это работает, поскольку у нас никогда не бывает отрицательных значений ни в одном из измерений последовательностей ввода / вывода.

Функция потерь для этого примера — это просто среднеквадратичная ошибка.

Результаты Два графика ниже показывают результаты. Я взял среднее значение почасовых значений за день и сравнил его с правильными значениями.Первый график показывает 12-часовые прогнозы, сделанные за 24 предыдущих часа. Для второго графика мы предсказали один час с учетом предыдущих 24 часов. Мы видим, что модель очень хорошо улавливает некоторые колебания. Среднеквадратичная ошибка для обучающего набора составляет 859, а для набора проверки — 4 106 для 12-часовых прогнозов и 2583 для 1-часовых прогнозов. Это соответствует средней абсолютной процентной ошибке прогноза модели 8,4% для первого графика и 5,1% для второго.

Результаты показывают, что можно было бы использовать архитектуру Transformer для прогнозирования временных рядов. Однако во время оценки это показывает, что чем больше шагов мы хотим спрогнозировать, тем выше будет ошибка. Первый график (рис. 3) выше был получен с использованием 24 часов для прогнозирования следующих 12 часов. Если мы спрогнозируем только один час, результаты будут намного лучше, как мы видим на втором графике (рисунок 4).

Есть много места, где можно поиграть с параметрами преобразователя, такими как количество слоев декодера и кодировщика и т. Д. Это не было задумано как идеальная модель, и при лучшей настройке и обучении результаты, вероятно, улучшатся.

Это может быть большим подспорьем для ускорения обучения с использованием графических процессоров. Я использовал локальную платформу Watson Studio для обучения моей модели с помощью графических процессоров, и я позволил ей работать там, а не на моем локальном компьютере. Вы также можете ускорить обучение с помощью графических процессоров Watson Machine Learning, которые бесплатны до определенного времени! Прочтите мой предыдущий блог, чтобы узнать, как это можно легко интегрировать в ваш код.

Большое спасибо за то, что прочитали это, и я надеюсь, что смог прояснить несколько понятий людям, которые только начинают изучать глубокое обучение!

Определение трансформатора от Merriam-Webster

транс · форма · эр | \ tran (t) s-ˈfȯr-mər \ : преобразующий конкретно : устройство, использующее принцип взаимной индукции для преобразования изменений тока в первичной цепи в изменения напряжения и тока во вторичной цепи.

Молекулярные выражения: электричество и магнетизм

Трансформатор

Трансформаторы используются для увеличения или уменьшения напряжения и тока переменного тока в цепях.Работа трансформаторов основана на принципе взаимной индуктивности. Трансформатор обычно состоит из двух катушек с проволокой, намотанных на один сердечник. Первичная катушка — это входная катушка трансформатора, а вторичная катушка — это выходная катушка. Взаимная индукция вызывает индуцирование напряжения во вторичной катушке.

Первичная катушка — это входная катушка трансформатора, а вторичная катушка — это выходная катушка. Взаимная индукция вызывает индуцирование напряжения во вторичной катушке.

Нажмите на ползунки, чтобы отрегулировать входное напряжение и количество обмоток на первичной и вторичной катушках.

Когда вы регулируете количество обмоток катушек, обратите внимание, что входное и выходное напряжения прямо пропорциональны количеству обмоток катушек.

Напряжение определяется по формуле:

V O = (V I x N S ) / N P, где V I — входное напряжение первичной катушки, V O — выходное напряжение вторичной катушки, N P , это количество обмоток первичной катушки, и N S — количество витков вторичной обмотки.

Если выходное напряжение трансформатора больше входного, он называется повышающим трансформатором. Если выходное напряжение трансформатора меньше входного напряжения, он называется понижающим трансформатором.

НАЗАД К РУКОВОДСТВАМ ПО ЭЛЕКТРИЧЕСТВЕ И МАГНИТИЗМУ

Вопросы или комментарии? Отправить нам письмо.

© 1995-2021, автор — Майкл В. Дэвидсон и Государственный университет Флориды.Все права защищены. Никакие изображения, графика, программное обеспечение, сценарии или апплеты не могут быть воспроизведены или использованы каким-либо образом без разрешения правообладателей. Использование этого веб-сайта означает, что вы соглашаетесь со всеми юридическими положениями и условиями, изложенными владельцами.

Этот веб-сайт поддерживается нашим

Команда разработчиков графики и веб-программирования

в сотрудничестве с оптической микроскопией в Национальной лаборатории сильного магнитного поля

.

Последнее изменение: пятница, 31 марта 2017 г., 10:45

Счетчик доступа с 20 января 1999 г .

: 844306

: 844306Новая архитектура нейронной сети для понимания языков

Декодер работает аналогично, но генерирует по одному слову слева направо.Он касается не только других ранее сгенерированных слов, но и окончательных представлений, созданных кодировщиком. Поток информации

Помимо вычислительной производительности и более высокой точности, еще одним интригующим аспектом преобразователя является то, что мы можем визуализировать, на какие другие части предложения сеть обращает внимание при обработке или переводе данного слова, тем самым получая представление о том, как распространяется информация через сеть.

Чтобы проиллюстрировать это, мы выбрали пример, связанный с явлением, которое, как известно, является сложным для систем машинного перевода: разрешение кореферентности.Рассмотрим следующие предложения и их французский перевод:

| Распределение самовнимания кодировщика для слова «оно» с 5-го по 6-й уровень Трансформатора, обученного переводу с английского на французский (одна из восьми голов внимания). |

Фактически, с небольшой адаптацией, та же сеть, которую мы использовали для перевода с английского на немецкий, превзошла все ранее предложенные подходы к синтаксическому анализу, кроме одного.

Следующие шаги

Мы очень воодушевлены будущим потенциалом Transformer и уже начали применять его для решения других задач, связанных не только с естественным языком, но и с очень разными входами и выходами, такими как изображения и видео.Наши текущие эксперименты значительно ускоряются библиотекой Tensor2Tensor, исходный код которой мы недавно открыли. Фактически, после загрузки библиотеки вы можете обучить свои собственные сети Transformer для перевода и синтаксического анализа, вызвав всего несколько команд. Мы надеемся, что вы попробуете, и с нетерпением ждем возможности увидеть, что сообщество может сделать с Transformer.

Благодарности

Это исследование проводили Ашиш Васвани, Ноам Шазир, Ники Пармар, Якоб Ушкорейт, Ллион Джонс, Эйдан Н.Гомес, Лукаш Кайзер и Илья Полосухин. Дополнительная благодарность Дэвиду Ченеллу за создание приведенной выше анимации.

Нейронные сети, в частности рекуррентные нейронные сети (RNN), в настоящее время составляют основу ведущих подходов к задачам понимания языка, таким как языковое моделирование, машинный перевод и ответы на вопросы. В статье «Внимание — это все, что вам нужно» мы представляем Transformer, новую архитектуру нейронной сети, основанную на механизме самовнимания, который, по нашему мнению, особенно хорошо подходит для понимания языка.

В нашей статье мы показываем, что Transformer превосходит как рекуррентные, так и сверточные модели в тестах перевода с академического английского на немецкий и с английского на французский. Помимо более высокого качества перевода, Transformer требует меньше вычислений для обучения и намного лучше подходит для современного оборудования машинного обучения, ускоряя обучение на порядок.

| Показатели BLEU (чем выше, тем лучше) отдельных моделей в стандартном тесте перевода WMT newstest2014 с английского на немецкий. |

| Показатели BLEU (чем выше, тем лучше) отдельных моделей в стандартном тесте перевода WMT newstest2014 с английского на французский. |