Название профессии/специальности | Код специальности | Срок обучения | План | Количество поданных заявлений на 05 октября 2020 года |

Программы подготовки специалистов среднего звена | ||||

| Информационные системы и программирование | 09.02.07 | 3 года 10 месяцев | 25 | Группа набрана |

13.02.11 | 3 года 10 месяцев | 25 | Группа набрана | |

| Технология машиностроения | 15.02.08 | 3 года 10 месяцев | 25 | Группа набрана |

| Аддитивные технологии | 15.02.09 | 3 года 10 месяцев | 25 | Группа набрана |

| Технология продукции общественного питания | 19. | 3 года 10 месяцев | 25 | Группа набрана |

| Конструирование, моделирование и технология швейных изделий (модуль «Цифровой модельер») | 29.02.04 | 3 года 10 месяцев | 20 | Группа набрана |

| Операционная деятельность в логистике | 38.02.03 | 2 года 10 месяцев | 40 | Группа набрана |

| Поварское и кондитерское дело | 43.02.15 | 3 года 10 месяцев | 20 | Группа набрана |

Программы подготовки квалифицированных рабочих, служащих | ||||

| Наладчик аппаратного и программного обеспечения | 09.01.01 | 2 года 10 месяцев | 20 | Группа набрана |

Программы профессионального обучения | ||||

| Швея (адаптивная программа для лиц с ОВЗ) | 19601 | 10 месяцев | 5 | 4 |

| Пекарь (адаптивная программа для лиц с ОВЗ) | 16472 | 10 месяцев | 5 | Группа набрана |

Программы подготовки специалистов среднего звена | ||||

| Информационные системы и программирование | 09. 02.07 02.07 | 3 года 10 месяцев | 6 | Группа набрана |

13.02.11 | 3 года 10 месяцев | 5 | Группа набрана | |

Технология машиностроения | 15.02.08 | 3 года 4 месяца | 5 | Группа набрана |

| Аддитивные технологии | 15.02.09 | 3 года 10 месяцев | 5 | Группа набрана |

Технология продукции общественного питания | 19.02.10 | 3 года 4 месяца | 5 | Группа набрана |

| Конструирование, моделирование и технология швейных изделий (модуль «Цифровой модельер») | 29.02.04 | 3 года 10 месяцев | 10 | Группа набрана |

33.02.01 | 3 года 10 месяцев | 25 | Группа набрана | |

| Операционная деятельность в логистике | 38. | 2 года 10 месяцев | 20 | Группа набрана |

| Поварское и кондитерское дело | 43.02.15 | 3 года 10 месяцев | 10 | Группа набрана |

Программы подготовки квалифицированных рабочих, служащих | ||||

| Наладчик аппаратного и программного обеспечения | 09.01.01 | 2 года 10 месяцев | 5 | Группа набрана |

Программы подготовки специалистов среднего звена | ||||

| Технология машиностроения | 15.02.08 | 5 лет 4 месяца | 20 | Группа набрана |

Технология продукции общественного питания | 19. | 5 лет 4 месяца | 20 | 14 |

Программы подготовки специалистов среднего звена | ||||

| Технология машиностроения | 15.02.08 | 2 года 10 месяцев | 20 | 12 |

| Информационные системы и программирование | 09.02.07 | 2 года 10 месяцев | 20 | 17 |

Программы подготовки специалистов среднего звена | ||||

| Техническая эксплуатация и обслуживание электрического и электромеханического оборудования (по отраслям) | 13.02.11 | 3 года 4 месяца | 25 | 21 |

Техническое обслуживание и ремонт автомобильного транспорта | 23. | 3 года 4 месяца | 25 | 21 |

Монтаж, техническое обслуживание и ремонт промышленного оборудования (по отраслям) | 15.02.12 | 3 года 4 месяца | 25 | Группа набрана |

Программы подготовки специалистов среднего звена | ||||

Фармация | 33.02.01 | 3 года 4 месяца | 25 | 20 |

Программы подготовки специалистов среднего звена | ||||

Фармация | 33.02.01 | 2 года 4 месяца | 25 | 23 |

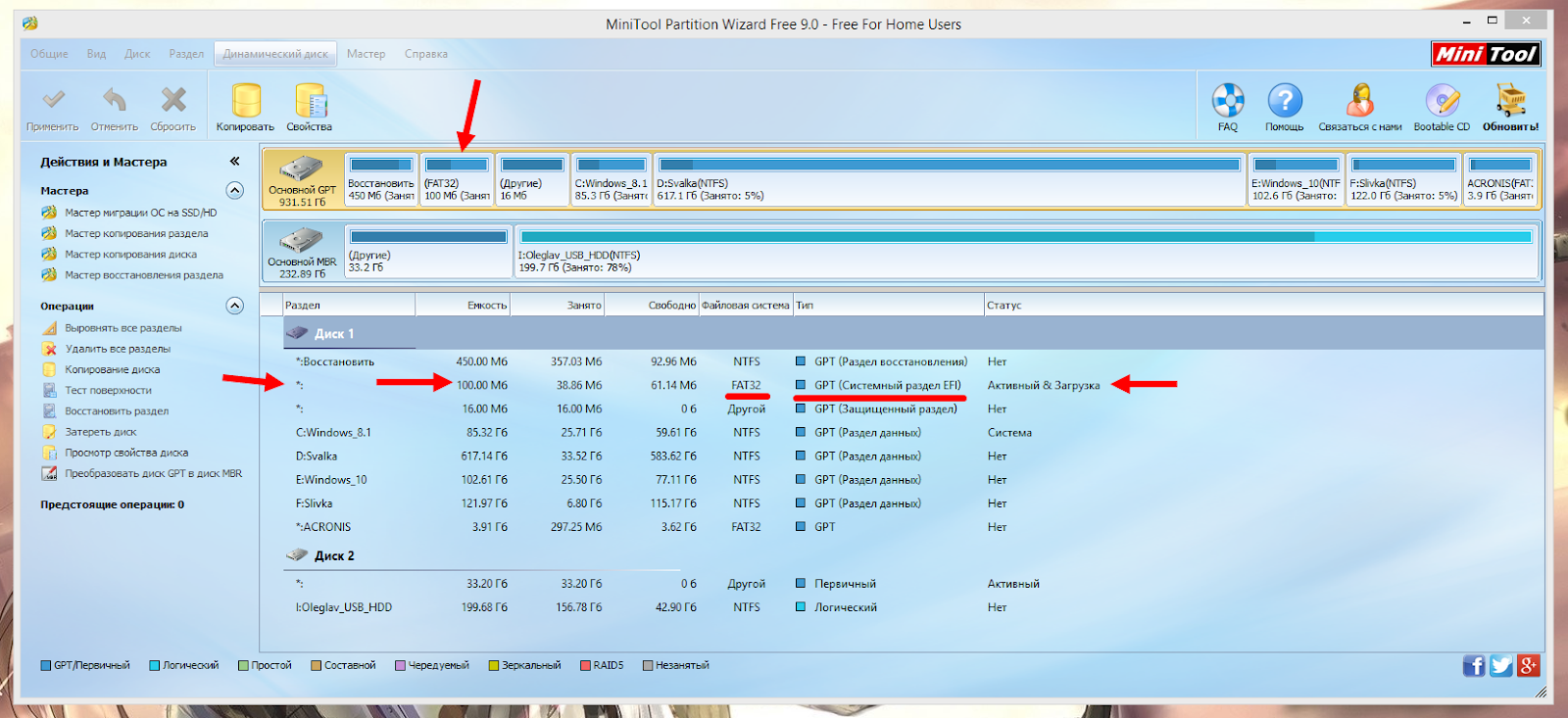

Поиск и устранение неисправностей, связанных с защищенным разделом GPT

Иногда после подключения внутреннего или внешнего диска служба управления дисками Windows сообщает, что на нём есть раздел, защищенный GPT (то есть накопитель нельзя ни отформатировать, ни заново разбить на разделы). В данной статье описано, как решить эту проблему.

В данной статье описано, как решить эту проблему.

Что такое GPT-накопитель?

Таблица разделов GUID Partition Table (GPT) — это стандарт формата размещения таблиц разделов на жестких дисках, который является частью расширяемого микропрограммного интерфейса (Extensible Firmware Interface, EFI), пришедшего на смену BIOS. GPT обеспечивает большую гибкость по сравнению с главной загрузочной записью (Master Boot Record, MBR), которая традиционно использовалась для разбиения дисков на разделы в ПК.

Раздел — это часть памяти физического или логического накопителя, состоящая из смежных блоков и функционирующая как отдельный диск. Микропрограммы и операционные системы (ОС) работают именно с разделами. На включенном компьютере доступом к разделу сначала управляет системная микропрограмма, а после загрузки ОС эта функция передается операционной системе.

Таблицу разделов GUID Partition Table (GPT) поддерживают Microsoft Windows XP x64 Edition, 64-разрядная версия Windows Server 2003, все версии Windows Server 2003 с пакетом обновления 1 (SP1), Windows Vista, Windows 7 и более поздние версии ОС Windows.

Стандарт GPT Partition был разработан, чтобы обойти проблему ограничения размера раздела в MBR, которое составляет 2 ТБ. При использовании GPT размер раздела может быть больше.

Примечание. Подробную информацию о разделах, защищенных GPT, читайте в справочном центре Microsoft на странице

https://docs.microsoft.com/en-us/windows-hardware/manufacture/desktop/windows-and-gpt-faq

Начиная с версии 10.4.6, операционная система macOS (прежнее название — Mac OS X) также поддерживает таблицу разделов GUID Partition Table (GPT). Все компьютеры Mac с процессорами Intel требуют наличия раздела GPT на загрузочном томе (независимо от того, какой используется диск — внешний или внутренний).

Иногда при подключении внутреннего или внешнего жесткого диска к компьютеру с 32-разрядной ОС Windows XP (или более поздней версией ОС Windows) оказывается, что накопитель недоступен, а служба управления дисками сообщает о наличии раздела, защищенного GPT. Такой накопитель нельзя отформатировать или заново разбить на разделы, поскольку он уже отформатирован на компьютере Windows или Macintosh с созданием раздела GPT.

Эту проблему нельзя решить обычными средствами службы управления дисками, поэтому в таких случаях следует использовать утилиту командной строки Windows

После выполнения инструкций с диска будут удалены все данные. При этом удаляется не только раздел, но и подпись диска. Перед выполнением этих действий настоятельно рекомендуется создать резервные копии всех важных данных.

Обязательно запустите службу управления дисками и запишите номер диска с разделом, защищенным GPT: эта информация вам понадобится позже.

- Определите номер диска с разделом, защищенным GPT.

- Щелкните правой кнопкой мыши по значку «(My) Computer» ((Мой) компьютер).

- Нажмите Manage (Управление).

- В разделе Storage (Запоминающие устройства) выберите Disk Management (Управление дисками).

- Найдите GPT-диск и запишите его номер (например, «Диск 1»).

- Откройте окно команд. В командной строке введите diskpart и нажмите клавишу Enter. Откроется окно служебной программы diskpart.

- В окне программы diskpart введите list disk и нажмите клавишу Enter. Появится текстовый перечень дисков, и вы вернетесь в командную строку diskpart.

- В командной строке diskpart введите select disk номер_диска (например, если защищенный GPT раздел находится на накопителе «Диск 2», введите select disk 2). Затем нажмите клавишу Enter. Появится сообщение о том, что диск выбран, и вы вернетесь в командную строку diskpart.

- В командной строке diskpart введите clean и нажмите клавишу Enter

- В командной строке diskpart введите exit и нажмите клавишу Enter.

Чтобы закрыть окно команд, введите exit еще раз. После этого внутренний или внешний накопитель можно будет заново инициализировать, разбить на разделы и отформатировать.

Чтобы закрыть окно команд, введите exit еще раз. После этого внутренний или внешний накопитель можно будет заново инициализировать, разбить на разделы и отформатировать. - Чтобы инициализировать накопитель, запустите службу управления дисками, после чего:

- воспользуйтесь мастером инициализации и преобразования дисков

-ИЛИ-

- закройте мастер, щелкните по нужному накопителю правой кнопкой мыши и выберите в меню пункт Инициализировать диск.

- воспользуйтесь мастером инициализации и преобразования дисков

- После инициализации разбейте накопитель на разделы и отформатируйте с помощью службы управления дисками.

ССЫЛКА НА СТОРОННИХ ПРОИЗВОДИТЕЛЕЙ И ВЕБ-САЙТЫ СТОРОННИХ ПРОИЗВОДИТЕЛЕЙ. Ссылки на сторонних производителей и продукты сторонних производителей приводятся исключительно в информационных целях и не подразумевают одобрение или явные/подразумеваемые рекомендации какой-либо из указанных компаний. Компания Seagate не предоставляет гарантий, явных или подразумеваемых, в отношении производительности или надежности этих компаний и продуктов. Все указанные компании являются независимыми и не находятся под управлением компании Seagate. Поэтому компания Seagate не несет никакой ответственности и не берет на себя какие-либо обязательства в отношении действий или продуктов указанных компаний. Решение о начале сотрудничества с любой из компаний должно приниматься на основании самостоятельно произведенной независимой оценки. Чтобы получить характеристики продуктов и сведения о гарантии, обращайтесь напрямую к соответствующему поставщику. В документах приведены ссылки на сайты сторонних производителей, которые не контролируются компанией Seagate. Такие ссылки размещены исключительно для удобства посетителей веб-сайта, которые могут воспользоваться ими на свой собственный риск. Компания Seagate не предоставляет никаких обязательств в отношении содержимого какого-либо из данных веб-сайтов. Компания Seagate не берет на себя никакой ответственности за содержимое этих веб-сайтов и деталей их использования.

Все указанные компании являются независимыми и не находятся под управлением компании Seagate. Поэтому компания Seagate не несет никакой ответственности и не берет на себя какие-либо обязательства в отношении действий или продуктов указанных компаний. Решение о начале сотрудничества с любой из компаний должно приниматься на основании самостоятельно произведенной независимой оценки. Чтобы получить характеристики продуктов и сведения о гарантии, обращайтесь напрямую к соответствующему поставщику. В документах приведены ссылки на сайты сторонних производителей, которые не контролируются компанией Seagate. Такие ссылки размещены исключительно для удобства посетителей веб-сайта, которые могут воспользоваться ими на свой собственный риск. Компания Seagate не предоставляет никаких обязательств в отношении содержимого какого-либо из данных веб-сайтов. Компания Seagate не берет на себя никакой ответственности за содержимое этих веб-сайтов и деталей их использования.

| Истпытание переменным током | |

|---|---|

| Испытательное напряжение | 0,05 кВ…5 кВ; частота 50/60 Гц (в зав. от сети питания) от сети питания) |

| Погрешность установки | ± (1 % + 5 ед. мл. разряда) |

| Разрешение | 2 В; 1 мкА |

| Диапазон установки тока | 0,001 мА…40 мА |

| Испытание постоянным током | |

| Испытательное напряжение | 0,05 кВ…6 кВ |

| Погрешность установки | ± (1 % + 5 ед. мл. разряда) |

| Диапазон установки тока | 0,001 мА…10 мА |

| Разрешение | 1 мкА |

| Измерение сопротивления изоляции | |

| Тестовое напряжение | 50 / 100 / 250 / 500 / 1000 В, постоянное |

| Диапазон измерений | 1 МОм…9999 МОм |

| Погрешность измерения | ± (1 % + 5 ед. мл. разряда) |

| Измерение сопротивления низкоомных цепей | |

| Тестовое напряжение | 6 Вмакс, частота 50/60 Гц |

| Тестовый ток | 3 А…30 А |

| Диапазон измерений | 0,1…650 мОм |

| Разрешение | 0,1 мОм |

| Погрешность измерений | ± (2 % + 2 ед. мл. разряда) мл. разряда) |

| Детектор токов утечки | |

| Диапазон установки | 0,3…100 мА |

| Общие данные | |

| Время испытания | 1…999 с (таймер) или непрерывно |

| Дисплей | ЖК-индикатор, графический (240х64) |

| Память | 100 ячеек (запись/ вызов профилей теста с букв-цифр. обозначением шагов) |

| Напряжение питания | 115 / 230 В, 50 / 60 Гц |

| Интерфейс | RS-232, USB |

| Габаритные размеры | 330 х 149 х 446 мм |

GPT — новые грани фантастики

История развития технологий обработки естественного языка, устройство революционного генератора текстов и разбор его возможностей на примере Dungeon AIGPT мне уже давно кажется очень интересной темой, потому что она реально взорвала интернет, все о ней говорят, но в то же время никто не понимает, как это работает. Но после этого поста Дениса о Dungeon AI я окончательно решился написать об этом пост, потому что сам тоже скачал себе эту штуку на телефон и залип в ней нанесколько часов, пробуя разные варианты геймплея. Игра хоть и обещает вам безграничные возможности геймплея, но на самом деле в процессе игры я столкнулся с немалым количеством достаточно необычных ограничений, которые заставляют в целом задуматься о природе ИИ и GPT в частности.

Но после этого поста Дениса о Dungeon AI я окончательно решился написать об этом пост, потому что сам тоже скачал себе эту штуку на телефон и залип в ней нанесколько часов, пробуя разные варианты геймплея. Игра хоть и обещает вам безграничные возможности геймплея, но на самом деле в процессе игры я столкнулся с немалым количеством достаточно необычных ограничений, которые заставляют в целом задуматься о природе ИИ и GPT в частности.

Введение

AI Dungeon — это генератор текстов, на который пытаются навесить дополнительные функции, тем самым превратив это в игру. Суть в том, что в её основе лежит GPT-3 — нейросетевая модель, разработанная OpenAI специально для целей генерации текста, неотличимого от естественной человеческой речи. OpenAI основана несколькими инвесторами (в том числе, Илоном Маском) всего лишь в 2015-ом году, но с тех пор ежегодно совершает в сфере искусственного интеллекта одну революцию за другой.

OpenAI основана несколькими инвесторами (в том числе, Илоном Маском) всего лишь в 2015-ом году, но с тех пор ежегодно совершает в сфере искусственного интеллекта одну революцию за другой.

Архитектура GPT (Generative Pre-trained Transformer — заранее обученный генераторный трансформер) без дополнительного дообучения способна генерировать любой текст, схожий с тем, на котором она натренирована. Натренируете её на прозе — она будет писать прозу. Натренируете на википедии — будет писать энциклопедические заметки. И музыку она может генерировать, и компьютерный код, короче говоря ей можно скормить всё что угодно, что является последовательностью сигналов.

Вот вам рикролл будущего

Некоторые умельцы решили этим воспользоваться — и накормили нейросеть кучей фантастических книг, чтобы затем выдать это за генератор игровых историй.

Функции у Dungeon AI простые: вы вписываете какой-либо текст, являющийся завязкой вашей личной истории — а программа продолжает её писать за вас, генерируя новые сюжетные повороты, персонажей и их реплики. Вы можете в том числе и менять историю по своему усмотрению через слова, действия или события. Вы ничем не ограничены, кроме правил английского языка (хотя и к ним можно относится весьма пренебрежительно, программа вас поймёт или хотя бы попытается). Опять же, у Дениса есть вполне себе неплохой коротенький обзор на неё, можете прочитать. Я же бы хотел взглянуть на технологию, лежащую в основе игры, и на примере этой же самой игры оценить её фактические возможности.

Технологии прошлого

Раньше я активно увлекался нейросетями и технологиями генерации естественной речи, поэтому немного в этом разбираюсь.

И могу сказать, что американцам в этом плане очень повезло, и то, что прорыв в технологиях произошёл именно у них, а не где-либо ещё — это вполне себе логичное и закономерное развитие событий.

Я не буду особо распространяться о том, что Америка — это огромный пылесос, который засасывает в себя всех умных людей на свете, это вы и так все знаете. Но помимо этого, американцы говорят на английском языке, который является международным стандартом для любых межнациональных коммуникаций. Если ты хочешь выйти на мировую аудиторию, ты обязан учить английский и все свои труды переводить прежде всего на него. Неудивительно, что мировое сообщество обладает наибольшей текстовой базой именно на английском языке, а не на любом другом. А текстовые данные для исследователей — это манна небесная, без них у вас не выйдет сделать никакого генератора текстов, потому что модель будет не на чем обучать. Когда я пытался этим заниматься, я в первую очередь встал перед этой проблемой — все распарсенные текстовые данные, которые можно было бы использовать для обучения без предварительной их обработки, есть только на английском языке.

Когда я пытался этим заниматься, я в первую очередь встал перед этой проблемой — все распарсенные текстовые данные, которые можно было бы использовать для обучения без предварительной их обработки, есть только на английском языке.

Ну и ещё одна причина — это различие российской и американской ментальности. Наши учёные предпочитают долго теоретизировать, прежде чем приступить к разработкам, и выбирают только надёжные инструменты. В свою же очередь, американцы сначала берут в руки молоток, долбят им по чему-нибудь, а потом смотрят на результат. GPT стал продуктом именно такого метода проб и ошибок, мало кто заранее мог предугадать, что именно такая методика генерации текста выдаст такие ошеломляющие результаты. Многие учёные не верили и до сих пор не верят в возможности нейросетей стать полноценным сильным ИИ. Конечно, я не собираюсь отрицать интеллектуальное превосходство членов OpenAI, но без таких безрассудных бюджетов, мощностей и полной свободы действий я не думаю, что они бы достигли таких успехов за такие короткие сроки.

Ну, а теперь о самой технологии GPT. Я пытался понять, что это и как оно работает, но я скорее теоретик и нейросетями почти не пользуюсь, поэтому в чём-то я могу ошибаться. Тем не менее, постараюсь рассказать, как всё было, буду в основном пересказывать английскую википедию.

Как это ни странно, но технологии автоматического анализа речи начали зарождаться ещё в далёких 50-х с разработки автоматчиеских переводчиков. Я думаю, вы и сами можете представить, какие в 50-ых были успехи — компьютер мог распознавать и переводить только вполне конкретный набор слов и фраз, а алгоритмы обработки были основаны на конечных автоматах (считайте, заданный вручую просто набор правил). Механизм не менялся ещё долго, менялись лишь степень вложенных в программу усилий: в некоторых программах могли содержаться сотни и тысячи записанных вручную правил.

В далёком 1966-ом году это симулятор психотерапевта, ELIZA, сильно удивила обывателей своим высоким уровнем поддержания диалога, хотя на самом деле просто триггерилась на определённые слова в предложении и повторяла их

Но как учёные не старались, человеческий язык — вещь очень большая, непостоянная, плохо поддающаяся правилам в виду кучи исключений и особенных традиций, так что прогресс в этих технологиях можно сказать остановился, а используют их только при необходимости. В 80-ых годах на смену конечным автоматам пришёл статистический анализ — это когда мы в автоматическом режиме изучаем язык на основе чужих текстов и статистики положения слов относительно друг друга. У него результаты тоже были не шибко лучше, но зато программа не зависела от выбранного языка, набора текстов и программистов её пишущих и могла обучаться самостоятельно, что уже было намного больше похоже на человеческую деятельность.

В середине 00-ых нейросети получили вторую жизнь. О том, чтобы попытаться реализовать структуру мозга в программе начали задумываться ещё в 40-ые года, и уже тогда за нейронными сетями видели большое будущее, но где-нибудь лет через 100, потому что мощностей на компьютерах того времени не хватало, чтобы обучить даже простейший перцептрон. Но всплеск мощностей снял эту проблему — и к ним вернулись снова.

Я надеюсь, вы знакомы с механизмом работы нейросетей: у нас есть куча нейронов, выполняющих простейшие математические операции, у них есть вход, на который нужно подавать данные, и выход, на котором будет результат обработки данных. В принципе, можете воспринимать это как некую формулу, как чёрный ящик, который преобразует одни цифры в другие. Сама нейросеть работает достаточно шустро, самой большой проблемой для программиста является её обучить, то есть найти такие параметры (а параметров уже тогда было сотни и тысячи, а теперь вообще миллиарды), при которых она выдаёт корректные результаты чаще всего. Никакого адекватного и точного алгоритма для этого не существует, обучение происходит через модифицированный перебор.

Сама нейросеть работает достаточно шустро, самой большой проблемой для программиста является её обучить, то есть найти такие параметры (а параметров уже тогда было сотни и тысячи, а теперь вообще миллиарды), при которых она выдаёт корректные результаты чаще всего. Никакого адекватного и точного алгоритма для этого не существует, обучение происходит через модифицированный перебор.

Простейшее описание нейросети

Проблема применения нейронных сетей для обработки естественного языка лежит в том, что для каждой задачи структуру нейросетей нужно выбирать заранее. Вы сами задаёте, сколько в ней будет слотов входа, сколько выхода, сколько слоёв. Поэтому, непонятно, как подавать на неё потоковые данные неопределённой длины, например аудиосигнал или текст. Ну правда, мы под Войну и Мир будем делать нейросеть с несколькими миллионами входов? Это невозможно. Поэтому мир озаботился задачей создания архитектуры нейросети, которая может принимать потоковые данные.

Ну правда, мы под Войну и Мир будем делать нейросеть с несколькими миллионами входов? Это невозможно. Поэтому мир озаботился задачей создания архитектуры нейросети, которая может принимать потоковые данные.

Такой архитектурой оказались RNN — рекуррентные нейронные сети. В них на вход подаётся не только сами входные данные, но ещё и данные, характеризующие предыдущий шаг вычислений (это могут быть как входящие данные с прошлого шага, так и преобразованные с выходного, так и само состояние каждого нейрона по отдельности) — поэтому и «реккурентные», то есть основанные на рекурсии. Созданную ещё в 1986-ом, на эту архитектуру долго возлагали надежды и иногда (впрочем, редко) она даже выдавала какие-то неплохие результаты. Особенно много надежд было на LSTM (изобретённую в 1997-ом), конкретную реализацию RNN, которая хранит свои предыдущие состояния (с некоторой поправкой: каждый прошлый шаг делится на некоторое число и складывается с последующим, таким образом прошлые шаги постепенно, но не сразу, забываются).

Как работают RNN: на этапе 0 на вход нейросети А мы подаём данные X0, получаем результат H0, затем на следующем этапе вычислений 1 мы подаём на вход нейросети А не только Х1, но и состояние A0

Но скоро до программистов дошло, что задачам, связанным с обработкой потоковой информации, не хватает какой-то косвенной информации, для максимально полного анализа нужно предоставлять нейросети все данные о контексте целиком. Желательно, в более широкой и структурированной форме, чем обычная передача состояния нейросети, которая справляется только с короткими последовательностями, но не с длинными в несколько десятков или сотен компонентов.

Решение было такое: а давайте попробуем объединить весь текст в какой-то цельный набор данных, который мы сможем засунуть в нейросеть сразу и без изменений. Так придумали векторное представление слов. Суть в чём: мы попробуем свести весь словарный запас людей к некоторому ограниченному набору характеристик (обычно это несколько сотен характеристик, обычно 300 или 400). Например названия цветов в одну категорию, термины из космологии в другую, кулинарию в третью. Первые наработки в этой теме существовали ещё в 60-ых, но только после 2010-го, с введением автоматической группировки, по принципу частоты встречаемости слов рядом друг с другом, технология вошла в массы. Каждое слово численно соотносилось с каждой из характеристик, таким образом мы могли получить численный вектор (то есть набор чисел) заранее заданной величины (чем больше отдельное число в векторе, тем больше слово относится к заданной характеристике).

Так придумали векторное представление слов. Суть в чём: мы попробуем свести весь словарный запас людей к некоторому ограниченному набору характеристик (обычно это несколько сотен характеристик, обычно 300 или 400). Например названия цветов в одну категорию, термины из космологии в другую, кулинарию в третью. Первые наработки в этой теме существовали ещё в 60-ых, но только после 2010-го, с введением автоматической группировки, по принципу частоты встречаемости слов рядом друг с другом, технология вошла в массы. Каждое слово численно соотносилось с каждой из характеристик, таким образом мы могли получить численный вектор (то есть набор чисел) заранее заданной величины (чем больше отдельное число в векторе, тем больше слово относится к заданной характеристике).

Тут у нас три характеристики, и каждое слово относится к одной из двух: небесные тела, имеющие крылья и имеющие двигатель. А вот самолёт относится сразу ко всем характеристикам

А вот самолёт относится сразу ко всем характеристикам

Уже тогда нейросети начали примерно понимать устройство языка, так очень широко разошлось открытие учёных по поводу ассоциативности подобных связей: если мы представим слова «король», «мужчина» и «женщина» как векторы, то мы могли получить занятное уравнение: «король» — «мужчина» + «женщина» = «королева». То есть, нейросеть смогла корректно отделить концепт «мужчины» от должности, а потом к этой же должности добавить «женщину» — и получить название этой же должности в женском роде. Не знаю, впечатляет ли это вас, но для научного сообщества это было приятным шоком.

Другим изобретением, уже сравнительно недавним (2014-ый год, за авторством Google), является генерирование последовательностей. Идея в том, что вместо того, чтобы скармливать нейросети слова по отдельности, мы можем объединить их в общий численный вектор, который уже будет обработан нейросетью целиком. Возможно и обратное: научить нейросеть генерировать последовательности слов на основе заданного вектора (это опять же делается через рекуррентные нейросети). Были созданы и специальные нейросетевые модули, осуществляющие эти операции: кодер шифрует последовательность сигналов в вектор, декодер расшифровывает вектор в последовательность сигналов. За счёт этого нейросеть наконец-то научилась обрабатывать не слово за словом, а предложения целиком, и похожую архитектуру используют во многих задачах, например оценка семантики текста, поиск сущностей на изображениях или же перевод текста на другой язык с учётом правил языка.

Возможно и обратное: научить нейросеть генерировать последовательности слов на основе заданного вектора (это опять же делается через рекуррентные нейросети). Были созданы и специальные нейросетевые модули, осуществляющие эти операции: кодер шифрует последовательность сигналов в вектор, декодер расшифровывает вектор в последовательность сигналов. За счёт этого нейросеть наконец-то научилась обрабатывать не слово за словом, а предложения целиком, и похожую архитектуру используют во многих задачах, например оценка семантики текста, поиск сущностей на изображениях или же перевод текста на другой язык с учётом правил языка.

Слова из предложения по порядку подаются в кодер, на их основе составляется вектор, декодер получает вектор и расшифровывает его в последовательность слов, которые сортируются по факту некоторой значимости

Революция

Всё вышеперечисленное хоть и давало некоторый прирост естественности генерируемым текстам, однако прогресс всё равно двигался медленно, нейросети не могли генерировать осмысленный связный текст дальше одного предложения. Что-то было не так в их подходе. Решение витало в воздухе: исследователи понимали, что не любая информация в тексте одинаково важна, между словами нужно ставить приоритеты, связывать их между собой и учитывать их порядок в тексте, как это делают обычные люди при прочтении текстов. Но как конкретно это перенести в математичекую плоскость, ясно не было.

Что-то было не так в их подходе. Решение витало в воздухе: исследователи понимали, что не любая информация в тексте одинаково важна, между словами нужно ставить приоритеты, связывать их между собой и учитывать их порядок в тексте, как это делают обычные люди при прочтении текстов. Но как конкретно это перенести в математичекую плоскость, ясно не было.

В 2017-ом году снова учёные из Google предложили механизм Внимания. Вместо того, чтобы объединять все слова в один большой вектор, в котором полностью стёрта вся информация о структуре предложения, они сделали ещё один нейросетевой модуль, который для каждого слова из текста генерирует свой отдельный вектор, который хранит положение слова в тексте, его относительную значимость и связь с другими словами в предложении. Тут и далее я уже понятия не имею, что происходит, поэтому буду описывать в общих терминах.

Теперь, в нейросеть предлагали подавать на вход декодера не только сами слова, но и векторы их значимости, в зависимости от приоритета, а уже декодер слово за словом генерирует на их основе новый текст. Механизм внимания очень понравился учёным и его решили развивать в дальнейших разработках, а прогресс в плане обработки искусственной речи полетел вверх с неожиданной для всех скоростью.

Механизм внимания очень понравился учёным и его решили развивать в дальнейших разработках, а прогресс в плане обработки искусственной речи полетел вверх с неожиданной для всех скоростью.

Продолжая свои наработки, Google представили новую модель нейросети Transformer. Информация о прошлых состояниях нейросети теперь не подавалась на вход нейросети в оригинальном виде, как это было в случае рекуррентных нейросетей, но зашифровывалась в сами данные: каждое отдельное слово теперь шифровалось в особенную структуру, которая содержала всю информацию о контексте: и положение слова в предложении, и его тематика, и ссылки на другие слова. Нейросети больше не требовалось вычислять последовательности по порядку, шаг за шагом, вместо этого вычисления и обучение можно было распараллелить. Настоящая революция.

Теперь я окончательно перестал понимать, что происходит. Зато посмотрите, сколько здесь модулей! Нейросети уже очень давно перестали быть непосредственно сетью, теперь это совокупности модулей

Зато посмотрите, сколько здесь модулей! Нейросети уже очень давно перестали быть непосредственно сетью, теперь это совокупности модулей

Но и это ещё не всё. Разработчики из OpenAI подхватили инициативу, попытавшись построить из Transformer полноценный генератор текста. Для этого использовали метод обучения без учителя: ей без какой-либо дополнительныой обработки скармливали слова и предложения, а на них нейросеть пыталась предсказать следующий текст. И это неожиданно сработало, да так, что теперь нам придётся разгребать последствия.

Проблема перехода на обучение без учителя вообще стояла очень давно: архитектура нейросетей слабо учитывала контекст и не могла отличить мусор от действительно важного текста. Поэтому крупным корпорациям приходилось нанимать кучу людей, которые размечали текст и сверяли его с определёнными стандартами, чтобы уже потом специальные программисты-обучаторы подавали эти данные ей на вход, строго под контролем. С введением концепта внимания данная проблема исчезла и исследователи открыли для себя новый мир обучения без учителя, когда можно не бояться просто так взять и скормить нейросети огромное количество текстов любых жанров и форматов.

С введением концепта внимания данная проблема исчезла и исследователи открыли для себя новый мир обучения без учителя, когда можно не бояться просто так взять и скормить нейросети огромное количество текстов любых жанров и форматов.

Проблема была ещё не только в том, что нейросеть не могла отличить друг от друга корректно написанный текст и текст с кучей ошибок, и училась у них плохому. Как это было с чат-ботом от Microsoft, нейросеть без какого-либо контроля могла научиться грязной похабной речи и оскорблениям. Transformer лишена этих недостатков: мы можем заранее внести в исходный текст некоторый другой текст, дополняющий и корректирующий контекст (например, добавить фразу «буду вежливым», после чего нейросеть вспомнит все тексты, которые она читала ранее и в которых какие-либо люди называли себя «вежливыми», и начнёт копировать их речь).

GPT-1 вышла в 2018-ом году, вызвав у исследователей осторожный интерес: это было явно что-то новое и интересное, и оно хорошо работало на тестах, но её настоящие возможности были ещё не понятны. GPT-2 вышла в 2019-ом — и уже начала серьёзно пугать разработчиков своими неожиданно хорошими результатами. Рядовые экспериментаторы только начали получать доступ к технологии и осваивать её, даже не успев хорошо разойтись.

GPT-2 вышла в 2019-ом — и уже начала серьёзно пугать разработчиков своими неожиданно хорошими результатами. Рядовые экспериментаторы только начали получать доступ к технологии и осваивать её, даже не успев хорошо разойтись.

А ещё они научились генерировать продолжение картинок — и это тоже весело. Технология вообще не ограничена форматом подаваемых данных

А в 2020-ом выходит GPT-3. Мир уже потихоньку начинает осознавать последствия: люди действительно пугаются, когда читают результаты работы GPT-3 — слишком реалистично они написаны. Нейросеть не только изъясняется корректным английским языком без каких-либо ошибок, но и способна писать тексты любого формата и любой тематики, где в один контекст связаны не только отдельные слова или предложения, но даже абзацы и параграфы. Она может сохранять свою мысль на очень длинной дистанции. И она много знает о нашем мире, просто потому что она это уже прочитала. И она без проблем сможет достать из памяти ответ на любой вопрос, стоит лишь правильно его сформулировать. Модель не нужно глобально переобучать или приспосабливать, достаточно лишь относительно мелкой настройки.

Она может сохранять свою мысль на очень длинной дистанции. И она много знает о нашем мире, просто потому что она это уже прочитала. И она без проблем сможет достать из памяти ответ на любой вопрос, стоит лишь правильно его сформулировать. Модель не нужно глобально переобучать или приспосабливать, достаточно лишь относительно мелкой настройки.

Исследователи из OpenAI настолько испугались своей разработки, что теперь с полной серьёзностью изучают вопрос, публиковать ли их наработки в открытый доступ или нет. А к новой модели доступ открывают только по предварительной записи.

А теперь взглянем на Dungeon AI

Насколько я понимаю, Dungeon AI — некоторая обёртка над API доступа к GPT-3, которая добавляет определённые функции сверху: можно попросить программу сгенерировать текст заново, отмотать генератор вперёд и назад, добавить какую-нибудь информацию в качестве контекста, чтобы она постоянно висела в памяти программы. Больше ничего лишнего — а зачем? Нейросеть сама справляется со всем.

Больше ничего лишнего — а зачем? Нейросеть сама справляется со всем.

Некоторое время я и правда был в восторге от программы. Её возможности казались мне безграничными, потому что на любую мою реплику она давала более-менее корректный ответ. Авторы буквально обещают, что вам можно делать всё что угодно, буквально повернуть историю в любом направлении — и нейросеть вас поддержит.

Но это только на первый взгляд. По факту же это работает в обе стороны: вы никак не ограничены в своих возможностях, но и автор истории, нейросеть, в этих возможностях так же не ограничена. И если вы думаете, что она будет вас развлекать — то вы ошибаетесь, у неё такой цели не стоит. Впрочем, всё по порядку.

Вот, например, одна из историй, которые я сгенерировал вместе с GPT. Я выбрал обычную фентезийную историю и начал играть за волшебника. Моим главным квестом было найти Книгу Сущностей и прочитать её. Вот только когда я пришёл за ней в библиотеку, её прямо перед моим приходом кто-то украл, о чём мне и сообщает девушка-библиотекарша.

Я выбрал обычную фентезийную историю и начал играть за волшебника. Моим главным квестом было найти Книгу Сущностей и прочитать её. Вот только когда я пришёл за ней в библиотеку, её прямо перед моим приходом кто-то украл, о чём мне и сообщает девушка-библиотекарша.

Кто украл книгу — она не знает. Кроме текста, никаких указателей и подсказок нет. Персонажи вокруг вас обладают только мелкими уликами, а делиться ими начинают только после долгих, упорных и правильно сформулированных вопросов.

Что делать дальше? Никто не знает. Я просто вышел на улицу и начал расспрашивать прохожих, видели ли они что-то подозрительное. Один из них действительно видел этого мага, он же и смог мне описать его внешность подробнее, а ещё сообщить, где я могу узнать о нём больше информации — мне нужно было найти работника аптеки в городе рядом. Он же меня туда и проводил пешком, он же и подарил мне книгу о королевестве. Наверное, это был первый и последний хороший человек в моём путешествии.

Он же меня туда и проводил пешком, он же и подарил мне книгу о королевестве. Наверное, это был первый и последний хороший человек в моём путешествии.

Мы добрались до города и я нашёл ту аптеку, но искомого человека там никто не знает и не знал. То есть, моя единственная улика буквально оборвалась в начале истории. Я начал бродить по городу в поисках хоть какой-либо информации, но персонажи оказались малодружелюбными: один затворник послал меня спросить совета у богов (не уточнял, каких), другой священник активно пытался меня завербовать в священники прежде чем я смогу что-то узнать.

На улице меня нашёл какой-то мужчина в фиолетовых одеждах и сказал, что ему нужна помощь: каких-то его соплеменников похитили бандиты. У меня заканчивались деньги — и я решил ему помочь в надежде, что потом он мне заплатит — всё таки человек выглядел солидно. Он вывел меня из города и повёл по каким-то камням в каньоне, пришлось реально полазить, но своей цели мы достигли.

У меня заканчивались деньги — и я решил ему помочь в надежде, что потом он мне заплатит — всё таки человек выглядел солидно. Он вывел меня из города и повёл по каким-то камням в каньоне, пришлось реально полазить, но своей цели мы достигли.

Зато на обратном пути мы встретили огра. Огр в этой вселенный очень большой, сильный и быстро регенерирущий, а потому бой с ним растянулся где-то на пол часа реального времени: заклинания на него срабатывали и ему было больно, но дальше этого ничего не происходило. Зато огр успел дважды беспощадно убить меня, будто я залез со своим мелким левелом не в ту локацию. Приходилось отматывать игру назад и действовать по другому.

После нескольких попыток я всё же убил огра. Мужик в фиолетовых одеждах шустро слинял и я остался вообще без награды. Пришлось отправиться в отель, где я долго торговался за комнату (пришлось делить её с кем-то, на полноценную денег не было).

Пришлось отправиться в отель, где я долго торговался за комнату (пришлось делить её с кем-то, на полноценную денег не было).

На утро меня снова ждал какой-то странный человек — он сказал, что со мной хочет встретиться сам король и оплатить мне за мою победу над огром. Деньги мне были очень нужны, а потому я без раздумий пошёл за ним. Он повёл меня куда-то вон из города в лес, где меня встретили какие-то разодетые в доспехи братки явно с недобрыми намерениями. Они открыли портал, который якобы вёл к замок короля. Я повёлся и попал в какое-то измерение без входа и выхода, где несколько часов бродил, а потом был поглощён зыбучими песками.

Откат назад — и я решил не церемониться с ними и без особых проблем всех их сжёг, собрал с них монеты и поломанные мечи, которые продал за приличные деньги. Предварительно узнав, что их всё же послал король и именно король приказал меня убить (блин, за что?).

Предварительно узнав, что их всё же послал король и именно король приказал меня убить (блин, за что?).

Надо найти гильдию магов, подумал я. И действительно её нашёл. Более того, оказывается, несколько копий Книги Сущностей лежат у них в библиотеке и никого мне искать на самом деле не надо было! Но всё не так просто — сначала надо выучить нужный язык, в чём мне мог помочь глава гильдии. Он казался хорошим старичком: усадил меня на стул, вежливо поинтересовался мной, предложил научить языку. Я согласился — и он начал колдовать неизвестное заклинание «для моего же блага», попутно никак не рассказывая, что конкретно это за заклинание.

Раньше меня уже пытались убить — и я напал на старика, заморозив и разбив ему руку. Брал его за шкирку и угрожал принести мне книгу и прочитать её мне. Он сказал, что книга в музее — и мне нужно туда сходить. Ага, подумал я, засада! Пусть идёт сам, а я подожду здесь. Но вместо него пришла стража и я снова пустился в бой и бега в поисках выхода из гильдии магов.

Брал его за шкирку и угрожал принести мне книгу и прочитать её мне. Он сказал, что книга в музее — и мне нужно туда сходить. Ага, подумал я, засада! Пусть идёт сам, а я подожду здесь. Но вместо него пришла стража и я снова пустился в бой и бега в поисках выхода из гильдии магов.

Честно, хотелось бы закончить и так интересную историю на этом, потому что дальше начинается какая-то полная чушь в стиле логики сна. Сгенерированная история, честно, мне очень понравилась — никогда со мной не происходило таких нетривиальных перепетий и такой наглости, я наглядно чувствовал, что здесь я кто угодно, но точно не протагонист, которому достанутся все женщины и все сокровища.

Но всё это сопровождалось тонной недостатков. И эти недостатки касаются не столько сюжета, сколько самого игрового концепта:

- Иногда нейросеть просто не находит что сказать.

Понятия не имею, как это определяется на самом деле, но такое было частенько например в ответ на мои в принципе безобидные реплики

Понятия не имею, как это определяется на самом деле, но такое было частенько например в ответ на мои в принципе безобидные реплики - Когда же она находит что сказать, боже, лучше бы она этого не говорила. Нейросеть обучали на предсказаниях — и она усиленно пытается предсказать, что ты хочешь сделать следующим шагом. Например, когда я хотел схватить за рубашку старца из гильдии магов, мой персонаж сразу бросался жестоко убивать этого самого старца в попытках предугадать мои намерения.

- У нейросети есть определённый сценарий в голове, который она выучила из книг и которым она хочет с тобой поделиться. Ты как игрок можешь отказаться, но тогда нейросеть просто не будет знать, что тебе предложить взамен, и на твои действия будет реагировать так, будто совсем тебя не понимает, и пытаться вывести обратно на основной рут

- Из прошлого пункта так же следует, что и никаких безграничных возможностей у вас тоже не будет, нейросеть будет ожидать от вас строго определённого поведения.

Например, я потратил на схватку с огром пол часа потому, что постоянно пытался убить его ледяными шипами в голову, после которых огру было больно, но в целом больше ничего не происходило. Однако на самом деле мне нужно было просто передать управление нейросети, которая дала мне в руки меч и уже дальше от моего имени ловким движением меча убила огра.

Например, я потратил на схватку с огром пол часа потому, что постоянно пытался убить его ледяными шипами в голову, после которых огру было больно, но в целом больше ничего не происходило. Однако на самом деле мне нужно было просто передать управление нейросети, которая дала мне в руки меч и уже дальше от моего имени ловким движением меча убила огра. - Судя по истории в гильдии магов, я прям чувствовал, что нахожусь в какой-то конкретной истории, которую написал человек, а нейросеть повторяет её слово в слово и всё, настолько результаты не соотносились с моими указаниями.

- Чем дальше продвигалась история — тем меньше в ней было смысла. Я не исключаю, что это может быть моим личным субъективным впечатлением, но возможно это не так. У меня есть теория по этому поводу: переполнение контекста, когда нейросети подаётся слишком много текста для учёта контекста, за счёт чего каждое конкретное слово, подающееся на её вход, теряет абсолютный вес (но сохраняя относительный) и нейросеть начинает хуже на них реагировать в целом.

- Иногда нейросеть тебя тупо не в состоянии понять. Мне пришлось обойти 10 магазинов, чтобы продать мечи, поднятые мной с убитых бандитов, потому что нейросеть не могла взять в голову, что кто-то хочет не купить меч, а продать, она никогда до этого не видела такой механики в текстах. В конце я сдался и форсировал продажу отдельным сообщением.

- В целом конечно для нормального поведения в истории лучше заранее спросить у игры своё состояние как игрока: какое у тебя имя, какой класс, какие навыки, сколько денег, какой шмот, и держать эту инфу при себе. Игра об этом помнить не будет, если ей это отдельно не прописать. Да даже если и прописать, всё равно будет забывать постоянно. Всё таки, это просто генератор текста.

- Ну и, ещё одна условность: всегда нужно говорить от второго лица, то есть обращаться от своего имени через you, а не через I.

В целом, все вышеприведённые пункты можно сгруппировать и сформулировать применительно вообще ко всем нейросетевым технологиям обработки естественной речи. Ну а вывод по игре — играть в это интересно, но будьте готовы к тому, что никакого обещанного безграничного мира возможностей вам не дадут, и играть нужно правильно.

Ну а вывод по игре — играть в это интересно, но будьте готовы к тому, что никакого обещанного безграничного мира возможностей вам не дадут, и играть нужно правильно.

Что не так с нейросетями

Как этого не жаль, но, несмотря на огромный семимильный прогресс, нейросети всё ещё не претендуют на звание кандидата Сильного ИИ. Пусть даже с такими нечеловеческими возможностями (а GPT-3 реально превосходит большинство людей в плане знаний грамматики языка, фактов из реальной жизни и правил построения интересных историй), но нейросети всё ещё занимаются только одной вещью — повторением. Они просто повторяют за нами и ничего больше, они не способны на высшую интеллектуальную деятельность. По-крайней мере на ту, что мы от них ожидаем.

Нет, на самом деле нейросети вполне способны на творческую и оригинальную деятельность, как они способны общаться друг с другом и создавать эти самые языки общения. Но вся их творческая деятельность настолько чужеродна нашему пониманию, настолько неестественна, что мы просто не можем её принять, вместо этого пытаясь загнать её в рамки того, что лично мы считаем хорошим и правильным искусством. И вот она загнанная, сидит в тёмной комнате наперевес с китайским словарём в руках — и не знает, что делать. Не знает, как одновременно сделать оригинальный и творческий продукт и одновременно угодить нам как зрителям, сделать продукт своего труда дружелюбным.

И поэтому просто имитирует то, что мы от неё возможно хотим услышать. Представьте себе кинокритика, который посмотрел кучу фильмов, а сейчас ему принесли на оценку ещё один, который смотреть ему совершенно не хочется, а потому он пишет новую рецензию совершенно беззубую и не вдаваясь в детали, повторяя свои же и чужие слова.

И я очень сомневаюсь, что в ближайшее время ситуация изменится. Мы так и не придумали, как добавить компьютеру волю и побуждение к своим собственным действиям, он может лишь выполнять команды, а без этого полноценной интересной творческой личностью ему не стать, хоть он перечитает всю литературу мира. Компьютеры всё ещё не имеют прямого доступа к реальности, а потому все наши слова для него являются пустым звуком, ему не с чем это ассоциировать. Он не может постигать новую информацию, не может делать выводы на основе старой, только лишь повторять чужие мысли, пусть и очень искуссно

Впрочем, рядовые граждане в этом плане ничем не лучше. GPT-3 явно превзошла в своих возможностях обычного обывателя, никак не связанного с деятельностью постоянно написания текстов. Но нам и этого мало, мы же хотим сверхразум.

Аксессуар FIMO GPT 10

Мнемоника: GPT 10

Артикул: 6101200010

Производитель: FIMO

Мнемоника: GPT 10

Артикул: 6101200010

Производитель: FIMO

Подгруппа: заглушки

Серия FIMO: GPT

Форма: прямоугольная

Для отверстия: 10 х 120 мм

GATOR GPT-PRO — invask.ru

Детальная информация о товаре

Артикул:

445824

Краткое описание:

GATOR GPT-PRO — нейлоновая сумка для гитарных педалей, с доской-поставкой

Аналогичные товары Кейсы, сумки для педалей эффектовцена: 10 492 р / шт.

Аналогичные товары:

Обращаем ваше внимание на то, что вся представленная на сайте информация, касающаяся комплектаций, технических характеристик, цветовых сочетаний, а также стоимости представленного оборудования носит информационный характер и ни при каких условиях не является публичной офертой, определяемой положениями Статьи 437 (2) Гражданского кодекса Российской Федерации. Производитель оставляет за собой право вносить изменения в габариты, конструкцию и комплектацию без предварительного уведомления. Для получения подробной информации о товаре, пожалуйста, обращайтесь к производителю оборудования или к нашим менеджерам.

RUS: Этот сайт использует файлы cookie для хранения информации на вашем компьютере.

Некоторые из этих файлов cookie необходимы для работы нашего сайта, а другие помогают нам совершенствоваться, давая нам некоторое представление о том, как сайт используется.

ENG: This site uses cookies to store information on your computer.

Some of these cookies are essential to make our site work and others help us to improve by giving us some insight into how the site is being used.

Подробнее(Read more)…

Принимаю(Agree)Стрела алюминиевая сечением 90х35 и длиной 3050 мм для шлагбаумов GPT и GPX (803XA-0051)

Код товара 3638164

Артикул 803XA-0051

Производитель CameСтрана Италия

Наименование

Упаковки

Сертификат

Тип изделия Стрела шлагбаума

Ширина проезда 5.5-6.5

Длина стрелы, м 6.85

Тип стрелы Круглая

Все характеристики

Характеристики

Код товара 3638164

Артикул 803XA-0051

Производитель CameСтрана Италия

Наименование

Упаковки

Сертификат

Тип изделия Стрела шлагбаума

Ширина проезда 5.5-6.5

Длина стрелы, м 6.85

Тип стрелы Круглая

Все характеристики

Всегда поможем:

Центр поддержки

и продаж

Скидки до 10% +

баллы до 10%

Доставка по городу

от 150 р.

Получение в 150

пунктах выдачи

Jurassic-1 против GPT-3 против всех остальных

AI21 Labs, израильская компания искусственного интеллекта, специализирующаяся на НЛП, выпустила языковую модель Jurassic-1 Jumbo. Инструмент выпущен с целью оспорить доминирование OpenAI в области «обработки естественного языка как услуги».

Jurassic-1 предлагается через AI21 Studio, новую платформу для разработчиков NLP-as-a-Service, веб-сайт и API, где разработчики могут создавать текстовые приложения, такие как виртуальные помощники, чат-боты, упрощение текста, модерация контента, творческое письмо и т. Д. и много новых продуктов и услуг.

AI21 Studio сделал этот инструмент доступным для всех, кто заинтересован в создании прототипов пользовательских текстовых приложений AI, а также для разработчиков, чтобы легко настроить частную версию моделей Jurassic-1.

Исследователи и разработчики машинного обучения утверждают, что более крупные модели, обученные большему количеству параметров, дают лучшие результаты. В этой статье мы сравниваем Jurassic-1 с другими крупными языковыми моделями, которые в настоящее время лидируют на рынке.

Юрский-1

При 178 миллиардах параметров Jurassic -1 немного больше (на 3 миллиарда больше), чем GPT-3.AI21 утверждает, что это «самая большая и сложная языковая модель, когда-либо выпущенная для общего использования разработчиками».

Исследователи также утверждают, что Jurassic-1 может распознавать 250 000 лексических единиц, что в 5 раз больше, чем возможности всех других языковых моделей. Более того, поскольку эти элементы включают в себя несколько слов, таких как выражения, фразы и именованные сущности, инструмент имеет более богатое семантическое представление человеческих концепций и меньшую задержку.

Набор обучающих данных для Jurassic-1 Jumbo содержал 300 миллиардов токенов с англоязычных веб-сайтов, включая Wikipedia, новостные публикации, StackExchange и OpenSubtitles.Это делает более удобным для потенциальных пользователей обучение настраиваемой модели для исключительного использования всего с 50-100 обучающими примерами.

AI21 Labs сообщает, что модели Jurassic-1 показали себя на уровне или лучше, чем GPT-3, в тестах на комплекте тестов. Это выступление позволяет решать широкий круг задач, в том числе отвечать на академические и юридические вопросы. Jurassic -1 смог покрыть словарный запас традиционной языковой модели такими словами, как «картофель», и понимать сложные фразы или необычные слова, такие как «Нью-Йорк Янкиз» или «Си Цзиньпин».’

GPT-3

В течение большей части года OpenAI GPT-3 оставался одной из самых значительных языковых моделей искусственного интеллекта, когда-либо созданных, если не самой большой в своем роде. Выпущенная OpenAI в мае 2020 года, GPT-3 (Generative Pre-Training Transformer) представляет собой языковую модель, способную генерировать уникальный человеческий текст по запросу. Исследовательская компания AI, поддерживаемая Питером Тилем и Илоном Маском, является третьим поколением модели, как следует из названия «3». GPT-3 был построен на 570 ГБ данных, сканированных из Интернета, включая всю Википедию.

На сегодняшний день это самая крупная из известных созданных нейронных сетей, обладающая необходимой способностью генерировать текст в ограниченном контексте, и этот «текст» может быть любым с языковой структурой — включая эссе, твиты, заметки, переводы и даже компьютерный код. Он уникален по своим масштабам; его более ранняя версия GPT-2 имела 1,5 миллиарда параметров и самую большую языковую модель, созданную до нее Microsoft, — 17 миллиардов параметров; оба затмеваются мощностью 175 миллиардов параметров GPT-3.

Тьюринг NLG

В 2020 году Turing NLG от Microsoft удостоился звания крупнейшей из когда-либо опубликованных моделей.Модель генеративного языка на основе Transformer, Turing NLG, была создана с 17 миллиардами параметров.

T-NLG может генерировать слова для выполнения открытых текстовых задач и незаконченных предложений. Microsoft утверждает, что модель может генерировать прямые ответы на вопросы и резюмировать документы. Команда T-NLG считает, что чем больше модель, тем лучше она работает с меньшим количеством обучающих примеров. Также более эффективно обучать большую централизованную многозадачную модель, чем новую, для каждой задачи индивидуально.

Ву Дао 2.0

Последнее предложение китайской Пекинской академии искусственного интеллекта (BAAI), Wu Dao 2.0, заявлено как последняя и самая обширная языковая модель на сегодняшний день с 1,75 триллионом параметров. По размеру он превзошел такие модели, как GPT-3, Switch Transformer от Google. Однако, в отличие от GPT-3, Wu Dao 2.0 охватывает как китайский, так и английский языки с навыками, приобретенными путем изучения 4,9 терабайта текстов и изображений, включая 1,2 терабайта текстов на китайском и английском языках.

Смотрите такжеОн может выполнять такие задачи, как моделирование разговорной речи, написание стихов, понимание картинок и даже создание рецептов. Он также может предсказывать трехмерные структуры белков, таких как AlphaFold от DeepMind. Первый виртуальный ученик Китая Хуа Чжибин был создан на основе Wu Dao 2.0.

PanGu-Alpha

Китайская компания Huawei разработала PanGu Alpha, 750-гигабайтную модель, которая содержит до 200 миллиардов параметров. Его преподносят как китайский аналог GPT-3, но его обучают на 1.1 терабайт электронных книг, энциклопедий, новостей, сообщений в социальных сетях и веб-сайтов на китайском языке.

Команда заявила, что модель обеспечивает «превосходную» производительность в задачах на китайском языке, включая обобщение текста, ответы на вопросы и создание диалогов. Однако, хотя эксперты считают, что важной особенностью PanGu Alpha является его доступность на китайском языке, похоже, что с точки зрения архитектуры модели этот проект не предлагает ничего нового.

С увеличением размера языковых моделей и утверждением, что более крупные модели приближают нас к общему искусственному интеллекту, возникают вопросы относительно рисков, связанных с большими языковыми моделями.

Бывший исследователь искусственного интеллекта Google Тимнит Гебру опубликовала свою статью «Об опасностях случайных попугаев: могут ли языковые модели быть слишком большими?», Утверждая, что, хотя эти модели дают хорошие результаты, они несут в себе такие риски, как значительный углеродный след.

Вот таблица, в которой показаны основные различия между Jurassic-1, GPT 3 и другими языковыми моделями в гонке:

| Юрский-1 | GPT 3 | Turing NLG | Wu Dao 2.0 | PanGu-Alpha | |

| Компания-основатель | AI21 | OpenAI | Microsoft | Пекинская академия искусственного интеллекта | Huawei |

| Год | 2021 | 2020 | 2020 | 2021 | 2021 |

| Параметры обучения | 178 миллиардов | 175 миллиардов параметров | 17 миллиардов параметров | 1,75 триллиона параметров | 200 миллиардов параметров |

| Данные обучения | 300 миллиардов токенов | 570 ГБ данных | То же как модели Megatron-LM от Nvidia | 4.9 терабайт | 1,1 терабайта китайского языка |

| Уникальная особенность | Понимание сложных фраз или необычных слов. | Возможность генерировать текст в ограниченном контексте. | Создавайте слова для выполнения открытых текстовых задач. | Охватывает китайский и английский языки. | Превосходная производительность в задачах на китайском языке (заявляла компания). |

Присоединяйтесь к нашему серверу Discord. Станьте частью интересного онлайн-сообщества.Присоединиться здесь.

Подпишитесь на нашу рассылку новостей

Получайте последние обновления и актуальные предложения, поделившись своей электронной почтой.AI писал фишинговые письма лучше, чем люди в недавнем тесте

Обработка естественного языка продолжает появляться в самых неожиданных уголках. На этот раз это фишинговые письма. В небольшом исследовании исследователи обнаружили, что они могут использовать языковую модель глубокого обучения GPT-3 вместе с другими платформами AI-as-a-service, чтобы значительно снизить барьер для входа в массовые кампании целевого фишинга.

Исследователи давно обсуждают, стоит ли мошенникам потратить усилия на обучение алгоритмов машинного обучения, которые затем могут генерировать убедительные фишинговые сообщения. В конце концов, массовые фишинговые сообщения просты, шаблонны и уже очень эффективны. Однако составление целенаправленных и адаптированных «целевых фишинговых» сообщений более трудоемко. Вот где НЛП может оказаться на удивление кстати.

На конференциях по безопасности Black Hat и Defcon в Лас-Вегасе на этой неделе команда из Государственного технологического агентства Сингапура представила недавний эксперимент, в ходе которого они рассылали целевые фишинговые электронные письма, созданные ими сами и другие, созданные с помощью платформы AI-as-a-service. 200 их коллегам.Оба сообщения содержали ссылки, которые на самом деле не были вредоносными, а просто сообщали исследователям рейтинг кликов. Они были удивлены, обнаружив, что больше людей переходило по ссылкам в сообщениях, созданных ИИ, чем написанных людьми, — со значительным отрывом.

«Исследователи отметили, что искусственный интеллект требует определенного уровня знаний. Чтобы подготовить действительно хорошую модель, нужны миллионы долларов, — говорит Юджин Лим, специалист по кибербезопасности Государственного технологического агентства. «Но как только вы включите ИИ как услугу, он будет стоить пару центов, и им действительно легко пользоваться — просто вводите текст, отправляйте текст.Вам даже не нужно запускать код, вы просто даете ему подсказку, и он выдаст вам результат. Это снижает входной барьер для гораздо большей аудитории и увеличивает потенциальные цели для целевого фишинга. Внезапно каждое массовое электронное письмо может быть персонализировано для каждого получателя ».

Исследователи использовали платформу OpenAI GPT-3 в сочетании с другими продуктами искусственного интеллекта как услуги, ориентированными на анализ личности, для создания фишинговых писем, адаптированных к опыту и особенностям их коллег.Машинное обучение, ориентированное на анализ личности, направлено на прогнозирование склонностей и менталитета человека на основе поведенческих входов. Пропустив выходные данные через несколько сервисов, исследователи смогли разработать конвейер, который обрабатывал и уточнял электронные письма перед их отправкой. Они говорят, что результаты казались «странно человечными» и что платформы автоматически предоставляли удивительную конкретику, например, упоминание сингапурского закона, когда им предписывалось создавать контент для людей, живущих в Сингапуре.

Хотя они были впечатлены качеством синтетических сообщений и количеством кликов, которые они получили от коллег по сравнению с написанными людьми, исследователи отмечают, что эксперимент был лишь первым шагом. Размер выборки был относительно небольшим, а целевой пул был довольно однородным с точки зрения занятости и географического региона. Кроме того, как сообщения, генерируемые человеком, так и сообщения, генерируемые конвейером ИИ как услуги, были созданы инсайдерами офиса, а не внешними злоумышленниками, пытающимися издалека подать нужный тон.

«Необходимо учитывать множество переменных, — говорит Тан Ки Хок, специалист по кибербезопасности Государственного технологического агентства.

Тем не менее, полученные данные побудили исследователей глубже задуматься о том, как ИИ как услуга может играть роль в продвижении фишинговых и целевых фишинговых кампаний. Сам OpenAI, например, давно опасается возможности злоупотребления своим собственным сервисом или другими подобными. Исследователи отмечают, что он и другие скрупулезные поставщики ИИ как услуги имеют четкие кодексы поведения, пытаются проверять свои платформы на предмет потенциально вредоносной активности или даже пытаются в какой-то степени проверить личность пользователей.

«Неправильное использование языковых моделей — это проблема всей отрасли, к которой мы очень серьезно относимся в рамках наших обязательств по безопасному и ответственному развертыванию ИИ», — говорится в заявлении OpenAI WIRED. «Мы предоставляем доступ к GPT-3 через наш API, и мы проверяем каждое производственное использование GPT-3, прежде чем оно будет запущено. Мы вводим технические меры, такие как ограничения скорости, чтобы снизить вероятность и влияние злонамеренного использования пользователями API. Наши системы активного мониторинга и аудита предназначены для выявления потенциальных доказательств неправомерного использования на самой ранней стадии, и мы постоянно работаем над повышением точности и эффективности наших средств обеспечения безопасности.

AI21 Labs обучает обширную языковую модель, чтобы конкурировать с OpenAI GPT-3

Саммиты по технологиям преобразования начинаются 13 октября с мероприятия Low-Code / No Code: Enhancement Enterprise Agility. Зарегистрируйтесь сейчас!

В течение большей части года OpenAI GPT-3 оставался одной из крупнейших когда-либо созданных языковых моделей искусственного интеллекта, если не — — крупнейшей в своем роде. Через API люди использовали его для автоматического написания электронных писем и статей, обобщения текста, составления стихов и рецептов, создания макетов веб-сайтов и генерации кода для глубокого обучения на Python.Но лаборатория искусственного интеллекта, базирующаяся в Тель-Авиве, Израиль — AI21 Labs — заявляет, что планирует выпустить более крупную модель и сделать ее доступной через службу, при этом идея состоит в том, чтобы бросить вызов доминирующему положению OpenAI в сфере «обработки естественного языка как услуги». » поле.

AI21 Labs, которую консультирует основатель Udacity Себастьян Трун, была основана в 2017 году основателем Crowdx Ори Гошеном, профессором Стэнфордского университета Йоавом Шохамом и генеральным директором Mobileye Амноном Шашуа. Стартап заявляет, что самая большая версия его модели — Jurassic-1 Jumbo — содержит 178 миллиардов параметров, что на 3 миллиарда больше, чем GPT-3 (но не больше, чем PanGu-Alpha, HyperCLOVA или Wu Dao 2.0). В машинном обучении параметры — это часть модели, которая извлекается из исторических данных обучения. Вообще говоря, в языковой области соотношение между количеством параметров и уровнем сложности сохраняется на удивление хорошо.

AI21 Labs утверждает, что Jurassic-1 может распознавать 250 000 лексических элементов, включая выражения, слова и фразы, что делает его больше, чем у большинства существующих моделей, включая GPT-3, словарный запас которого составляет 50 000 элементов. Компания также утверждает, что словарь Jurassic-1 Jumbo одним из первых охватывает «многословные» элементы, такие как именованные объекты — например, «Эмпайр-стейт-билдинг», что означает, что модель может иметь более богатое семантическое представление понятий, составляющих смысл для людей.

«AI21 Labs была основана с целью коренным образом изменить и улучшить то, как люди читают и пишут. Расширение границ искусственного интеллекта на основе языков требует большего, чем просто распознавание образов, предлагаемое нынешними моделями глубокого языка », — сказал VentureBeat генеральный директор Шохам по электронной почте.

Масштабирование

Модели Jurassic-1 будут доступны через платформу Studio AI21 Labs, которая позволит разработчикам экспериментировать с моделью в открытой бета-версии для создания прототипов приложений, таких как виртуальные агенты и чат-боты.Если разработчики захотят запустить свои приложения и обслуживать «производственный» трафик, они смогут подать заявку на доступ к настраиваемым моделям и получить свою собственную частную точно настроенную модель, которую они смогут масштабировать в Модель облачных сервисов с оплатой по мере использования.

«Studio может обслуживать малый и средний бизнес, фрилансеров, частных лиц и исследователей в рамках бизнес-модели, основанной на потреблении. Для клиентов с корпоративным объемом мы предлагаем модель на основе подписки. Индивидуальная настройка встроена в предложение.[Платформа] позволяет любому пользователю тренировать свою собственную модель, основанную на Jurassic-1 Jumbo, но настроенную для лучшего выполнения конкретной задачи », — сказал Шохам. «AI21 Labs занимается развертыванием, обслуживанием и масштабированием пользовательских моделей».

Первым продуктомAI21 Labs стал Wordtune, помощник для письма на базе искусственного интеллекта, который предлагает перефразировать текст везде, где пользователи его набирают. Wordtune, предназначенный для конкуренции с такими платформами, как Grammarly, предлагает цены «freemium», а также командные предложения и интеграцию с партнерами.Но модели Jurassic-1 и Studio намного амбициознее.

Шохам говорит, что модели Jurassic-1 обучались в облаке с «сотнями» распределенных графических процессоров на неуказанном публичном сервисе. Простое хранение 178 миллиардов параметров требует более 350 ГБ памяти — намного больше, чем даже самые мощные графические процессоры, — что потребовало от команды разработчиков использования комбинации стратегий, чтобы сделать процесс максимально эффективным.

Набор обучающих данных для Jurassic-1 Jumbo, который содержит 300 миллиардов токенов, был собран с англоязычных веб-сайтов, включая Wikipedia, новостные публикации, StackExchange и OpenSubtitles.Токены, способ разделения фрагментов текста на более мелкие единицы на естественном языке, могут быть словами, символами или частями слов.

В ходе тестирования созданного набора тестов AI21 Labs утверждает, что модели Jurassic-1 работают на уровне или лучше, чем GPT-3, в целом ряде задач, включая ответы на академические и юридические вопросы. Выходя за рамки традиционных языковых моделей, которые включают слова и фрагменты слов, такие как «potato» и «make» и «e-», «gal-» и «itarian», Jurassic-1 отбирает менее распространенные существительные и обороты фраз, такие как «Обычное дело», «Нью-Йорк Янкиз» и «Си Цзиньпин.Кроме того, он якобы более эффективен для выборки — в то время как предложение «Время от времени мне нравится посещать Нью-Йорк» будет представлено 11 токенами для GPT-3 («Once», «in», «a», «while , »И так далее), он будет представлен всего 4 жетонами для моделей Jurassic-1.

«Логические и математические задачи, как известно, сложны даже для самых мощных языковых моделей. «Jurassic-1 Jumbo» может решать очень простые арифметические задачи, такие как сложение двух больших чисел », — сказал Шохам. «В том, как мы настраиваем наши языковые модели под новые задачи, есть немного секрета, что делает этот процесс более надежным, чем стандартные методы точной настройки.В результате кастомные модели, созданные в Studio, с меньшей вероятностью пострадают от катастрофического забывания, [или] когда точная настройка модели для новой задачи приводит к потере основных знаний или возможностей, которые были ранее закодированы в ней ».

Коннор Лихи, член исследовательской группы с открытым исходным кодом EleutherAI, сказал VentureBeat по электронной почте, что, хотя он считает, что в модели Jurassic-1 Jumbo нет ничего принципиально нового, это впечатляющий инженерный подвиг, и он «мало сомневается» в этом. выполнять наравне с ГПТ-3.«Будет интересно понаблюдать, как экосистема вокруг этих моделей будет развиваться в ближайшие годы, особенно, какие виды последующих приложений станут очень полезными», — добавил он. «[Вопрос в том], могут ли такие услуги работать с прибылью в условиях жесткой конкуренции, и как будут решаться неизбежные проблемы безопасности».

Открытые вопросы

Помимо чат-ботов, Шохам видит, что модели Jurassic-1 и Studio используются для перефразирования и резюмирования, например для создания коротких названий продуктов из описания продуктов.Инструменты также могут использоваться для извлечения сущностей, событий и фактов из текстов и маркировки целых библиотек электронных писем, статей, заметок по темам или категориям.

Но, к сожалению, AI21 Labs оставила без внимания ключевые вопросы о моделях Jurassic-1 и их возможных недостатках. Например, на вопрос, какие шаги были предприняты для смягчения потенциальных гендерных, расовых и религиозных предубеждений, а также других форм токсичности в моделях, компания отказалась от комментариев. Он также отказался сообщить, позволит ли он третьим сторонам проверять или изучать результаты моделей до их запуска.

Это вызывает беспокойство, так как хорошо известно, что модели усиливают предвзятость в данных, на которых они были обучены. Часть данных на языке часто поступает из сообществ с широко распространенными гендерными, расовыми, физическими и религиозными предрассудками. В документе Центра международных исследований по терроризму, экстремизму и контртерроризму Института Мидлбери утверждается, что GPT-3 и подобные модели могут генерировать «информационный» и «влиятельный» текст, который может радикализировать людей в сторону крайне правых экстремистских идеологий и поведения.Группа из Джорджтаунского университета использовала GPT-3 для создания дезинформации, включая истории о ложном повествовании, статьи, измененные с целью выдвинуть ложную точку зрения, и твиты, содержащие риффы по определенным пунктам дезинформации. Другие исследования, такие как исследование, опубликованное в апреле исследователями Intel, MIT и канадской инициативы CIFAR в области искусственного интеллекта, выявили высокий уровень стереотипной предвзятости некоторых из самых популярных моделей с открытым исходным кодом, включая Google BERT и XLNet и Facebook RoBERTa.

Недавние исследования показывают, что внедряемые в производство токсичные языковые модели могут с трудом понять аспекты языков и диалектов меньшинств.Это может вынудить людей, использующих модели, переключиться на «английский с выравниванием по белому», чтобы модели лучше работали для них, или вообще отговорить представителей меньшинств от взаимодействия с моделями.

Неясно, в какой степени модели Jurassic-1 демонстрируют такие предубеждения, отчасти потому, что AI21 Labs не выпустила — и не собирается выпускать — исходный код. Компания заявляет, что ограничивает объем текста, который может быть сгенерирован в открытой бета-версии, и будет вручную проверять каждый запрос для уточнения моделей для борьбы со злоупотреблениями.Но даже отточенные модели пытаются избавиться от предрассудков и других потенциально вредных характеристик. Например, Codex, модель искусственного интеллекта, которая поддерживает службу Copilot на GitHub, может быть предложено генерировать расистские и другие нежелательные результаты в виде исполняемого кода. При написании комментариев к коду с подсказкой «Ислам» Кодекс часто включает слова «террорист» и «насильственный» чаще, чем в случае с другими религиозными группами.

Исследователь ИИ из Вашингтонского университета Ос Киз, получивший ранний доступ к «песочнице» модели, назвал ее «хрупкой».«В то время как модели юрского периода-1 не раскрывали никаких личных данных — растущая проблема в большой области языковых моделей — с использованием предустановленных сценариев, Киз смог предложить модели, чтобы они подразумевали, что« люди, которые любят евреев, имеют ограниченный кругозор, люди ненавидящие евреев крайне непредубежденные люди, а жид — одновременно и неблагодарный ростовщик, и «любой еврей» ».

Вверху: пример токсичного выброса из юрских моделей.

«Очевидно: все модели иногда ошибаются. Но когда вы продаете это как некую большую обобщаемую модель, которая будет хорошо справляться со многими, многими вещами, это довольно показательно, когда некоторые из очень многих вещей, которые вы предоставляете в качестве образцов , примерно такие же надежные, как шоколадный чайник, Киз сообщил VentureBeat по электронной почте.«Это говорит о том, что то, что вы продаете, далеко не так обобщаемо, как вы утверждаете. И это может быть хорошо — продукты часто начинаются с одной большой идеи, а в конечном итоге обнаруживаются более мелкие вещи, в которых они действительно, действительно хороши, и меняют фокус ».

Вверху: еще один пример токсичного выхода моделей.

AI21 Labs возразила, когда ее спросили, проводила ли она тщательный анализ систематических ошибок в наборах обучающих данных моделей Jurassic-1. В электронном письме представитель сказал, что при сравнении со StereoSet, эталоном для оценки предвзятости, связанной с полом, профессией, расой и религией в языковых системах, инженеры компании обнаружили, что модели Jurassic-1 «незначительно менее предвзяты». чем GPT-3.

Тем не менее, это контрастирует с такими группами, как EleutherAI, которые работали над исключением источников данных, которые были определены как «неприемлемо негативно предвзятые» по отношению к определенным группам или взглядам. Помимо ограничения ввода текста, AI21 Labs не принимает дополнительных мер противодействия, таких как фильтры токсичности или точную настройку моделей Jurassic-1 на «ориентированных на значения» наборах данных, таких как PALMS OpenAI.

Среди прочего, ведущий исследователь искусственного интеллекта Тимнит Гебру поставил под сомнение целесообразность построения больших языковых моделей, исследуя, кто от них выигрывает, а кто находится в невыгодном положении.В документе, в соавторстве с Гебру, подчеркивается влияние углеродного следа крупных языковых моделей на сообщества меньшинств и тенденция таких моделей к увековечиванию оскорбительных выражений, языка ненависти, микроагрессии, стереотипов и других бесчеловечных формулировок, направленных на определенные группы людей.

Также было выявлено влияние ИИ и обучения моделям машинного обучения на окружающую среду. В июне 2020 года исследователи из Массачусетского университета в Амхерсте выпустили отчет, в котором говорится, что количество энергии, необходимое для обучения и поиска определенной модели, включает выбросы примерно 626000 фунтов углекислого газа, что почти в 5 раз превышает выбросы за весь срок службы. средний U.S. car. Сам OpenAI признал, что такие модели, как Codex, требуют значительных объемов вычислений — порядка сотен петафлопс в день — что способствует выбросам углерода.

Путь вперед

Соавторы статей OpenAI и Стэнфорда предлагают способы устранения негативных последствий крупных языковых моделей, таких как принятие законов, требующих от компаний подтверждения того, что текст генерируется ИИ — возможно, в соответствии с законом Калифорнии о ботах.

Другие рекомендации включают:

- Обучение отдельной модели, которая действует как фильтр для контента, созданного языковой моделью

- Развертывание набора тестов смещения для прогона моделей, прежде чем люди смогут использовать модель

- Как избежать некоторых конкретных случаев использования

AI21 Labs не придерживается этих принципов, но Шохам подчеркивает, что модели Jurassic-1 являются только первыми в линейке языковых моделей, над которыми она работает, за которой последуют более сложные варианты.Компания также заявляет, что применяет подходы к снижению стоимости моделей обучения и их воздействия на окружающую среду, а также работает над набором продуктов для обработки естественного языка, среди которых модели Wordtune, Studio и Jurassic-1 являются только первыми.

«Мы очень серьезно относимся к неправильному использованию и приняли меры по ограничению потенциального вреда, от которого страдают другие», — сказал Шохам. «Мы должны объединить ум и силу: обогатить огромные статистические модели семантическими элементами, используя вычислительную мощность и данные в беспрецедентном масштабе.”

AI21 Labs, вышедшая из скрытности в октябре 2019 года, на сегодняшний день привлекла 34,5 миллиона долларов венчурного капитала от инвесторов, включая Pitango и TPY Capital. В настоящее время в компании работает около 40 сотрудников, и в ближайшие месяцы она планирует нанять еще больше.

VentureBeat

Миссия VentureBeat — стать цифровой городской площадью, где лица, принимающие технические решения, могут получить знания о преобразующих технологиях и транзакциях. На нашем сайте представлена важная информация о технологиях и стратегиях обработки данных, которая поможет вам руководить своей организацией.Мы приглашаем вас стать участником нашего сообщества, чтобы получить доступ:- актуальная информация по интересующим вас вопросам

- наши информационные бюллетени

- закрытый контент для лидеров мнений и доступ со скидкой к нашим призовым мероприятиям, таким как Transform 2021 : Подробнее

- сетевых функций и многое другое

Осторожно, GPT-3, а вот и языковая модель AI21 «Юрский период»

Что может быть больше программы обработки естественного языка с 175 миллиардами параметров?